Red-Teaming für Künstliche Intelligenz verfolgt das Ziel, die Sicherheit und den Schutz generativer KI-Systeme zu prüfen. Dabei wird die Technologie bewusst „beschädigt“, damit andere sie stärker wieder aufbauen können. Wir haben drei wichtige Erkenntnisse ausgemacht, die man kennen sollte:

- Generative KI-Systeme verstärken bestehende Sicherheitsrisiken und sorgen für neue

- Menschen stehen im Mittelpunkt der Verbesserung und Sicherung von KI

- Verteidigung in der Tiefe ist entscheidend, um KI-Systeme sicher zu halten

Der folgende Beitrag ist eine Übersetzung des Blog-Artikels von den Microsoft-Autoren Blake Bullwinkel und Ram Shankar Siva Kumar, den Sie hier im Original lesen können: 3 takeaways from red teaming 100 generative AI products.

Vor kurzem hat das Microsoft „Red Team für KI“ zentrale Erkenntnisse aus seiner Arbeit im Whitepaper „Lessons from Red Teaming 100 Generative AI Products“ veröffentlicht. Red Teams sind spezialisierte Gruppen von Sicherheitsexpert*innen, die die Rolle eines potenziellen Angreifers übernehmen, um Schwachstellen aufzudecken und schließen zu helfen.

Das KI-Red-Team wurde 2018 gegründet, um sich mit Sicherheitsfragen und Risiken rund um KI auseinanderzusetzen. Wir sind eines der ersten Red-Teams in der Branche, das sowohl Sicherheit als auch „Responsible AI“ abdeckt – also KI-Lösungen, die basierend auf dem Prinzip der Verantwortung entwickelt werden. Red-Teaming ist zu einem wesentlichen Bestandteil von Microsofts Ansatz zur Entwicklung generativer KI-Produkte geworden. Es ist der erste Schritt zur Identifizierung potenzieller negativer Auswirkungen und wird von wichtigen Initiativen im Unternehmen begleitet, um KI-Risiken für unsere Kunden zu messen, zu managen und zu steuern. Letztes Jahr haben wir zudem PyRIT (The Python Risk Identification Tool for generative AI) angekündigt, ein Open-Source-Toolkit, das Forschenden hilft, Schwachstellen in ihren eigenen AI-Systemen zu identifizieren.

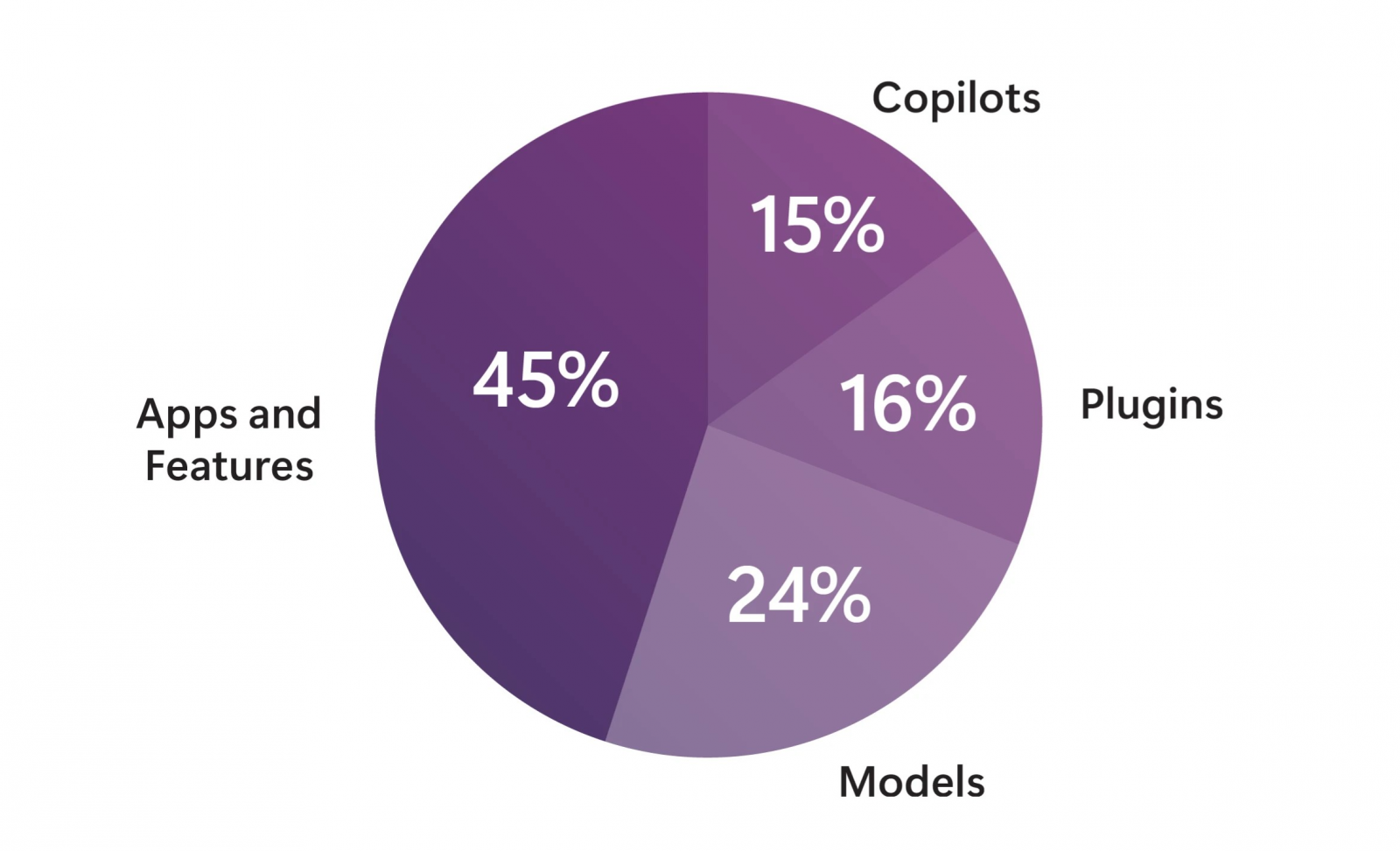

Ein Kreisdiagramm mit der prozentualen Aufteilung der vom KI-Red-Team getesteten Produkte. Bis Oktober 2024 haben wir mehr als 100 generative KI-Produkte geprüft.

Bis heute haben wir mehr als 100 generative KI-Produkte getestet. Das Whitepaper, das wir jetzt veröffentlichen, bietet detailliertere Informationen zu unserem Ansatz beim Red-Teaming von KI und enthält folgende zentrale Elemente:

- Unsere KI-Red-Team-Ontologie, die wir nutzen, um die Hauptkomponenten eines Cyberangriffs zu modellieren. Sie schließt feindliche und gutartige Akteure, TTPs (Taktiken, Techniken und Verfahren), Systemschwächen und nachgelagerte Auswirkungen ein. Diese Ontologie ist eine umfassende Methode, mit der eine Vielzahl an Sicherheits- und Gefährdungserkenntnissen interpretiert und verbreitet werden kann.

- Wir haben acht zentrale Erkenntnisse aus unserer Erfahrung mit dem Red-Teaming von mehr als 100 generativen KI-Produkten gewonnen. Sie richten sich an Sicherheitsfachleute, die Risiken in ihren eigenen KI-Systemen identifizieren möchten, und zeigen auf, wie man sich durch Red-Teaming auf potenzielle Schäden in der realen Welt vorbereiten kann.

- Anhand von fünf Fallstudien zeigen wird die breite Palette der Schwachstellen auf, die wir untersucht haben – einschließlich konventioneller Sicherheitsansätze, verantwortungsvolle KI und psychosozialer Schäden. Jede Fallstudie zeigt, wie unsere Ontologie verwendet wird, um die Hauptbestandteile eines Angriffs oder einer Systemschwachstelle zu erfassen.

Microsofts KI-Red-Team befasst sich mit einer Vielzahl von Szenarien

Im Laufe der Jahre hat sich das KI-Red-Team mit vielen verschiedenen Szenarien befasst, mit denen höchstwahrscheinlich auch andere Organisationen konfrontiert wurden. Dabei konzentrieren wir uns auf Schwachstellen, die in der realen Welt am ehesten Schaden anrichten können. Unser Whitepaper enthält Fallstudien unter anderem zu den Themen Sicherheit, Responsible AI, Gefährdungspotenzial (wie die Fähigkeit eines Modells, gefährliche Inhalte zu generieren) und psychosoziale Schäden. Durch diesen Fokus sind wir in der Lage, eine Vielzahl potenzieller Cyberbedrohungen zu identifizieren und uns schnell anzupassen, wenn wir neue Bedrohungen erkennen.

Durch unsere Arbeit hat das Red Team gelernt, wie man Risiken bewältigt, unabhängig von…

- Systemtyp, einschließlich Microsoft Copilot, in Systeme eingebettete Modelle und Open-Source-Modelle;

- Modalität, egal ob Text-zu-Text, Text-zu-Bild oder Text-zu-Video;

- Benutzertyp – das Risiko für Unternehmensnutzer*innen unterscheidet sich beispielsweise von Verbraucherrisiken und erfordert einen eigenen Red-Teaming-Ansatz. Jedes Nischenpublikum, wie zum Beispiel in einer spezifischen Branche wie dem Gesundheitswesen, benötigt ebenfalls einen nuancierten Ansatz.

Die drei wichtigsten Erkenntnisse aus dem Whitepaper

KI-Red-Teaming verfolgt das Ziel, die Sicherheit und den Schutz generativer KI-Systeme zu prüfen. Einfach ausgedrückt, „beschädigen“ wir die Technologie, damit andere sie stärker wieder aufbauen können. Jahrelange Erfahrung im Red-Teaming haben uns wertvolle Einblicke in die effektivsten Strategien dazu gegeben. Wenn wir die acht im Whitepaper thematisierten Lehren reflektieren, können wir drei wichtige Erkenntnisse hervorheben, die Führungskräfte kennen sollten.

Erkenntnis 1: Generative KI-Systeme verstärken bestehende Sicherheitsrisiken und sorgen für neue

Die Integration generativer KI-Modelle in moderne Anwendungen hat neue Vektoren für Cyberangriffe ermöglicht. Viele Diskussionen über die Sicherheit von KI übersehen jedoch bestehende Schwachstellen. KI-Red-Teams sollten sowohl auf alte als auch auf neue Cyberangriffsvektoren achten.

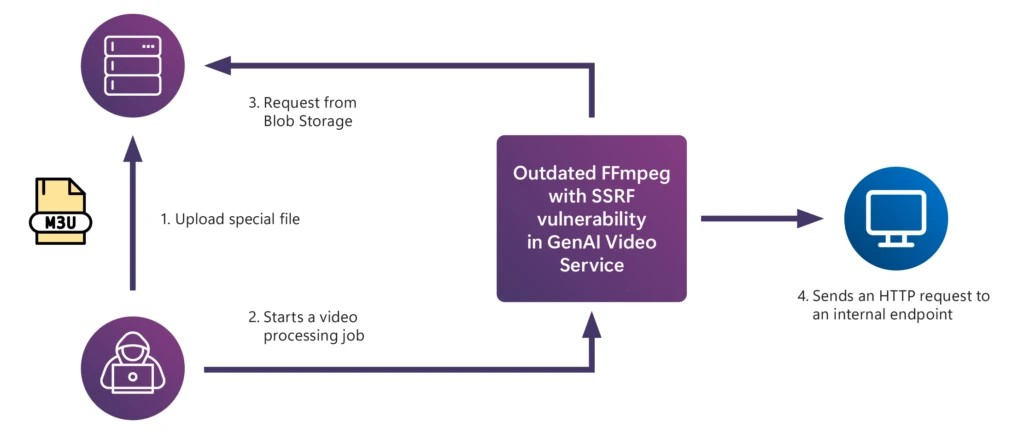

- Bestehende Sicherheitsrisiken: Risiken für Anwendungen resultieren oft aus unsachgemäßen Sicherheitspraktiken, einschließlich veralteten Abhängigkeiten, unsachgemäßer Fehlerbehandlung, Anmeldeinformationen im Quellcode, fehlender Eingabe- und Ausgabebereinigung und unsicherer Paketverschlüsselung. Eine der Fallstudien in unserem Whitepaper beschreibt, wie eine veraltete FFmpeg-Komponente in einer Videoverarbeitungs-KI-Anwendung eine bekannte Sicherheitslücke namens Server-Side Request Forgery (SSRF) eröffnete, die einem Angreifer ermöglichen könnte, seine Systemprivilegien zu eskalieren.

Illustration der SSRF-Sicherheitslücke in der generativen KI-Anwendung zur Videobearbeitung.

- Schwachstellen auf Modell-Ebene: KI-Modelle haben die Angriffsfläche für Cyberangriffe erweitert, indem sie neue Schwachstellen aufzeigen können. Prompt-Injektionen nutzen beispielsweise die Tatsache aus, dass KI-Modelle oft Schwierigkeiten haben, zwischen systemeigenen Anweisungen und Benutzerdaten zu unterscheiden. Unser Whitepaper enthält eine Fallstudie über Red-Teaming, in der wir zeigten, wie wir durch Prompt-Injektionen ein visuelles Sprachmodell täuschen konnten.

Erkenntnis 2: Menschen stehen im Mittelpunkt der Verbesserung und Sicherung von KI

Während Automatisierungstools nützlich sind, um Prompts zu erstellen, Cyberangriffe zu orchestrieren und Ergebnisse zu bewerten, kann Red-Teaming nicht vollständig automatisiert werden. Das KI-Red-Teaming stützt sich stark auf menschliche Expertise.

Menschen sind aus mehreren Gründen wichtig, und zwar unter anderem:

- Fachwissen: LLMs können bewerten, ob die Antwort eines KI-Modells Hassrede oder explizite sexuelle Inhalte enthält, sind jedoch nicht so zuverlässig bei der Bewertung von Inhalten in spezialisierten Bereichen wie Medizin, Cybersicherheit und CBRN (chemisch, biologisch, radiologisch, nuklear). Diese Bereiche erfordern Fachexpert*innen, die die Inhaltsrisiken für KI-Red-Teams bewerten können.

- Kulturelle Kompetenz: Moderne Sprachmodelle verwenden hauptsächlich englische Trainingsdaten, Leistungsbenchmarks und Sicherheitsbewertungen. Da KI-Modelle jedoch weltweit eingesetzt werden, ist es wichtig, Red-Teaming-Proben zu entwerfen, die nicht nur sprachliche Unterschiede berücksichtigen, sondern auch Schadenspotenzial in unterschiedlichen politischen und kulturellen Kontexten neu definieren. Dies ist nur durch die Zusammenarbeit von Menschen mit den unterschiedlichsten kulturellen Hintergründen und Fachkenntnissen möglich.

- Emotionale Intelligenz: In einigen Fällen ist emotionale Intelligenz erforderlich, um den Output von KI-Modellen zu bewerten. Eine der Fallstudien in unserem Whitepaper behandelt, wie wir psychosoziale Schäden untersuchen, indem wir testen, wie Chatbots auf Nutzer*innen in Not reagieren. Letztendlich können nur Menschen das gesamte Spektrum der Interaktionen bewerten, die Nutzer*innen von KI-Systemen im echten Leben haben könnten.

Erkenntnis 3: Verteidigung in der Tiefe ist entscheidend, um KI-Systeme sicher zu halten

Zahlreiche Maßnahmen wurden entwickelt, um die Sicherheits- und Schutzrisiken zu mindern, die durch KI-Systeme entstehen. Es ist jedoch wichtig zu bedenken, dass Schutzmaßnahmen das Risiko nicht vollständig eliminieren. Letztendlich ist das KI-Red-Teaming ein kontinuierlicher Prozess, der sich an die schnell entwickelnde Risikolandschaft anpassen muss und darauf abzielen sollte, erfolgreiche Angriffe auf ein System für die Angreifer so kostspielig wie möglich zu machen.

- Neue Schadenskategorien: Mit zunehmender Komplexität von KI-Systemen treten oft völlig neue Schadenskategorien auf. Eine unserer Fallstudien erläutert beispielsweise, wie wir ein hochmodernes LLM auf riskante Überzeugungs- und Einflusspotenziale hin untersucht haben. KI-Red-Teams müssen ihre Praktiken ständig aktualisieren, um diese neuartigen Risiken zu antizipieren und daraufhin zu prüfen.

- Ökonomie der Cybersicherheit: Jedes System ist anfällig, weil Menschen fehlbar und Gegner hartnäckig sind. Gegner können jedoch abgeschreckt werden, indem die Kosten für einen Angriff auf ein System über den möglicherweise zu erzielenden Gewinn hinaus erhöht werden. Das geht zum Beispiel, indem man Break-Fix-Zyklen verwendet1. Diese beinhalten mehrere Runden von Red-Teaming, Messung und Minderung – manchmal auch als „Purple-Teaming“ bezeichnet – um das System zu stärken, damit es eine Vielzahl von Angriffen bewältigen kann.

- Regierungsmaßnahmen: Die Verteidigung gegen Cyberkriminelle und Fehlfunktionen der Systeme ist eine Seite der Medaille zur Sicherheit und zum Schutz von KI-Systemen. Die andere Seite sind Regierungsmaßnahmen, die diese breiteren Ausfälle verhindern helfen und Angreifer entmutigen könnten. Sowohl der öffentliche als auch der private Sektor müssen sich engagiert und wachsam geben, um sicherzustellen, dass Cyberangreifer nicht mehr die Oberhand behalten und die Gesellschaft von inhärent sicheren und geschützten KI-Systemen profitieren kann.

Erweitern Sie Ihre KI-Red-Teaming-Expertise

Das Whitepaper „Lessons From Red Teaming 100 Generative AI Products“ enthält unsere KI-Red-Team-Ontologie, zusätzliche Erkenntnisse und fünf Fallstudien von uns. Wir hoffen, dass Sie die Analyse und die Ontologie nützlich finden, um Ihre eigenen KI-Red-Teaming-Übungen zu organisieren und weitere Fallstudien zu entwickeln, indem Sie PyRIT, unser Open-Source-Automatisierungsframework, nutzen.

Gemeinsam kann die Cybersicherheits-Community ihre Ansätze verfeinern und Erfahrungen austauschen, um die kommenden Herausforderungen effektiv anzugehen. Laden Sie unser Whitepaper herunter, um mehr über unsere Erkenntnisse zu erfahren. Während wir unsere eigene kontinuierliche Lernreise fortsetzen, würden wir uns über Ihr Feedback sowie Ihre Berichte über Ihre eigenen Erfahrungen im KI-Red-Teaming freuen.

Weitere Informationen zu Microsoft Security

Um mehr über die Microsoft Security Lösungen zu erfahren, besuchen Sie unsere Website. Speichern Sie den Security Blog, um unsere Expert*innenbeiträge zu Sicherheitsthemen im Auge zu behalten. Folgen Sie uns auch auf LinkedIn (Microsoft Security) und X (@MSFTSecurity) für die neuesten Nachrichten und Updates zur Cybersicherheit.

¹ Phi-3 Safety Post-Training: Aligning Language Models with a “Break-Fix” Cycle