Hablar, escuchar, conversar: La larga búsqueda por una tecnología que entienda el habla tan bien como lo hace un humano

Sentado en su oficina con vista al centro de Bellevue en Washington, Fil Alleva de Microsoft platica sobre el largo en ocasiones complicado camino que él y otros expertos en reconocimientos del habla han tomado a partir del trabajo temprano de los años setenta a la situación en la que se encuentra hoy en día, donde puede ir a su computadora y decirle, “Cortana, quiero una pizza”, y obtener resultados.

La conversación cambia de manera rápida hacia la tecnología que hace posible algo como esto, y luego Alleva hace una pausa.

“Lo que todos teníamos en la parte trasera de nuestras mentes, lo dijéramos o no, era C-3PO”, admite con una sonrisa.

El amigable personaje de “Star Wars” que puede entender y hablar millones de idiomas tal vez no haya sido la única inspiración para los investigadores líderes a nivel mundial – algunos otros podrían decir que el traductor universal que se utilizaba con frecuencia en “Star Trek” fue el que impulsó sus sueños.

Pero sin importar si eran fanáticos de “Star Wars” o leales seguidores de “Star Trek”, una cosa está clara: La búsqueda para crear una computadora que pueda entender el idioma hablado tan bien como una persona, fue por años una fantasía que sólo se comparaba con la ciencia ficción.

En la actualidad, una consola de juegos que entienda comandos de voz, aplicaciones que puedan traducir su conversación en tiempo real y una asistente virtual que les brinda los números de las pizzerías cercanas son de hecho, todo menos ficción.

Estos sistemas no sólo existen, también mejoran cada día gracias a las mejoras en disponibilidad de datos, poder de cómputo y un sub-campo de la inteligencia artificial llamado aprendizaje de máquina, en el que los sistemas mejoran conforme toman más datos.

Algunos investigadores ahora creen que, en sólo unos pocos años, estas tecnologías podrían llegar a un punto donde las computadoras puedan entender las palabras que la gente dice tan bien como lo haría otra persona.

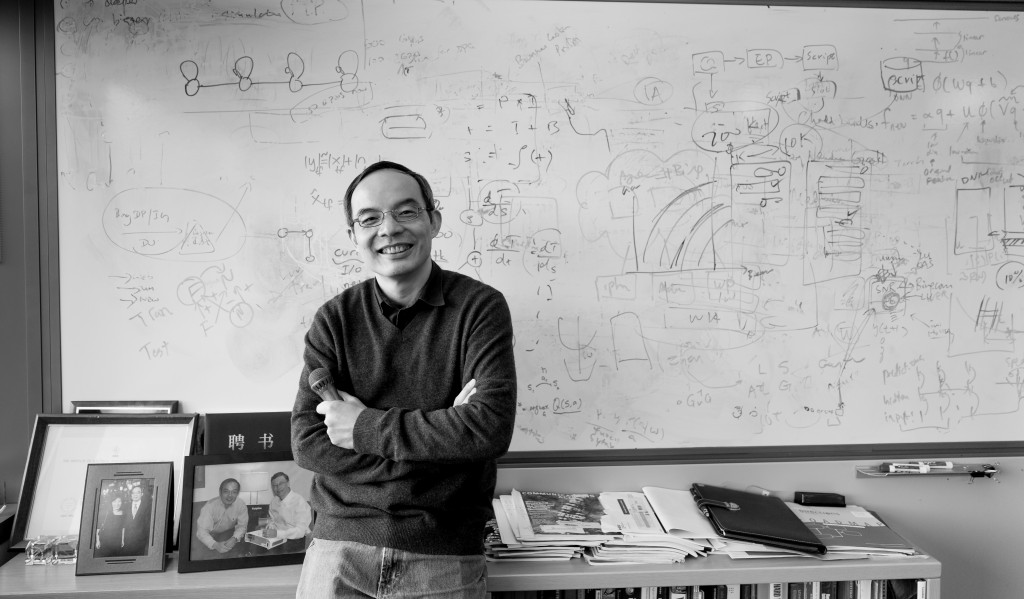

“Estamos llegando a ese punto de inflexión”, comentó Xuedong Huang, el científico del habla en jefe de la empresa, que, junto con Alleva, ha sido una fuerza de liderazgo en investigación de habla e implementación de producto en Microsoft.

Las mejoras ya han cambiado de manera fundamental la manera en que utilizamos la tecnología. Tal vez dictamos mensajes de texto en lugar de escribirlos o hablamos a nuestra aplicación FPS favorita en lugar de teclear la dirección mientras manejamos por la autopista.

Cortana, la asistente virtual de Microsoft, ahora está al frente y al centro en Windows 10 e invita a los usuarios “Pregúntame lo que sea”, lo que la ha convertido en lo que Satya Nadella, CEO de Microsoft ha descrito como “un tercer tiempo de ejecución”. Todo esto ha cumplido un sueño que Huang tuvo desde que fue contratado para iniciar las iniciativas de habla de Microsoft en 1993.

‘Es tan natural’

Tal vez lo más destacado del éxito del reconocimiento del habla es que hemos comenzado a utilizar el reconocimiento de voz de manera instintiva, sin pensar, y con la expectativa de que funcionará para nosotros.

“Cuando el aprendizaje de máquina trabaja con todo, no es necesario ver el esfuerzo. Es tan natural. Ustedes pueden ver el resultado”, comenta Harry Shum, Vicepresidente Ejecutivo a cargo del grupo de Tecnología e Investigación en Microsoft.

También aumenta las tentadoras posibilidades de mejorar la comunicación y la productividad y también facilitar nuestras vidas.

Consideren lo siguiente: Hasta hace poco, si un angloparlante que no conocía una sola palabra de mandarín quería hablar con alguien que vive en China, tenían que enfrentar la abrumadora tarea de aprender lo suficiente del idioma para poder comunicarse o contratar a otra persona que tradujera la conversación para ellos.

Hoy en día, ellos pueden simplemente tener una conversación, en tiempo real, con Skype Translator.

La posibilidad de llevar a cabo una conversación en dos idiomas diferentes y ver los gestos y expresiones faciales de la otra persona, en tiempo real, es una de las muchas maneras en las que la traducción instantánea se ha vuelto más y más popular.

“La barrera del idioma no existirá de manera esencial en cuatro años, para los idiomas y escenarios principales”, comentó Arul Menezes, que dirige el equipo de Traducción de Máquina en Microsoft Research.

Es una idea increíble y algo que los expertos en lenguaje han esperado, impacientes, por años. Menezes comenzó a trabajar en la primera versión de Microsoft Translator mientras se encontraba en descanso de paternidad por el nacimiento de su hija. Ella ahora está en la secundaria.

“Todos lo imaginamos. Sólo no sabíamos que tomaría tanto tiempo ponerlo a funcionar”, comenta.

Algunos logros y una gran cantidad de arduo trabajo

Menezes es miembro de un bastante grande club de investigadores e ingenieros que ha estado involucrado en el reconocimiento del habla y mejoras en traducción por décadas.

Otro es Huang. Cuando él ingresó a la universidad en China a principios de los ochenta, apenas se había presentado la primera PC y los usuarios chinos ya veían una importante limitación. Tan sólo el idioma chino, con sus tantos caracteres y variantes, no era propicio para ser utilizado en un teclado tradicional.

Huang – que mucha gente lo identifica como un optimista por naturaleza – pensó que un ajuste podría ser bastante sencillo.

“Pensé que podía resolver el problema con mi tesis para el doctorado, al entregar un increíble motor de dictado en chino que corría en PC IBM”, mencionó Huang.

De cierto modo, Huang todavía trabaja en ese mismo problema escolar, pero tiene más optimismo que nunca de que la solución está cercana.

“La tecnología de habla está tan cerca al nivel del desempeño humano”, comentó. “Creo que en los próximos tres años estaremos emparejados”.

Si le preguntan a Huang, Alleva o Shum por qué han mejorado tanto los modelos de reconocimiento del habla, ellos no les comentará sobre un momento en específico. En lugar de eso, ellos mencionan una mejora aquí, un logro allá y esos increíbles momentos cuando todo se unió gracias a una gran cantidad de trabajo.

“En particular, en la investigación podemos tomar un enfoque a largo plazo”, comentó Shum. “La investigación es un maratón”.

Datos, poder computacional y aprendizaje de máquina

Los ingredientes básicos para un increíble reconocimiento del habla no han cambiado mucho en las décadas desde que Huang, Alleva y Shum se conocieron por primera vez mientras estudiaban en la Universidad Carnegie Mellon – pero han mejorado mucho.

Lo primero que se necesita son datos. Para que una computadora aprenda a identificar sonidos necesita grandes cantidades de ejemplos de los que pueda aprender. Conforme más gente utiliza herramientas como Skype Translator o Cortana, esas herramientas son capaces de mejorar más y más porque tienen más ejemplos de donde aprender. Huang llama a este influjo de uso el oxígeno que alimenta a las mejoras en reconocimiento del habla.

El segundo ingrediente es poder computacional. No hace mucho, esto estaba limitado a cualquier cosa que una persona tuviera en su computadora personal o dispositivo móvil. Ahora, gracias al cómputo en la nube, hay, de manera exponencial, más poder computacional que nunca para el reconocimiento del habla, incluso si es invisible para ustedes.

Por último, ustedes necesitan grandes algoritmos de aprendizaje de máquina. Con el tiempo, los expertos del habla han utilizado muchas herramientas para el aprendizaje del habla, con exóticos nombres como Modelos de Mezcla Gaussiana y Modelos de Markov Ocultos. Hace unos años, Microsoft y otros investigadores dieron con la idea de utilizar una herramienta llamada redes neurales profundas para entrenar a las computadoras a que entiendan mejor el habla.

Las redes neurales profundas no eran nuevas, pero sí la manera de utilizarlas. La técnica funcionaba muy bien, y ahora los investigadores aplican la misma tecnología a otras áreas del cómputo como visión de computadora, traducción de máquina, reconocimiento de imagen y titulado automático de imagen.

¡Cierto! ¿Cierto? ¡Cierre!

En este punto, comentan los investigadores, los mayores obstáculos en hacer que una computadora entienda el habla tan bien como un humano se relacionan con los retadores ambientes que los humanos encuentran.

“En algunas circunstancias controladas, ya contamos con una excelente calidad de reconocimiento del habla”, dijo Geoffrey Zweig, que maneja el grupo de habla y diálogo en Microsoft Research. “En otras, aún hay un largo camino por recorrer”.

Las herramientas de reconocimiento del habla todavía no lo hacen muy bien en lugares ruidosos, con mucha gente o con eco, y no son tan buenas con hardware pobre como micrófonos de baja calidad o que la gente hable de una distancia considerable. También pueden sufrir cuando la gente habla muy rápido o muy bajo o tiene acento. En ocasiones también es complicado para que las computadoras entiendan a niños o personas mayores.

Microsoft trata de enfrentar ese problema con tecnología como los Servicios Personalizados de Reconocimiento Inteligente de Microsoft Project Oxford, una herramienta que está por llegar que permite a los desarrolladores construir productos que lidien con ese tipo de retos.

Después se encuentra el obstáculo más grande: La comprensión

El acto de entender lo que alguien dice es muy diferente a comprender las sutiles diferencias del habla de las personas. Al mismo tiempo que los investigadores perfeccionan el entendimiento del lenguaje, también trabajan en un problema más matizado. Ayudar a las computadoras a entender cuándo una persona grita de manera entusiasta “¡Cierto!” o cuando murmura de manera sarcástica “¿Cierto?” o sugiere a alguien de manera brusca que “¡Cierre!”.

“La gente normal, cuando piensa en reconocimiento de habla quiere todo”, comentó Hsiao-Wuen Hon, director general de Microsoft Research Asia y también un renombrado investigador del habla. “Ellos quieren reconocimiento, quieren entendimiento y quieren que una acción se lleve a cabo”.

Hon comentó que no sólo tienen que resolver el reconocimiento del habla, también necesitan resolver el lenguaje natural, texto a habla, planeación y ejecución de acción. Hon se refiere a esto como un sistema que tiene una “Inteligencia Artificial completa”.

Por lo menos hasta ahora, los humanos son mejores que las computadoras para entender esas sutiles señales. Los científicos computacionales en Microsoft y en otras partes atacan este procesamiento natural del idioma de la misma manera en la que fueron tras el reconocimiento del habla –reuniendo datos y ayudando a que las computadoras aprendan de ellos.

Aun así, es un reto mayor en parte debido a que las reglas del entendimiento del lenguaje natural son vagas. Como destaca Hon, los humanos no siempre quieren decir lo que dicen. De hecho, se podría argumentar que una de las cosas más complicadas sobre ser humano es descubrir lo que la otra persona trata de comunicarnos, y que ellos entiendan lo que nosotros queremos decirles.

“Muchas veces decimos que incluso la gente que es más cercana a nosotros no nos entiende”, mencionó Hon.

Escuchar, pero también ver e incluso utilizar el anticuado tecleo

No importa qué tan buenos nos volvamos para crear herramientas que entiendan el habla, nadie espera que la gente abandone por completo el teclado. Esto es debido a que el habla tiene limitaciones: No es privada, por ejemplo y cualquiera que haya tratado de dictar un documento sabe que no siempre es propicio para el proceso creativo.

Tampoco es un reflejo exacto de cómo los humanos en realidad se comunican, no solo con sus palabras sino también con pistas no habladas como expresiones y gestos faciales.

Conforme los expertos en habla continúan en la búsqueda de resolver el problema del entendimiento del habla, también piensan más y más sobre el rol que juega el habla en esta meta mayor: Crear tecnología que entienda el lenguaje pero que también haga cosas como reconocer rostros y responder a gestos.

“Mucho de esto dependerá de construir el habla dentro de un sistema”, comentó Alleva. “Hay un uso para estas cosas de manera aislada, pero hay muchos más usos de manera exponencial cuando se juntan”.

Imagen principal: Fil Alleva, a la izquierda, gerente del grupo de ingeniería en Microsoft y Xuedong Huang, a la derecha, científico en jefe del habla en Microsoft, han sido las fuerzas motoras en la investigación del habla y el desarrollo de producto en Microsoft. (Foto por Scott Eklund/Red Box Pictures).