A medida que los avances informáticos y de IA que abarcan décadas ofrecen oportunidades increíbles para las personas y la sociedad, también plantean preguntas sobre el desarrollo y la implementación responsables. Por ejemplo, es posible que los modelos de aprendizaje automático que impulsan los sistemas de IA no funcionen de la misma manera para todos o en todas las condiciones, lo que podría generar daños relacionados con la seguridad, la confiabilidad y la equidad. Las métricas únicas que a menudo se usan para representar la capacidad del modelo, como la precisión general, hacen poco para demostrar en qué circunstancias o para quién es más probable que falle; mientras tanto, los enfoques comunes para abordar las fallas, como agregar más datos y computar o aumentar el tamaño del modelo, no llegan a la raíz del problema. Además, estos enfoques generales de prueba y error pueden requerir muchos recursos y ser costosos a nivel económico.

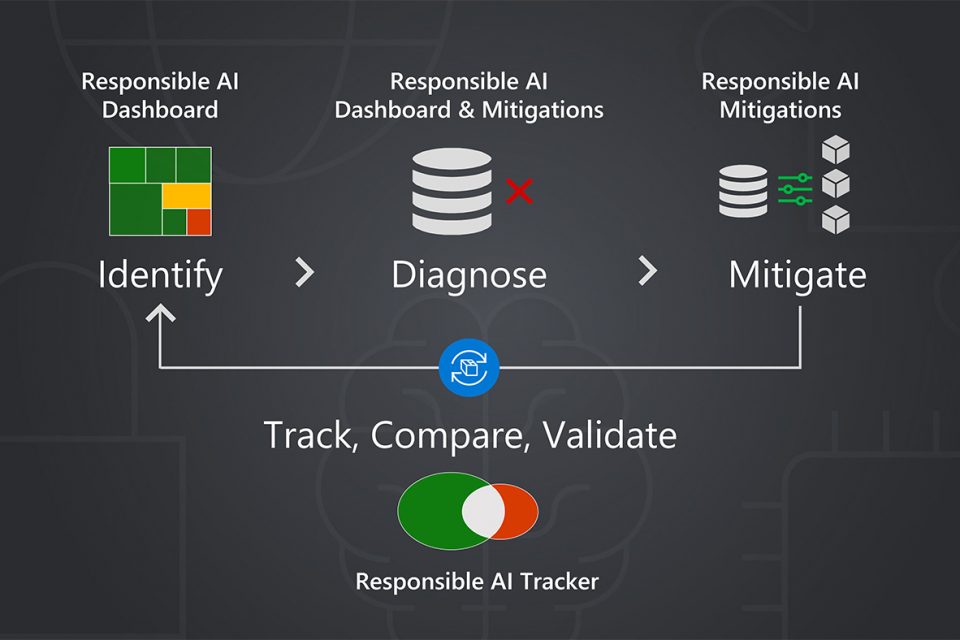

A través de su Responsible AI Toolbox (Caja de herramientas de IA Responsable), una colección de herramientas y funcionalidades diseñadas para ayudar a los profesionales a maximizar los beneficios de los sistemas de IA mientras mitigan los daños y otros esfuerzos para la IA Responsable, Microsoft ofrece una alternativa: un enfoque basado en principios para el desarrollo de IA centrado en la mejora del modelo específico. La mejora de modelos a través de métodos de focalización tiene como objetivo identificar soluciones adaptadas a las causas de fallas específicas. Esta es una parte crítica del ciclo de vida de mejora de un modelo que no solo incluye la identificación, el diagnóstico y la mitigación de fallas, sino también el seguimiento, la comparación y la validación de las opciones de mitigación. El enfoque ayuda a los profesionales a abordar mejor las fallas sin introducir otras nuevas ni erosionar otros aspectos del rendimiento del modelo.

“Con la mejora del modelo específico, tratamos de fomentar un proceso más sistemático para mejorar el aprendizaje automático en la investigación y la práctica”, dice Besmira Nushi, investigadora principal de Microsoft involucrada en el desarrollo de herramientas para respaldar la IA Responsable. Ella es miembro del equipo de investigación detrás de las adiciones más recientes a la caja de herramientas: la Biblioteca de mitigaciones de IA Responsable, que permite a los profesionales experimentar con mayor facilidad con diferentes técnicas para abordar fallas, y el Rastreador de IA Responsable, que utiliza visualizaciones para mostrar la efectividad de los diferentes técnicas para una toma de decisiones más informada.

Mejora del modelo objetivo: desde la identificación hasta la validación

Las herramientas de la Caja de herramientas de IA Responsable, disponibles en código abierto y a través de la plataforma Azure Machine Learning que ofrece Microsoft, se han diseñado con cada etapa del ciclo de vida de mejora del modelo en mente, para informar la mejora del modelo objetivo a través del análisis de errores, la evaluación de la equidad, los datos exploración e interpretabilidad.

Por ejemplo, la nueva biblioteca de mitigaciones refuerza la mitigación al ofrecer un medio para administrar las fallas que ocurren en el preprocesamiento de datos, como las causadas por la falta de datos o los datos de menor calidad para un subconjunto en particular. Para el seguimiento, la comparación y la validación, el nuevo rastreador reúne el modelo, el código, las visualizaciones y otros componentes de desarrollo para una documentación fácil de seguir de los esfuerzos de mitigación. La característica principal del rastreador es la evaluación y comparación de modelos desagregados, que desglosa el rendimiento del modelo por subconjunto de datos para presentar una imagen más clara de los efectos de una mitigación en el subconjunto previsto, así como en otros subconjuntos, lo que ayuda a descubrir disminuciones de rendimiento ocultas antes de implementar los modelos y utilizado por individuos y organizaciones. Además, el rastreador permite a los profesionales observar el rendimiento de los subconjuntos de datos a lo largo de las iteraciones de un modelo para ayudar a los profesionales a determinar el modelo más apropiado para la implementación.

“Los científicos de datos podrían construir muchas de las funcionalidades que ofrecemos con estas herramientas; podrían construir su propia infraestructura”, dice Nushi. “Pero hacer eso para cada proyecto requiere mucho esfuerzo y tiempo. El beneficio de estas herramientas es la escala. Aquí, pueden acelerar su trabajo con herramientas que se aplican a múltiples escenarios, liberándolos para que se concentren en el trabajo de construir modelos más confiables y confiables”.

– Besmira Nushi, investigadora principal de Microsoft

La creación de herramientas para una IA Responsable que sean intuitivas, efectivas y valiosas puede ayudar a los profesionales a considerar los daños potenciales y su mitigación desde el principio al desarrollar un nuevo modelo. El resultado puede ser una mayor confianza en que el trabajo que hacen es compatible con una IA que es más segura, más justa y más confiable porque fue diseñada de esa manera, dice Nushi. Los beneficios de usar estas herramientas pueden ser de gran alcance, desde contribuir a los sistemas de inteligencia artificial que evalúan de manera más justa a los candidatos para préstamos al tener una precisión comparable entre grupos demográficos hasta detectores de señales de tráfico en automóviles autónomos que pueden funcionar mejor en condiciones como sol, nieve y lluvia.

Convertir la investigación en herramientas para una IA Responsable

La creación de herramientas que pueden tener el impacto que los investigadores como Nushi imaginan, a menudo comienza con una pregunta de investigación e implica convertir el trabajo resultante en algo que las personas y los equipos puedan incorporar con facilidad y con confianza en sus flujos de trabajo.

“Hacer ese salto del código de un trabajo de investigación en GitHub a algo que sea utilizable implica mucho más proceso en términos de comprender cuál es la interacción que necesitaría el científico de datos, qué los haría más productivos”, dice Nushi. “En la investigación, se nos ocurren muchas ideas. Algunas de ellos son demasiado sofisticadas, tan sofisticadas que no se pueden usar en el mundo real porque no se pueden poner en funcionamiento”.

Los equipos de investigación multidisciplinarios que consisten en investigadores de la experiencia del usuario, diseñadores e ingenieros de aprendizaje automático y front-end han ayudado a fundamentar el proceso, al igual que las contribuciones de aquellos que se especializan en todo lo relacionado con la IA Responsable. Microsoft Research trabaja en estrecha colaboración con el equipo de incubación de Aether, el organismo asesor del liderazgo de Microsoft sobre ética y efectos de la IA, para crear herramientas basadas en la investigación. Igual de importante ha sido la asociación con equipos de productos cuya misión es hacer operativa la IA de manera responsable, dice Nushi. Para Microsoft Research, suele ser Azure Machine Learning, la plataforma de Microsoft para el desarrollo de modelos de aprendizaje automático de extremo a extremo. A través de esta relación, Azure Machine Learning puede ofrecer lo que Mehrnoosh Sameki, gerente principal de gestión de producto de Microsoft, llama «señales» de los clientes, que se trata en esencia de un flujo confiable de deseos y necesidades de los profesionales directo de los profesionales en el terreno. Y Azure Machine Learning está por igual emocionado de aprovechar lo que Microsoft Research y Aether tienen para ofrecer: ciencia de vanguardia. La relación ha sido fructífera.

Cuando la actual plataforma Azure Machine Learning hizo su debut hace cinco años, estaba claro que se necesitarían herramientas para una IA responsable. Además de alinearse con la visión de Microsoft para el desarrollo de IA, los clientes buscaban dichos recursos. Se acercaron al equipo de Azure Machine Learning con solicitudes de funciones de explicabilidad e interpretabilidad, métodos sólidos de validación de modelos y herramientas de evaluación de equidad, cuenta Sameki, quien dirige el equipo de Azure Machine Learning a cargo de las herramientas para una IA responsable. Microsoft Research, Aether y Azure Machine Learning se unieron para integrar herramientas para una IA responsable en la plataforma, incluido InterpretML para comprender el comportamiento del modelo, Error Analysis para identificar subconjuntos de datos en los que es más probable que haya fallas y Fairlearn para evaluar y mitigar problemas relacionados con la equidad. InterpretML y Fairlearn son proyectos independientes impulsados por la comunidad que impulsan varias funcionalidades de Caja de herramientas de IA responsable.

En poco tiempo, Azure Machine Learning se acercó a Microsoft Research con otra señal: los clientes querían usar las herramientas juntas, en una sola interfaz. El equipo de investigación respondió con un enfoque que permitió la interoperabilidad, lo que permitió que las herramientas intercambiaran datos y conocimientos, lo que facilitó una experiencia de depuración de ML sin problemas. En el transcurso de dos o tres meses, los equipos se reunieron cada semana para conceptualizar y diseñar «un solo panel de vidrio» desde el cual los profesionales pudieran usar las herramientas de manera colectiva. A medida que Azure Machine Learning desarrollaba el proyecto, Microsoft Research se mantuvo involucrado, desde proporcionar experiencia en diseño hasta contribuir a cómo la historia y las capacidades de lo que se había convertido en el panel de control de IA Responsable se comunicarían a los clientes.

Después del lanzamiento, los equipos se sumergieron en el siguiente desafío abierto: permitir a los profesionales mitigar mejor las fallas. Aquí es donde entran la Biblioteca de mitigaciones de IA Responsable y el Rastreador de IA Responsable, que fueron desarrollados por Microsoft Research en colaboración con Aether. Microsoft Research estaba bien equipado con los recursos y la experiencia para descubrir las visualizaciones más efectivas para hacer una comparación de modelos desagregados (había muy poco trabajo previo disponible al respecto) y navegar las abstracciones adecuadas para las complejidades de aplicar diferentes mitigaciones a diferentes subconjuntos de datos con una interfaz flexible y fácil de usar. A lo largo del proceso, el equipo de Azure proporcionó información sobre cómo encajan las nuevas herramientas en la infraestructura existente.

Con el equipo de Azure que trajo las necesidades de los profesionales y la plataforma a la mesa y la investigación que aportó lo último en evaluación de modelos, pruebas responsables y similares, es el ajuste perfecto, dice Sameki.

Un enfoque de código abierto a las herramientas para la IA Responsable

Si bien hacer que estas herramientas estén disponibles a través de Azure Machine Learning ayuda a los clientes a llevar sus productos y servicios al mercado de manera responsable, hacer que estas herramientas sean de código abierto es importante para cultivar un panorama aún más amplio de IA desarrollada de manera responsable. Cuando están listas para su lanzamiento, estas herramientas para la IA responsable se hacen de código abierto y luego se integran en la plataforma Azure Machine Learning. Las razones para optar por un enfoque de código abierto primero son numerosas, dicen Nushi y Sameki:

- las herramientas disponibles de manera gratuita para la IA responsable son un recurso educativo para aprender y enseñar la práctica de la IA Responsable;

- más colaboradores, tanto internos como externos de Microsoft, agregan calidad, longevidad y entusiasmo al trabajo y al tema; y

- la capacidad de integrarlas en cualquier plataforma o infraestructura fomenta un uso más generalizado.

La decisión también representa uno de los principios de IA de Microsoft en acción: la transparencia.

“En el espacio de la IA responsable, ser lo más abierto posible es el camino a seguir, y hay múltiples razones para ello”, dice Sameki. “La razón principal es generar confianza con los usuarios y con los consumidores de estas herramientas. En mi opinión, nadie confiaría en una técnica de evaluación de aprendizaje automático o en un algoritmo de mitigación de injusticia que no sea claro y de fuente cercana. Además, este campo es muy nuevo. Innovar al aire libre fomenta mejores colaboraciones en el campo”.

– Mehrnoosh Sameki, gerente principal de gestión de producto de Microsoft

Mirar hacia el futuro

Las capacidades de IA siguen su avance. La comunidad de investigación en general, los profesionales, la industria tecnológica, el gobierno y otras instituciones trabajan de diferentes maneras para dirigir estos avances en una dirección en la que la IA aporte valor y se minimicen sus daños potenciales. Las prácticas para una IA Responsable deberán seguir su evolución con los avances de la IA para respaldar estos esfuerzos.

Para los investigadores de Microsoft como Nushi y los gerentes de productos como Sameki, eso significa fomentar colaboraciones multidisciplinarias entre empresas en su desarrollo continuo de herramientas que fomentan la mejora de modelos específicos guiada por el proceso paso a paso de identificación, diagnóstico, mitigación y comparación y validación, donde sea que conduzcan esos avances.

“A medida que mejoremos en esto, espero que avancemos hacia un proceso más sistemático para comprender qué datos son en verdad útiles, incluso para los modelos grandes; lo que es dañino que en realidad no debería estar incluido en esos; y cuáles son los datos que tienen muchos problemas éticos si los incluyes”, dice Nushi. “Construir IA de manera responsable es transversal y requiere perspectivas y contribuciones de equipos internos y profesionales externos. Nuestra creciente colección de herramientas muestra que la colaboración efectiva tiene el potencial de impactar, para mejor, cómo creamos la nueva generación de sistemas de IA”.