Hoy estamos al borde de un giro monumental en el panorama tecnológico que cambiará para siempre la comunidad de seguridad. La IA y el aprendizaje automático pueden encarnar los avances tecnológicos más importantes de nuestra vida, al brindar enormes oportunidades para construir, descubrir y crear un mundo mejor.

De manera reciente, Brad Smith señaló que es probable que 2023 marque el punto de inflexión para que la IA se generalice, de la misma manera que pensamos en 1995 para navegar por Internet o 2007 para la revolución de los teléfonos inteligentes. Y aunque Brad describe algunas oportunidades importantes para la IA en todas las industrias, también destaca la profunda responsabilidad que implica para quienes desarrollan estas tecnologías. Una de las mayores oportunidades es también una responsabilidad central para nosotros en Microsoft: construir un futuro digital más seguro. La IA tiene el increíble potencial de remodelar nuestro panorama de seguridad y proteger a las organizaciones y a las personas de maneras que no hemos podido hacer en el pasado.

Con todo el potencial de la IA para empoderar a las personas y las organizaciones, también conlleva riesgos que la comunidad de seguridad debe abordar. Es imperativo que nosotros, como industria y comunidad tecnológica global, hagamos bien este recorrido, y eso significa mirar a la IA desde diversas perspectivas, tomar las cosas con calma, trabajar con nuestros socios en el gobierno y la industria, y compartir nuestros aprendizajes.

En Microsoft, hemos trabajado en los desafíos y oportunidades de la IA durante años. Hoy compartimos algunos desarrollos recientes para que la comunidad pueda estar mejor informada y mejor equipada para un nuevo mundo de exploración de IA:

- Nueva investigación: un equipo rojo de seguridad de IA dedicado dentro de Microsoft Threat Intelligence exploró cómo las amenazas de software tradicionales afectan a la IA y cómo los profesionales de la seguridad, los desarrolladores y los ingenieros de aprendizaje automático deberían pensar en proteger y monitorear la IA y los modelos de aprendizaje automático. Este equipo continuará con la investigación y las pruebas en la seguridad en IA y aprendizaje automático a medida que aprendemos más como empresa y como industria.

- Nuevas herramientas para defensores: de manera reciente Microsoft lanzó una herramienta de automatización de código abierto para pruebas de seguridad de sistemas de IA llamada Counterfit. La herramienta está diseñada para ayudar a las organizaciones a realizar evaluaciones de riesgos de seguridad de IA y ayudar a garantizar que los algoritmos utilizados en sus negocios sean sólidos y confiables. A partir de hoy, nuestra herramienta Counterfit formará parte del nuevo complemento Arsenal de MITRE.

- Colaboración de la industria para ayudar a proteger la cadena de suministro de IA: trabajamos con Hugging Face, uno de los repositorios de modelos de aprendizaje automático más populares, para mitigar las amenazas a la IA y los marcos de trabajo de aprendizaje automático mediante la colaboración en un escáner de seguridad específico de IA. Esta herramienta ayudará a la comunidad de seguridad a proteger mejor su cadena de suministro de software cuando se trata de inteligencia artificial y aprendizaje automático.

La IA trae nuevas capacidades y riesgos familiares

La inteligencia artificial y el aprendizaje automático pueden proporcionar ganancias de eficiencia notables para las organizaciones y aliviar la carga de una fuerza laboral abrumada por los datos.

Como ejemplo, estas capacidades pueden ser en particular útiles en ciberseguridad. Hay más de 1.200 ataques de contraseña de fuerza bruta por segundo y, según McKinsey, muchas organizaciones cuentan con más de 100 herramientas de seguridad, cada una con su propio portal y sistema de alerta que se revisa a diario. La IA cambiará la forma en que nos defendemos de las amenazas al mejorar nuestra capacidad para protegernos y responder a la velocidad de un ataque.

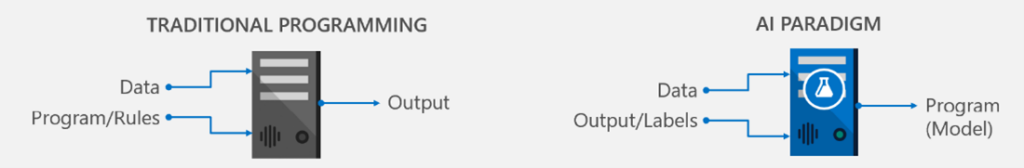

Esta es la razón por la que la IA es popular en este momento en todas las industrias: proporciona una forma de resolver problemas sofisticados a través de la utilización de relaciones de datos complejas tan solo mediante el etiquetado humano de ejemplos de entrada y salida. Utiliza las ventajas inherentes de la informática para aliviar la carga de los datos masivos y acelerar nuestro camino hacia la comprensión y los descubrimientos.

Pero con sus capacidades, la IA también conlleva algunos riesgos que las organizaciones tal vez no consideren. Muchas empresas extraen modelos existentes de repositorios públicos de IA y aprendizaje automático mientras trabajan para aplicar modelos de IA a sus propias operaciones. Pero a menudo, el software utilizado para construir sistemas de IA o los modelos de IA alojados en los repositorios no han sido moderados. Esto crea el riesgo de que cualquiera pueda poner un modelo manipulado para el consumo, lo que puede envenenar cualquier sistema que use el modelo.

Existe la idea errónea en la comunidad de seguridad de que atacar la IA y los sistemas de aprendizaje automático implica algoritmos exóticos y conocimientos avanzados de aprendizaje automático. Pero si bien el aprendizaje automático puede parecer matemática y magia, en el fondo se ejecuta en bits y bytes y, como todo software, puede ser vulnerable a problemas de seguridad.

Dentro del equipo de Microsoft Threat Intelligence, tenemos un grupo que se enfoca en comprender estos riesgos. El AI Security Red Team es un grupo interdisciplinario de investigadores de seguridad, ingenieros de aprendizaje automático e ingenieros de software cuyo objetivo es identificar de manera proactiva los puntos de falla en los sistemas de IA y ayudar a remediarlos. El equipo rojo de seguridad de IA trabaja para ver cómo los atacantes se acercan a la IA y cómo podrían comprometer un modelo de aprendizaje automático o de IA, para que podamos comprender esos ataques y cómo adelantarnos a ellos.

La investigación: las viejas amenazas cobran nueva vida con la IA

De manera reciente, el AI Security Red Team investigó qué tan fácil sería para un atacante inyectar código malicioso en los repositorios de modelos de inteligencia artificial y aprendizaje automático. Su pregunta central era, ¿cómo puede un adversario con las habilidades de piratería tradicionales actuales causar daño a los sistemas de IA? Esta pregunta nos llevó a demostrar que los vectores de ataque de software tradicionales pueden ser una amenaza.

La comunidad de seguridad conoce desde hace mucho tiempo las amenazas de serialización de Python, pero no en el contexto de los sistemas de IA. Investigadores académicos han advertido sobre la falta de prácticas de seguridad en el software de aprendizaje automático. De manera reciente, ha habido una ola de investigación (por ejemplo, aquí, aquí y aquí) que analiza las amenazas de serialización en específico en el contexto del aprendizaje automático. MITRE ATLAS, el marco de estilo ATT&CK para el aprendizaje automático contradictorio, llama de manera específica el compromiso de la cadena de suministro del aprendizaje automático. Incluso la documentación de seguridad de los marcos de AI señala de manera explícita que los archivos del modelo de aprendizaje automático están diseñados para almacenar programas genéricos.

Lo que ha estado menos claro es hasta dónde podrían llegar los atacantes, que es lo que exploró el AI Security Red Team. El equipo emula de forma rutinaria una variedad de adversarios, desde script kiddies (hacker no cualificado) hasta atacantes avanzados, para comprender los vectores de ataque contra la IA y los sistemas de máquinas. Para responder a nuestra pregunta, asumimos el papel de un adversario cuyo objetivo es comprometer los sistemas de aprendizaje automático solo con herramientas y metodologías de piratería tradicionales. En otras palabras, nuestro adversario no sabía nada sobre cómo hackear en específico la IA.

Nuestro ejercicio nos permitió evaluar el impacto de un cifrado deficiente en los puntos finales de aprendizaje automático, espacios de trabajo y entornos de aprendizaje automático configurados de manera incorrecta y permisos en exceso amplios en las cuentas de almacenamiento que contienen el modelo de aprendizaje automático y los datos de capacitación, todo lo cual puede considerarse amenazas tradicionales de software

El equipo descubrió que estas amenazas de software tradicionales pueden tener un impacto particular en el contexto de los sistemas de IA. Analizamos dos de los marcos de IA más utilizados por los ingenieros de aprendizaje automático y los científicos de datos. Estos marcos brindan una forma conveniente de escribir expresiones matemáticas para transformar los datos en el formato requerido antes de ejecutarlos a través de un algoritmo. El equipo pudo reutilizar una de esas funciones, la capa Keras Lambda, para inyectar código arbitrario.

La comunidad de seguridad es consciente de cómo los adversarios pueden abusar del módulo pickle de Python, que se utiliza para la serialización y deserialización de un objeto de Python. Sin embargo, nuestro trabajo muestra que los formatos de archivo del modelo de aprendizaje automático, que pueden no usar el formato pickle, aún tienen la suficiente flexibilidad para almacenar programas genéricos y pueden ser objeto de abuso. Esto también reduce la cantidad de pasos que el adversario necesita para incluir una puerta trasera en un modelo publicado en Internet o en un repositorio popular.

En nuestra prueba de concepto, pudimos reutilizar la función de procesamiento de expresiones matemáticas para cargar malware. Una ventaja añadida para el adversario: el ataque es autónomo y sigiloso; no requiere cargar un código personalizado adicional antes de cargar el modelo en sí.

Nuevas herramientas con Counterfit, CALDERA y ATLAS

En seguridad, invertimos e innovamos de manera constante para aprender sobre los comportamientos de los atacantes y llevar esa inteligencia dirigida por humanos a nuestros productos. Nuestra misión es combinar la diversidad de pensamiento y la experiencia de nuestros cazadores de amenazas y las empresas con las que nos hemos integrado (como RiskIQ y CyberX), para que nuestros clientes puedan beneficiarse tanto de la inteligencia de amenazas a gran escala como de la IA.

Con nuestro anuncio hoy de que Microsoft Counterfit ahora está integrado en MITRE CALDERA, los profesionales de la seguridad ahora pueden crear perfiles de amenazas para investigar cómo un adversario puede atacar los sistemas de inteligencia artificial tanto a través de métodos tradicionales como a través de técnicas novedosas de aprendizaje automático.

Esta nueva integración de herramientas reúne a Microsoft Counterfit, MITRE CALDERA (la herramienta de facto para la emulación de adversarios) y MITRE ATLAS para ayudar a los profesionales de la seguridad a comprender mejor las amenazas a los sistemas de ML. Esto permitirá a los equipos de seguridad buscar de manera proactiva las debilidades en los modelos de inteligencia artificial y aprendizaje automático y solucionarlos antes de que un atacante pueda aprovecharlos. Ahora los profesionales de la seguridad pueden obtener una evaluación de seguridad holística y automatizada de sus sistemas de IA mediante una herramienta con la que ya están familiarizados.

“Con el aumento de los ataques en el mundo real a los sistemas de aprendizaje automático que hemos visto a través de la colaboración MITRE ATLAS, es más importante que nunca crear herramientas prácticas para que los profesionales de la seguridad se preparen para estas crecientes amenazas en todo el mundo. Estamos encantados de lanzar una nueva herramienta de emulación de adversarios, Arsenal, en asociación con Microsoft y su equipo de Counterfit. Estas herramientas de código abierto mejorarán la capacidad de los profesionales de la seguridad y los ingenieros de ML de toda la comunidad para probar la vulnerabilidad de sus modelos de ML a través de las herramientas MITRE CALDERA que ya conocen y aman”.

Doug Robbins, vicepresidente de ingeniería y creación de prototipos, MITRE

Inversión e innovación con socios

En teoría, una vez que un modelo de aprendizaje automático está integrado con malware, se puede publicar en repositorios de alojamiento de ML populares para que cualquiera lo descargue. Un ingeniero de ML desprevenido podría descargar el modelo de ML con puerta trasera, lo que podría llevar al adversario a hacerse un hueco en el entorno de la organización.

Para ayudar a prevenir esto, trabajamos con Hugging Face, uno de los repositorios de modelos de ML más populares, para mitigar tales amenazas a través de colaborar en un escáner de seguridad específico de IA.

También recomendamos Software Bill of Materials (SBOM) para sistemas de IA. Hemos modificado la especificación de URL del paquete (purl) para incluir Hugging Face, así como MLFlow. Software Package Data Exchange (SPDX) y CycloneDX, los principales estándares SBOM que aprovechan las especificaciones de purl, permiten el seguimiento de modelos ML. Ahora, cualquier usuario de Azure ML, Databricks o Hugging Face que aproveche el SBOM recomendado por Microsoft tendrá la opción de realizar un seguimiento de los modelos ML como parte de la seguridad de la cadena de suministro.

Threat Intelligence en este espacio se mantendrá como un deporte de equipo, razón por la cual nos hemos asociado con MITRE y otras 11 organizaciones para capacitar a los profesionales de la seguridad para rastrear estas nuevas formas de ataque a través de la iniciativa MITRE ATLAS.

Dado que distribuimos cientos de millones de modelos ML cada mes, los artefactos corruptos pueden causar un gran daño y dañar la confianza en la comunidad de código abierto. Es por eso que en Hugging Face desarrollamos de manera activa herramientas para capacitar a los usuarios de nuestra plataforma para proteger sus artefactos, y apreciamos las contribuciones de la comunidad de Microsoft para mejorar la seguridad de los modelos ML.

Luc Georges, ingeniero de aprendizaje automático, Hugging Face

Es imperativo que nosotros, como industria y comunidad tecnológica global, seamos reflexivos y diligentes en nuestro enfoque para proteger los sistemas de inteligencia artificial y aprendizaje automático. En Microsoft, esto es fundamental para nuestro enfoque en la IA y nuestra cultura de seguridad. Debido a la naturaleza de la tecnología emergente, que es justo eso, emergente, hay muchas incógnitas. En seguridad, invertimos e innovamos de manera constante para aprender sobre los comportamientos de los atacantes y llevar esa inteligencia dirigida por humanos a nuestros productos.

La razón por la que invertimos en investigación, herramientas y asociaciones de la industria como las que anunciamos hoy es para que podamos comprender la naturaleza de lo que implicarían esos ataques, hacer todo lo posible para adelantarnos a ellos y ayudar a otros en la comunidad de seguridad a hacer lo mismo. Todavía hay mucho que aprender sobre la IA, e invertimos de manera continua en nuestras plataformas y en investigación de equipo rojo para aprender sobre esta tecnología y ayudar a informar cómo se integrará en nuestra plataforma y productos.

Recomendaciones y recursos

Las siguientes recomendaciones para los profesionales de la seguridad pueden ayudar a minimizar los riesgos para los sistemas de IA y ML:

- Animen a los ingenieros de ML a inventariar, realizar un seguimiento y actualizar los modelos de ML a través del aprovechamiento de los registros de modelos. Esto ayudará a realizar un seguimiento de los modelos en una organización y sus dependencias de software.

- Apliquen las mejores prácticas de seguridad existentes a los sistemas de IA. Esto incluye aislar el entorno que ejecuta modelos ML a través de contenedores y virtualización de máquinas, monitoreo de red y firewalls. Hemos esbozado una guía aquí para comenzar. Al hacer esto, tratamos los activos de IA como otra joya de la corona que los equipos de seguridad deben proteger de los adversarios.

- Aprovechen MITRE ATLAS para comprender las amenazas a los sistemas de IA y emularlos con Microsoft Counterfit a través de MITRE CALDERA. Esto ayudará a los analistas de seguridad a basar su esfuerzo en un enfoque realista y basado en números para proteger los sistemas de IA.

Esta prueba de concepto que buscamos es parte de una inversión más amplia en Microsoft para empoderar a la amplia gama de partes interesadas que desempeñan un papel importante para desarrollar e implementar sistemas de IA de manera segura:

- Para que los analistas de seguridad se orienten con las amenazas contra los sistemas de inteligencia artificial, Microsoft, en colaboración con MITRE, lanzó un marco de trabajo estilo ATT&CK Adversarial ML Threat Matrix, completo con estudios de casos de ataques a sistemas de aprendizaje automático de producción, que se ha convertido en MITRE ATLAS.

- Para los profesionales de la seguridad, Counterfit de código abierto de Microsoft ayuda a evaluar la postura de los sistemas de IA.

- Para los que responden a incidentes de seguridad, lanzamos una barra de errores para clasificar sistemáticamente los ataques en los sistemas de ML.

- Para los ingenieros de ML, publicamos una lista de verificación para completar la evaluación de riesgos de IA.

- Para los desarrolladores, publicamos una guía de modelado de amenazas específica para sistemas ML.

- Para ingenieros y legisladores, Microsoft, en colaboración con Berkman Klein Center en la Universidad de Harvard, lanzó una taxonomía que documenta varios modos de falla de aprendizaje automático.

- Para la comunidad de seguridad en general, Microsoft organizó la competencia anual de evasión de aprendizaje automático.

- Para los clientes de aprendizaje automático de Azure, brindamos orientación sobre seguridad y gobierno empresarial.

Colaboradores: Ram Shankar Siva Kumar con Gary López Muñoz, Matthieu Maitre, Amanda Minnich, Shiven Chawla, Raja Sekhar Rao Dheekonda, Lu Zhang, Charlotte Siska, Sudipto Rakshit.