Takeshi Numoto, wiceprezes wykonawczy i dyrektor ds. marketingu

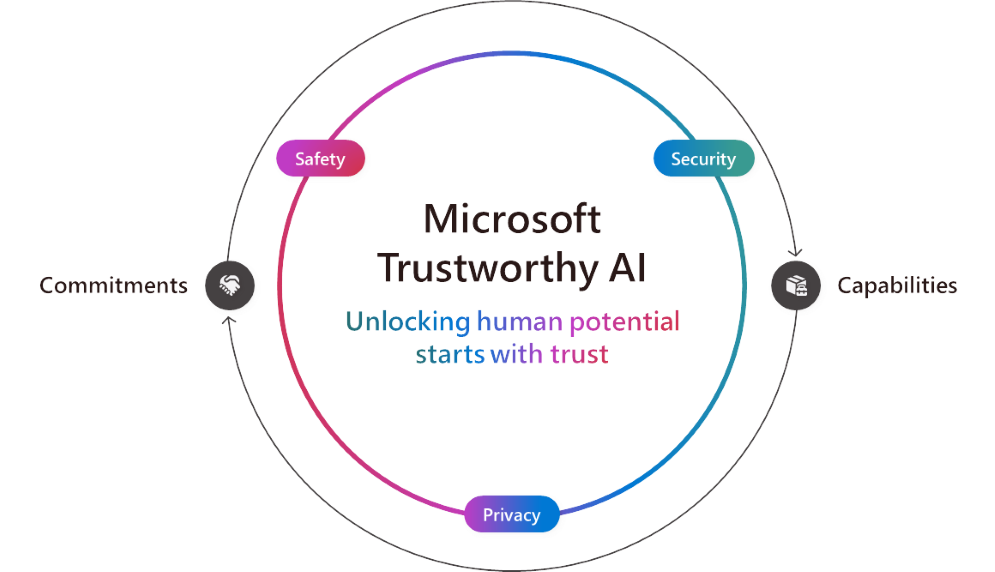

Wraz z rozwojem sztucznej inteligencji wszyscy mamy do odegrania rolę w jej pozytywnym wpływie na organizacje i społeczności na całym świecie. Z tego powodu koncentrujemy się na wsparciu klientów w korzystaniu i tworzeniu godnej zaufania AI, czyli takiej, która będzie bezpieczna, chroniona i prywatna.

Jako Microsoft dążymy do zapewnienia godnej zaufania sztucznej inteligencji i tworzymy czołowe w tej dziedzinie wsparcie technologiczne. Nasze zaangażowanie i możliwości idą w parze, by zapewnić naszym klientom oraz deweloperom ochronę na każdym poziomie.

Wychodząc naprzeciw naszym zobowiązaniom, ogłaszamy nowe możliwości produktowe wzmacniające ochronę, bezpieczeństwo i prywatność systemów AI.

Ochrona. Bezpieczeństwo to nasz najwyższy priorytet, a rozwijana przez nas inicjatywa Secure Future Initiative (SFI) podkreśla zobowiązania całej firmy i odpowiedzialność, jaką czujemy, by chronić naszych klientów. W tym tygodniu ogłosiliśmy nasz pierwszy raport SFI Progress Report, prezentujący aktualizacje obejmujące kwestie kultury, zarządzania, technologii i operacji. Jest on zgodny z naszym zobowiązaniem do traktowania bezpieczeństwa priorytetowo i kierowania się trzema zasadami: ochrona w fazie projektowania, ochrona domyślna i chronione operacje. Oprócz naszych własnych produktów, Microsoft Defender czy Purview, również nasze usługi AI są wyposażone w podstawowe mechanizmy kontroli bezpieczeństwa, tj. posiadają wbudowane funkcje mające pomóc w przeciwdziałaniu szybkim atakom i naruszeniom praw autorskich. Na tej podstawie ogłaszamy dziś dwie nowe możliwości:

- Ewaluacje w Azure AI Studio do wsparcia proaktywnej oceny ryzyka.

- Przejrzystość zapytań internetowych w usłudze Microsoft 365 Copilot, która ułatwi administratorom i użytkownikom lepsze zrozumienie, w jaki sposób wyszukiwanie w sieci usprawnia działanie usługi Copilot. Już wkrótce.

Nasze możliwości w zakresie bezpieczeństwa są już wykorzystywane przez klientów. Licząca 105 lat firma Cummins, znana z produkcji silników i opracowywania czystych technologii energetycznych, korzysta z Microsoft Purview, aby wzmocnić bezpieczeństwo danych i zarządzanie nimi poprzez zautomatyzowanie klasyfikacji, oznaczania i etykietowania danych. EPAM Systems, firma zajmująca się inżynierią oprogramowania i doradztwem biznesowym, wdrożyła Microsoft 365 Copilot dla 300 użytkowników z uwagi na ochronę danych zapewnianą przez Microsoft. J.T. Sodano, Senior Director działu IT, powiedział: „mieliśmy o wiele większe zaufanie do usługi Copilot w Microsoft 365 niż do innych dużych modeli językowych (LLM), ponieważ wiemy, że zastosowanie tam mają te same zasady ochrony informacji i danych, które skonfigurowaliśmy w Microsoft Purview“.

Bezpieczeństwo. Obejmując zarówno ochronę, jak i prywatność, zasady odpowiedzialnej AI firmy Microsoft z 2018 r. nadal wskazują, w jaki sposób bezpieczne tworzymy i wdrażamy AI w całej firmie. W praktyce oznacza to odpowiednie budowanie, testowanie i monitorowanie systemów w celu uniknięcia niepożądanych zachowań, tj. szkodliwych treści, stronniczości, niewłaściwego użycia i innych potencjalnych zagrożeń. Przez lata zainwestowaliśmy znaczne środki w budowanie niezbędnej struktury zarządzania, polityk, narzędzi i procesów, które pozwalają nam przestrzegać tych zasad oraz bezpiecznie tworzyć i wdrażać sztuczną inteligencję. Jako Microsoft jesteśmy zobowiązani do dzielenia się z naszymi klientami wiedzą zdobytą na drodze do przestrzegania zasad odpowiedzialnej AI. Korzystamy z naszych najlepszych praktyk i wiedzy, by dostarczyć ludziom i organizacjom możliwości oraz narzędzia do tworzenia aplikacji AI, spełniających te same wysokie standardy, do których dążymy.

Dziś prezentujemy nowe możliwości, które pomogą klientom czerpać korzyści ze sztucznej inteligencji przy jednoczesnym ograniczaniu ryzyka:

- Funkcja Correction w usłudze wykrywania ugruntowania w Microsoft Azure AI Content Safety, ułatwia rozwiązywanie problemów z halucynacjami AI w czasie rzeczywistym, nim zauważą je użytkownicy.

- Embedded Content Safety, czyli możliwość osadzania usługi Azure AI Content Safety na urządzeniach. Jest to ważne w sytuacjach, w których łączność z chmurą może być przerywana lub niedostępna.

- Nowe oceny w Azure AI Studio, które pomogą klientom ocenić jakość i trafność danych wyjściowych oraz częstotliwość, z jaką ich aplikacja AI generuje chronione materiały.

- Funkcja wykrywania materiałów chronionych na potrzeby kodu jest obecnie dostępna w wersji zapoznawczej w usłudze Azure AI Content Safety, by ułatwić wykrywanie wcześniej istniejącej zawartości i kodu. Funkcja ta pomaga twórcom oprogramowania zapoznać się z publicznym kodem źródłowym w zasobach GitHub, sprzyjając współpracy i przejrzystości, równocześnie umożliwiając podejmowanie bardziej świadomych decyzji dotyczących kodowania.

Zdumiewające jest to, w jaki sposób klienci z różnych branż już teraz wykorzystują rozwiązania Microsoft do tworzenia bezpieczniejszych i bardziej zaufanych aplikacji AI. Np. Unity, platforma do gier 3D, wykorzystała usługę Microsoft Azure OpenAI do zbudowania Muse Chat, asystenta AI, który ułatwia tworzenie gier. Muse Chat wykorzystuje modele filtrowania treści w Azure AI Content Safety, by zapewnić odpowiedzialne korzystanie z oprogramowania. Ponadto ASOS, brytyjski sklep odzieżowy z prawie 900 partnerami biznesowymi, wykorzystał te same wbudowane filtry treści w Azure AI Content Safety by zapewnić najwyższą jakość interakcji dzięki aplikacji AI, która pomaga klientom znaleźć nowe stylizacje.

Widzimy również korzyści w obszarze edukacji. Nowojorskie szkoły publiczne nawiązały współpracę z firmą Microsoft w celu opracowania systemu czatu, który jest bezpieczny i odpowiedni na potrzeby edukacyjne, a jest teraz wdrażany pilotażowo w szkołach. Departament Edukacji Australii Południowej w podobny sposób wprowadził generatywną sztuczną inteligencję do klas za pomocą EdChat, bazując na tej samej infrastrukturze, zapewniając uczniom i nauczycielom bezpieczne użytkowanie.

Prywatność. Dane są podstawą sztucznej inteligencji, a priorytetem Microsoft jest pomoc w zapewnieniu ochrony danych klientów i zgodności z naszymi obowiązującymi od dawna zasadami prywatności, na które składają się kontrola użytkownika, przejrzystość oraz ochrona prawna i regulacyjna. W oparciu o te zasady ogłaszamy:

- Poufne wnioskowanie w wersji podglądowej modelu Whisper usługi Azure OpenAI, umożliwia klientom opracowywanie aplikacji generatywnej AI, które gwarantują weryfikowalną, pełną prywatność. Dzięki poufnemu wnioskowaniu wrażliwe dane klientów pozostają bezpieczne i zachowują prywatność podczas przetwarzania wniosków, czyli wtedy, gdy wytrenowany model sztucznej inteligencji dokonuje prognoz lub podejmuje decyzje na podstawie nowych danych. Jest to szczególnie ważne w branżach podlegających ścisłym regulacjom, takich jak opieka zdrowotna, usługi finansowe, handel detaliczny, produkcja i energetyka.

- Ogólną dostępność maszyn wirtualnych Azure Confidential z procesorami graficznymi NVIDIA H100 Tensor Core, które umożliwiają klientom zabezpieczanie danych bezpośrednio na GPU. Rozwiązanie to opiera się na naszych poufnych rozwiązaniach obliczeniowych, które zapewniają, że dane klientów pozostają zaszyfrowane i chronione w bezpiecznym środowisku, dzięki czemu nikt nie uzyskuje dostępu do informacji lub systemu bez pozwolenia.

- Strefy danych Azure OpenAI dla UE i Stanów Zjednoczonych pojawią się wkrótce i będą opierać się na dotychczasowej rezydencji danych zapewnianej przez usługę Azure OpenAI, ułatwiając zarządzanie przetwarzaniem i przechowywaniem danych aplikacji generatywnej AI. Te nowe funkcje zapewniają klientom elastyczność skalowania aplikacji generatywnej AI we wszystkich regionach Azure w obrębie danego obszaru geograficznego, dając im jednocześnie kontrolę nad przetwarzaniem i przechowywaniem danych w UE lub USA.

Jesteśmy świadkami wzrostu zainteresowania klientów chronionymi obliczeniami i entuzjazmu związanego z poufnymi układami GPU. Przykładem jest dostawca zabezpieczeń aplikacji, firma F5, która wykorzystuje poufne wirtualne maszyny Azure Confidential z układami GPU NVIDIA H100 Tensor Core do tworzenia zaawansowanych rozwiązań bezpieczeństwa opartych na sztucznej inteligencji, zapewniając tym samym prywatność danych analizowanych przez modele. Z kolei Royal Bank of Canada (RBC) zintegrował poufne przetwarzanie Azure z własną platformą, aby analizować zaszyfrowane dane przy jednoczesnym zachowaniu prywatności klientów. Dzięki ogólnej dostępności maszyn wirtualnych Azure Confidential z procesorami graficznymi NVIDIA H100 Tensor Core, RBC może teraz korzystać z tych zaawansowanych narzędzi AI, aby pracować wydajniej i opracowywać bardziej rozbudowane modele AI.

Osiągnij więcej z godną zaufania AI

Wszyscy potrzebujemy i oczekujemy zaufanej sztucznej inteligencji. Widzieliśmy, co jest możliwe, gdy ludzie mają możliwość korzystania z AI w sposób budzący zaufanie, od wzbogacania doświadczeń pracowników i przekształcania procesów biznesowych po ponowne zaangażowanie klientów oraz wyobrażanie sobie naszego codziennego życia. Dzięki nowym funkcjom, zwiększającym ochronę, bezpieczeństwo i prywatność, nieustannie umożliwiamy klientom korzystanie i tworzenie godnych zaufania rozwiązań AI, które pomagają wszystkim ludziom i organizacjom na świecie osiągać więcej.