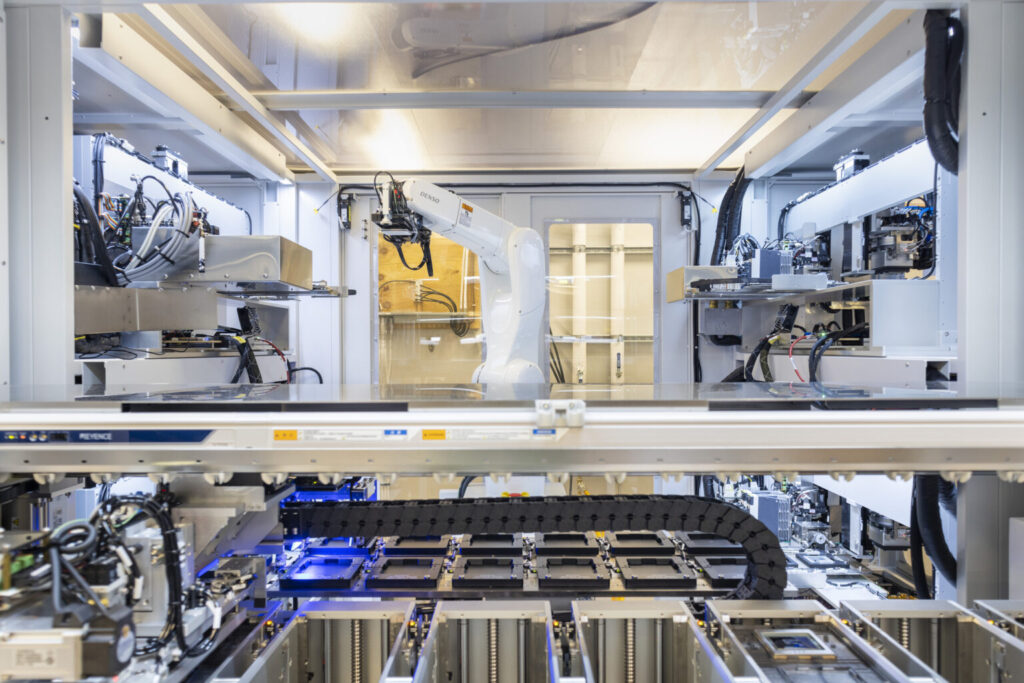

Escondido no campus da Microsoft em Redmond (EUA), há um laboratório cheio de máquinas que investigam o bloco de construção básico da era digital: o silício. Este processo de várias etapas testa meticulosamente o silício, por meio deum método que os engenheiros da Microsoft vêm refinando em segredo há anos.

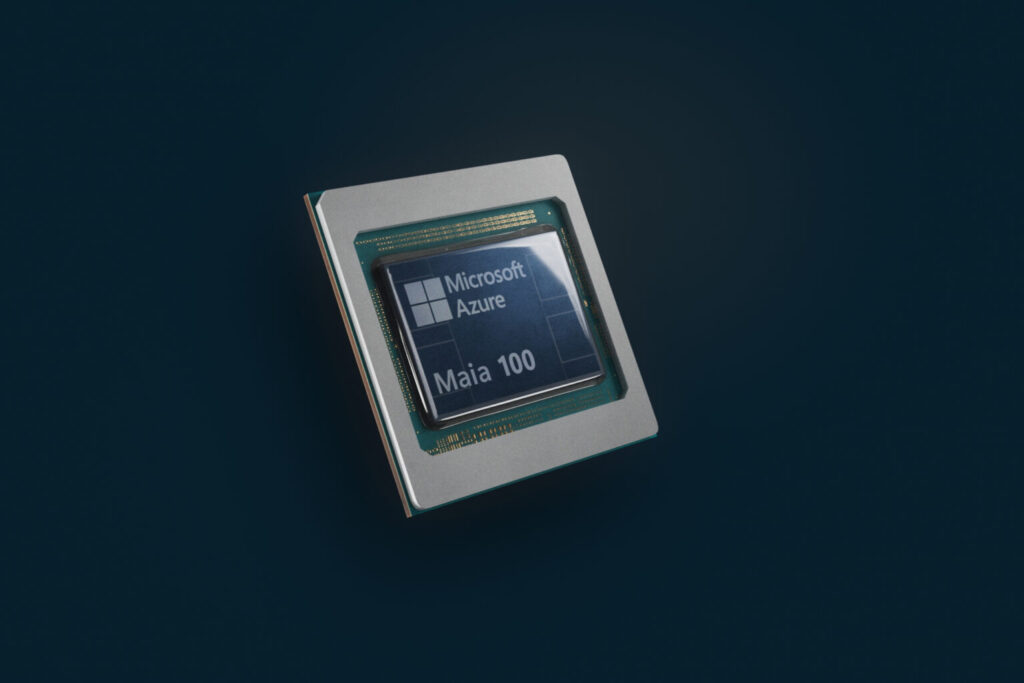

Hoje, no Microsoft Ignite , a empresa revelou dois chips e sistemas integrados projetados sob medida que resultaram dessa jornada: o Microsoft Azure Maia AI Accelerator, otimizado para tarefas de inteligência artificial (IA) e IA generativa, e o Microsoft Azure Cobalt CPU, um processador baseado em Arm adaptado para executar cargas de trabalho de computação de uso geral na nuvem da Microsoft Cloud.

Os chips representam uma última peça do quebra-cabeça para que a companhia possa fornecer sistemas de infraestrutura – que incluem desde opções de silício, software e servidores até racks e sistemas de resfriamento – que foram projetados de cima para baixo e que podem ser otimizados com cargas de trabalho internas de clientes.

Os chips começarão a ser implementados nos datacenters da Microsoft no início do próximo ano, inicialmente alimentando os serviços da empresa, como o Microsoft Copilot ou o Azure OpenAI Service. Eles se juntarão a uma gama crescente de produtos de parceiros do setor para ajudar a atender à crescente demanda por poder de computação eficiente, escalável e sustentável, bem como às necessidades dos clientes ansiosos para aproveitar os mais recentes avanços em nuvem e IA.

“Estamos construindo a infraestrutura para apoiar a inovação em IA e reimaginando todos os aspectos de nossos datacenters para atender às necessidades de nossos clientes”, disse Scott Guthrie, vice-presidente executivo do Cloud + AI Group da Microsoft. “Na escala em que operamos, é importante otimizar e integrar todas as camadas da pilha de infraestrutura para maximizar o desempenho, diversificar nossa cadeia de suprimentos e oferecer aos clientes opções de infraestrutura.”

Otimizando cada camada da pilha

Os chips são os “cavalos de batalha” da nuvem. Eles comandam bilhões de transistores que processam os vastos fluxos de uns e zeros que fluem pelos datacenters. Esse trabalho, em última análise, permite que você faça praticamente tudo na tela, desde enviar um e-mail até gerar uma imagem no Bing com uma frase simples.

Assim como construir uma casa permite controlar todas as escolhas e detalhes de design, a Microsoft vê a adição de chips desenvolvidos internamente como uma maneira de garantir que cada elemento seja adaptado para cargas de trabalho de nuvem e IA da empresa. Esses chips se integrarão em placas de servidor personalizadas, colocadas em racks feitos sob medida que se encaixam facilmente nos datacenters existentes da Microsoft. O hardware trabalhará com o software – co-projetados para desbloquear novos recursos e oportunidades.

O objetivo final é um sistema de hardware do Azure que ofereça flexibilidade máxima flexibilidade e e possa ser otimizado para potência, desempenho, sustentabilidade ou custo, segundo Rani Borkar, vice-presidente corporativo de Sistemas e Infraestrutura de Hardware do Azure (AHSI).

“O software é o nosso ponto forte, mas, francamente, somos uma empresa de sistemas. Estamos co-projetando e otimizando hardware e software para que um mais um seja maior do que dois”, disse Borkar. “Temos visibilidade de toda a pilha, e o silício é apenas um dos ingredientes.”

No Microsoft Ignite, a empresa também anunciou a disponibilidade geral de um desses ingredientes-chave: o Azure Boost, um sistema que torna o armazenamento e a rede mais rápidos, levando esses processos dos servidores host para hardware e software criados especificamente para esse fim.

Para complementar seus esforços de silício personalizado, a Microsoft também anunciou que está expandindo parcerias do setor para fornecer mais opções de infraestrutura para os clientes. A empresa lançou uma prévia da nova NC H100 v5 Virtual Machine Series construída para a NVIDIA H100 Tensor Core GPUs, oferecendo maior desempenho, confiabilidade e eficiência para treinamento de IA de médio alcance e inferência de IA generativa. A Microsoft também adicionará a mais recente GPU NVIDIA H200 Tensor Core à sua linha de produtos no próximo ano para oferecer suporte à inferência de modelos maiores sem redução na latência.

A empresa também anunciou que adicionará máquinas virtuais (VMs) aceleradas AMD MI300X ao Azure. As VMs ND MI300 são projetadas para acelerar o processamento de cargas de trabalho de IA para treinamento de modelos de alto alcance e inferência generativa, e contarão com a GPU mais recente da AMD, a AMD Instinct MI300X.

Ao adicionar silício de primeira parte a um ecossistema crescente de chips e hardware de parceiros da indústria, a Microsoft será capaz de oferecer mais opções em termos de preço e desempenho para seus clientes, disse Borkar.”A obsessão pelo cliente significa que fornecemos o que é melhor para eles, o que significa aproveitar o que já está disponível no ecossistema, bem como o que desenvolvemos”, disse ela. “Continuaremos a trabalhar com todos os nossos parceiros para entregar o que eles querem”, acrescenta Borkar.

Hardware e software em evolução conjunta

O novo Maia 100 AI Accelerator da empresa alimentará algumas das maiores cargas de trabalho internas de IA em execução no Microsoft Azure. Além disso, a OpenAI forneceu feedback sobre o Azure Maia e os insights profundos da companhia sobre como as cargas de trabalho da OpenAI são executadas em infraestrutura adaptada para seus grandes modelos de linguagem estão ajudando a orientar os futuros designs da organização.

“Desde a primeira parceria com a Microsoft, colaboramos para projetar em conjunto a infraestrutura de IA do Azure em todas as camadas para nossos modelos e necessidades de treinamento sem precedentes”, disse Sam Altman, CEO da OpenAI. “Ficamos entusiasmados quando a empresa compartilhou pela primeira vez seus designs para o chip Maia, e trabalhamos juntos para refiná-lo e testá-lo com nossos modelos. A arquitetura de IA de ponta a ponta do Azure, agora otimizada até o silício com o chip, abre caminho para treinar modelos mais capazes, tornando-os mais baratos para nossos clientes.”

O Maia 100 AI Accelerator também foi projetado especificamente para a pilha de hardware do Azure, disse Brian Harry, membro técnico da Microsoft que lidera a equipe do Azure Maia. Essa integração vertical – o alinhamento do design do chip com a infraestrutura de IA maior projetada com as cargas de trabalho da companhia – pode resultar em ganhos significativos de desempenho e eficiência, disse ele.

“O Azure Maia foi projetado especificamente para IA e para alcançar a utilização máxima e absoluta do hardware”, disse ele.

Enquanto isso, a CPU Cobalt 100 é construída na arquitetura Arm, um tipo de design de chip energeticamente eficiente e otimizado para fornecer maior eficiência e desempenho em ofertas nativas da nuvem, disse Wes McCullough, vice-presidente corporativo de desenvolvimento de produtos de hardware. A escolha da tecnologia Arm foi um elemento-chave na meta de sustentabilidade da Microsoft. O objetivo é otimizar o “desempenho por watt” em todos os seus datacenters, o que significa, essencialmente, obter mais poder de computação para cada unidade de energia consumida.

“A arquitetura e a implementação são projetadas com a eficiência energética em mente”, disse ele. “Estamos fazendo o uso mais eficiente dos transistores no silício. Multiplicando esses ganhos de eficiência em servidores em todos os nossos datacenters, isso se traduz um número bastante significativo.”

Hardware personalizado, do chip ao datacenter

Antes de 2016, a maioria das camadas da nuvem da Microsoft era adquirida pronta,, disse Pat Stemen, gerente do programa de parceiros da equipe AHSI. Então,, a Microsoft começou a construir seus próprios servidores e racks personalizados, reduzindo os custos e oferecendo aos clientes uma experiência mais consistente. Com o tempo, o silício tornou-se a principal peça que faltava.

A capacidade de construir seu próprio silício personalizado permite que a companhia direcione certas qualidades e garanta que os chips tenham um desempenho ideal em suas cargas de trabalho mais importantes. Seu processo de teste inclui determinar como cada chip se comportará sob diferentes condições de frequência, temperatura e energia para desempenho máximo e, por isso, testar cada um deles nas mesmas condições e configurações que ele encontraria em um datacenter real da Microsoft.

A arquitetura de silício apresentada hoje também permite à Microsoft não apenas melhorar a eficiência de resfriamento, mas otimizar o uso de seus ativos de datacenter atuais e maximize a capacidade do servidor dentro de sua área de cobertura existente, disse a empresa.Por exemplo, não existiam racks para acomodar os requisitos únicos das placas de servidor Maia 100. Então, a companhia os construiu do zero. Esses racks são mais largos do que os que normalmente ficam nos datacenters da empresa. Esse design expandido fornece amplo espaço para cabos de energia e de rede, essenciais para as demandas exclusivas de cargas de trabalho de IA.

Tarefas de IA, como as realizadas pelo Maia 100, têm com demandas computacionais intensivas que consomem mais energia. Métodos tradicionais de resfriamento a ar são insuficientes para esses chips de alto desempenho. Como resultado, o resfriamento líquido – que usa fluidos circulantes para dissipar o calor – surgiu como a solução preferida para esses desafios térmicos, garantindo que eles funcionem de forma eficiente sem superaquecimento.

Mas os datacenters atuais da Microsoft não foram projetados para grandes unidades de resfriamento líquidos, também conhecidos como chillers. Por isso, desenvolveu um “sidekick” (ajudante) que fica ao lado do rack Maia 100. Esses ajudantes funcionam um pouco como um radiador em um carro. O líquido frio flui do “sidekick” para as placas frias que estão presas à superfície dos chips Maia 100. Cada placa tem canais por meio dos quais o líquido é circulado para absorver e transportar calor. Isso flui para o “sidekick”, que remove o calor do líquido e o envia de volta ao rack para absorver mais calor, e assim por diante.

O design conjunto de rack e “sidekick” ressalta o valor de uma abordagem de sistemas para a infraestrutura, disse McCullough. Ao controlar cada aspecto— desde o ethos de baixo consumo de energia do chip Cobalt 100 até as complexidades doresfriamento do datacenter — a Microsoft pode orquestrar uma interação harmoniosa entre cada componente, garantindo que o todo seja de fato maior do que a soma de suas partes na redução do impacto ambiental.

A empresa compartilhou seus aprendizados de design de seu rack personalizado com parceiros da indústria e pode usá-los independentemente do pedaço componente de silício que esteja dentro, disse Pat Stemen. “Todas as coisas que construímos, seja infraestrutura, software ou firmware, podemos alavancar se implantamos nossos chips ou os de nossos parceiros da indústria”, disse ele. “Essa é uma escolha que o cliente pode fazer, e estamos tentando fornecer o melhor leque de opções para ele, seja por desempenho, custo ou qualquer outra dimensão que lhe interesse.”

A Microsoft planeja expandir esse conjunto de opções no futuro; ele já está projetando versões de segunda geração da série Azure Maia AI Accelerator e da série de CPU do Azure Cobalt. A missão da empresa continua clara, disse Stemen: otimizar todas as camadas de sua pilha tecnológica, desde o silício principal até o serviço final.

“A inovação da empresa está indo mais longe na pilha com esse trabalho de silício para garantir o futuro das cargas de trabalho de nossos clientes no Azure, priorizando desempenho, eficiência energética e custo”, disse ele. “Escolhemos essa inovação intencionalmente para que nossos clientes tenham a melhor experiência que podem ter com o Azure hoje e no futuro”, finaliza.

Recursos relacionados:

Leia mais: Microsoft oferece infraestrutura em nuvem desenvolvida especificamente na era da IA

Leia mais: Azure anuncia nova série de VM otimizada para IA com a principal GPU MI300X da AMD

Leia mais: Apresentando VMs Azure NC H100 v5 para cargas de trabalho de IA e HPC de médio porte

Saiba mais: Microsoft Ignite

Imagem superior: Um técnico instala os primeiros racks de servidores contendo CPUs Microsoft Azure Cobalt 100 em um datacenter em Quincy, Washington. É a primeira CPU projetada pela Microsoft para o Microsoft Cloud. Foto de John Brecher para Microsoft.