Por Rani Borkar Vice-Presidente Corporativo, Sistemas e Infraestrutura de Hardware do Azure

Nesta semana, durante a NVIDIA GTC, a Microsoft e a NVIDIA estão anunciando novas ofertas em uma variedade de áreas de soluções – desde a infraestrutura de IA de ponta até novas integrações de plataforma e avanços no setor. As notícias desta terça-feira (19) expandem nossa colaboração de longa data, que abriu caminho para as inovações revolucionárias de IA que os clientes agora estão concretizando.

Microsoft e NVIDIA colaboram no Grace Blackwell 200 Superchip para modelos de IA de próxima geração

A Microsoft e a NVIDIA estão trazendo o poder do NVIDIA Grace Blackwell 200 (GB200) Superchip para o Microsoft Azure. O GB200 é um novo processador projetado especificamente para cargas de trabalho de IA generativas em grande escala, processamento de dados e cargas de alto desempenho, apresentando até 16 TB/s de largura de banda de memória e até 45 vezes a inferência em modelos de trilhões de parâmetros em relação à geração anterior de servidores Hopper.

A Microsoft trabalhou em estreita colaboração com a NVIDIA para garantir que suas GPUs, incluindo a GB200, possam lidar com os mais recentes grandes modelos de linguagem (LLMs, em inglês) treinados na infraestrutura de IA do Azure. Esses modelos exigem enormes quantidades de dados e computação para serem treinados e executados, e o GB200 permitirá que a Microsoft ajude os clientes a dimensionar esses recursos para novos níveis de desempenho e precisão.

A Microsoft também implantará uma malha de computação de IA de ponta a ponta com a recém-anunciada plataforma de rede NVIDIA Quantum-X800 InfiniBand. Ao aproveitar seus recursos de computação em rede com o SHARPv4 e seu suporte adicional para FP8 para técnicas de IA de ponta, o NVIDIA Quantum-X800 estende as tarefas de computação paralela do GB200 em escala massiva de GPU.

O Azure será uma das primeiras plataformas de nuvem a fornecer instâncias baseadas em GB200

A Microsoft se comprometeu em trazer instâncias baseadas em GB200 para o Azure para oferecer suporte aos serviços de IA da Microsoft e de seus clientes. As novas instâncias do Azure baseadas na mais recente rede GB200 e NVIDIA Quantum-X800 InfiniBand ajudarão a acelerar a geração de modelos de fronteira, fundamentais para processamento de linguagem natural, visão computacional, reconhecimento de fala e muito mais. Os clientes do Azure poderão usar o GB200 Superchip para criar e implantar soluções de IA de última geração que podem lidar com grandes quantidades de dados e complexidade, enquanto aceleram o tempo de lançamento no mercado.

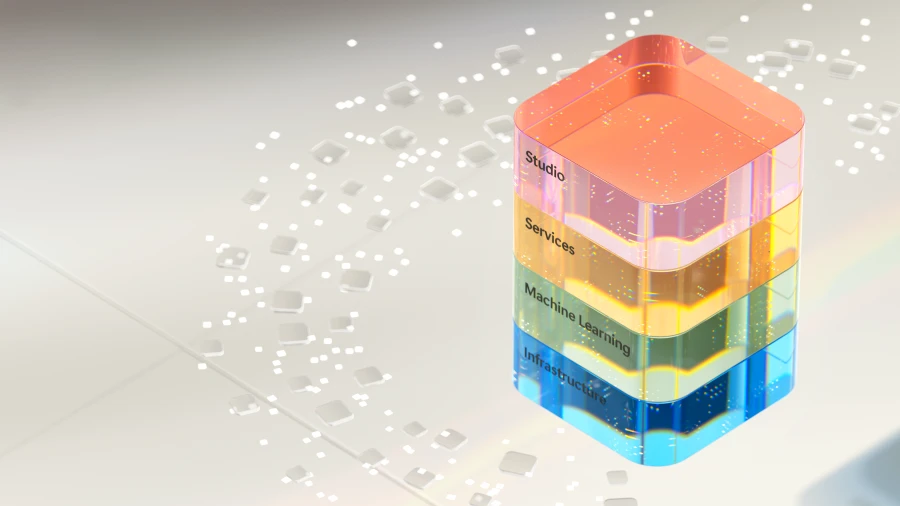

O Azure também oferece uma variedade de serviços para ajudar os clientes a otimizar suas cargas de trabalho de IA, como Microsoft Azure CycleCloud, Azure Machine Learning, Microsoft Azure AI Studio, Microsoft Azure Synapse Analytics e Microsoft Azure Arc. Esses serviços fornecem aos clientes uma plataforma de IA de ponta a ponta que pode lidar com a inserção, processamento, treinamento, inferência e implantação de dados em ambientes híbridos e de várias nuvens.

Cumprindo a promessa de IA para clientes em todo o mundo

Com uma base poderosa da infraestrutura de IA do Azure, que usa as GPUs NVIDIA mais recentes, a Microsoft está inserindo IA em todas as camadas da pilha de tecnologia, ajudando os clientes a gerar novos benefícios e ter ganhos ainda maiores de produtividade. Com mais de 53.000 clientes de IA do Azure, a Microsoft fornece acesso à melhor seleção de modelos básicos e de código aberto, incluindo LLMs e pequenos modelos de linguagem (SLMs), todos profundamente integrados com dados e ferramentas de infraestrutura no Azure.

A parceria recentemente anunciada com a Mistral AI também é um ótimo exemplo de como a Microsoft está permitindo que os principais inovadores de IA com acesso à infraestrutura de IA de ponta do Azure, acelerem o desenvolvimento e a implantação de LLMs de próxima geração. O crescente catálogo de modelos de IA do Azure oferece mais de 1,6 mil modelos, permitindo aos clientes escolherem a partir das LLMs e SLM mais recentes, incluindo a Open AI Mistral AI, Meta, Hugging Face, Deci AI, NVIDIA e Microsoft Research. Os clientes do Azure podem decidir qual é o melhor modelo para sua necessidade de uso.

“Estamos entusiasmados em embarcar nesta parceria com a Microsoft. Com a infraestrutura de IA de ponta do Azure, estamos alcançando um novo marco em nossa expansão, impulsionando nossa pesquisa inovadora e aplicativos práticos para novos clientes em todos os lugares. Juntos, estamos comprometidos em impulsionar o progresso impactante no setor de IA e oferecer valor incomparável aos nossos clientes e parceiros globalmente.”

Arthur Mensch, Diretor Presidente, Mistral AI

Disponibilidade geral da série de VMs do Azure NC H100 v5, otimizada para inferência generativa e computação de alto desempenho

A Microsoft também anunciou a disponibilidade geral da série de VMs do Azure NC H100 v5, projetada para treinamento de médio alcance, inferência e simulações de computação de alto desempenho (HPC). É uma ferramenta que oferece alto desempenho e eficiência.

À medida que os aplicativos de IA generativa se expandem, os modelos de linguagem fundamentais que os capacitam também, assim conseguem incluir SLMs e LLMs. Além disso, os modelos de inteligência artificial estreita (ANI) continuarão a evoluir, focados em previsões mais precisas em vez da criação de novos dados para continuar a melhorar seus casos de uso. Suas aplicações incluem tarefas como classificação de imagens, detecção de objetos e processamento de linguagem natural mais amplo.

Usando os recursos robustos e a escalabilidade do Azure, oferecemos ferramentas que capacitam organizações de todos os tamanhos, independentemente de seus recursos. As VMs do Azure NC H100 v5 são mais uma solução computacional disponibilizada hoje e que fará exatamente isso.

A série de VMs do Azure NC H100 v5 é baseada na plataforma NVIDIA H100 NVL, que possui duas classes de máquinas virtuais, variando de uma a duas GPUs NVIDIA H100 94GB PCIe Tensor Core conectadas por NVLink com 600 GB/s de largura de banda. Esta série VM suporta PCIe Gen5, que fornece as mais altas velocidades de comunicação (bidirecional de 128 GB/s) entre o processador host e a GPU. Isso reduz a latência e a sobrecarga da transferência de dados e permite que aplicativos de IA e HPC sejam mais rápidos e escaláveis.

A série VM também suporta a tecnologia NVIDIA multi-instance GPU (MIG), o que permite aos clientes dividirem cada GPU em até sete instâncias. Isso possibilita flexibilidade e escalabilidade para diversas cargas de trabalho de IA. Esta série de VMs oferece até 80 Gbps de largura de banda de rede e até 8 TB de armazenamento NVMe local em tamanhos de VM de nó completo.

Essas VMs são ideais para treinar modelos, executar tarefas de inferência e desenvolver aplicativos de ponta. Saiba mais sobre o Azure NC H100 v5-series.

“A Snorkel AI tem orgulho desta parceria com a Microsoft para ajudar as organizações a aproveitar de forma rápida e econômica o poder dos dados e da IA. A infraestrutura de IA do Azure oferece o desempenho que nossas cargas de trabalho de ML mais exigentes demandam, além de implantação simplificada e recursos de gerenciamento simplificados que nossos pesquisadores adoram. Com a nova série de VMs do Azure NC H100 v5 alimentada por GPUs NVIDIA H100 NVL, estamos entusiasmados em continuar a acelerar o desenvolvimento de dados iterativos para empresas e usuários de OSS.”

Paroma Varma, Co-Fundador e Chefe de Pesquisa, Snorkel AI

Microsoft e NVIDIA oferecem avanços para saúde e ciências biológicas

A Microsoft está expandindo sua colaboração com a NVIDIA para contribuir e transformar o setor de saúde e ciências da vida por meio da integração de nuvem, IA e supercomputação.

Usando a escala global, a segurança e os recursos avançados de computação do Azure e da IA do Azure, juntamente com o pacote DGX Cloud e NVIDIA Clara da NVIDIA, permitem que provedores de serviços de saúde, empresas farmacêuticas e de biotecnologia, além de desenvolvedores de dispositivos médicos possam, agora, acelerar a inovação em toda a cadeia de valor de pesquisa clínica para prestação de cuidados para o benefício de pacientes em todo o mundo. Saiba mais.

As novas APIs do Omniverse permitem que clientes de todos os setores incorporem recursos gráficos e de visualização massivos

Hoje, a plataforma Omniverse da NVIDIA para desenvolver aplicativos 3D estará disponível como um conjunto de APIs em execução no Microsoft Azure, permitindo que os clientes incorporem recursos avançados de gráficos e visualização em aplicativos de software existentes da Microsoft e de ISVs parceiros.

Criadas com base no OpenUSD, um intercâmbio universal de dados, as APIs NVIDIA Omniverse Cloud no Azure fazem o trabalho de integração para os clientes, oferecendo-lhes recursos de renderização baseados fisicamente no front-end. Demonstrando o valor dessas APIs, a Microsoft e a NVIDIA têm trabalhado com a Rockwell Automation e a Hexagon para mostrar como os mundos físico e digital podem ser combinados para aumentar a produtividade e a eficiência. Saiba mais.

Microsoft e NVIDIA vislumbram integração mais profunda do NVIDIA DGX Cloud com o Microsoft Fabric

As duas empresas estão colaborando para alimentar as cargas de dados mais exigentes dos clientes ao unir a computação NVIDIA DGX Cloud e o Microsoft Fabric. Isso significa que os tempos de execução otimizados específicos da carga de trabalho da NVIDIA, LLMs e aprendizado de máquina irão funcionar perfeitamente com o Fabric.

A integração do NVIDIA DGX Cloud e do Fabric inclui a expansão dos recursos do Fabric ao trazer a personalização do grande modelo de linguagem do DGX Cloud. Isso ajuda a lidar com casos de uso intensivo de dados, como gêmeos digitais e previsão do tempo, com Fabric OneLake sendo usado para o armazenamento de dados. A integração também fornecerá o DGX Cloud como uma opção para os clientes acelerarem suas cargas de trabalho de ciência de dados e engenharia de dados do Fabric.

Acelerando a inovação na era da IA

Durante anos, a Microsoft e a NVIDIA colaboraram entre si com hardware a sistemas, até VMs, para criar soluções inovadoras habilitadas para que IA possa enfrentar desafios complexos na nuvem. A Microsoft continuará a expandir e aprimorar sua infraestrutura global com a tecnologia mais avançada em todas as camadas, oferecendo melhor desempenho e escalabilidade para cargas complexas de trabalho de nuvem e IA, capacitando os clientes a alcançarem mais em todos os setores.