Por: Rani Borkar, vicepresidenta corporativa de sistemas e infraestructura de hardware de Azure.

En NVIDIA GTC, Microsoft y NVIDIA anuncian nuevas ofertas en una amplia gama de áreas de soluciones, desde la infraestructura líder de IA hasta las integraciones de nuevas plataformas y los avances de la industria. Esta noticia amplía nuestra colaboración de larga data, que ha allanado el camino para innovaciones revolucionarias de IA que los clientes ahora llevan a buen término.

Microsoft y NVIDIA colaboran en el superchip Grace Blackwell 200 para modelos de IA de próxima generación

Microsoft y NVIDIA llevan la potencia del superchip NVIDIA Grace Blackwell 200 (GB200) a Microsoft Azure. El GB200 es un nuevo procesador diseñado de manera específica para cargas de trabajo de IA generativa a gran escala, procesamiento de datos y cargas de trabajo de alto rendimiento, con hasta 16 TB/s de ancho de banda de memoria y hasta 45 veces la inferencia estimada en modelos de billones de parámetros en relación con la generación anterior de servidores Hopper.

Microsoft ha trabajado en estrecha colaboración con NVIDIA para garantizar que sus GPU, incluida la GB200, puedan manejar los últimos modelos de lenguaje grande (LLM, por sus siglas en inglés) entrenados en la infraestructura de Azure AI. Estos modelos requieren enormes cantidades de datos y proceso para entrenarlos y ejecutarlos, y el GB200 permitirá a Microsoft ayudar a los clientes a escalar estos recursos a nuevos niveles de rendimiento y precisión.

Microsoft también implementará una estructura de cómputo de IA de extremo a extremo con la plataforma de red NVIDIA Quantum-X800 InfiniBand anunciada de manera reciente. Al aprovechar sus capacidades de computación en red con SHARPv4 y su compatibilidad adicional con FP8 para técnicas de IA de vanguardia, NVIDIA Quantum-X800 extiende las tareas de computación paralela del GB200 a una escala masiva de GPU.

Azure será una de las primeras plataformas en la nube en ofrecer instancias basadas en GB200

Microsoft se ha comprometido a llevar instancias basadas en GB200 a Azure para dar soporte a los clientes y a los servicios de IA de Microsoft. Las nuevas instancias de Azure, basadas en las últimas redes GB200 y NVIDIA Quantum-X800 InfiniBand, ayudarán a acelerar la generación de modelos de frontera y fundamentales para el procesamiento del lenguaje natural, la visión artificial, el reconocimiento de voz y mucho más. Los clientes de Azure podrán usar el GB200 Superchip para crear e implementar soluciones de IA de última generación que pueden manejar cantidades masivas de datos y complejidad, al tiempo que aceleran el tiempo de comercialización.

Azure también ofrece una gama de servicios para ayudar a los clientes a optimizar sus cargas de trabajo de IA, como Microsoft Azure CycleCloud, Azure Machine Learning, Microsoft Azure AI Studio, Microsoft Azure Synapse Analytics y Microsoft Azure Arc. Estos servicios proporcionan a los clientes una plataforma de IA de extremo a extremo que puede gestionar la ingesta, el procesamiento, el entrenamiento, la inferencia y la implementación de datos en entornos híbridos y multinube.

Cumplir la promesa de la IA a clientes de todo el mundo

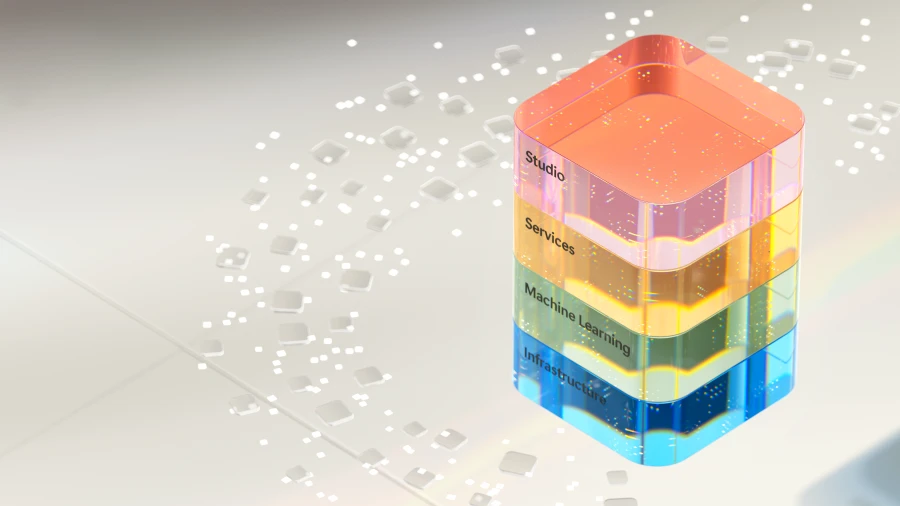

Con una sólida base de infraestructura de IA de Azure que usa las GPU NVIDIA más recientes, Microsoft infunde IA en todas las capas de la pila tecnológica, lo que ayuda a los clientes a generar nuevos beneficios y ganancias de productividad. Ahora, con más de 53 mil clientes de Azure AI, Microsoft proporciona acceso a la mejor selección de modelos básicos y de código abierto, incluidos los LLM y los modelos de lenguaje pequeño (SLM, por sus siglas en inglés), todos ellos integrados en profundidad con los datos y las herramientas de infraestructura de Azure.

La asociación anunciada de manera reciente con Mistral AI también es un gran ejemplo de cómo Microsoft permite a los principales innovadores de IA acceder a la infraestructura de IA de vanguardia de Azure, para acelerar el desarrollo y la implementación de LLM de próxima generación. El creciente catálogo de modelos de IA de Azure ofrece más de 1.600 modelos, lo que permite a los clientes elegir entre los últimos LLM y SLM, incluidos OpenAI, Mistral AI, Meta, Hugging Face, Deci AI, NVIDIA y Microsoft Research. Los clientes de Azure pueden elegir el mejor modelo para su caso de uso.

«Estamos encantados de embarcarnos en esta asociación con Microsoft. Con la infraestructura de IA de vanguardia de Azure, alcanzamos un nuevo hito en nuestra expansión, para impulsar nuestra investigación innovadora y aplicaciones prácticas a nuevos clientes de todo el mundo. Juntos, estamos comprometidos a impulsar un progreso impactante en la industria de la IA y ofrecer un valor incomparable a nuestros clientes y socios en todo el mundo».

Arthur Mensch, director ejecutivo de Mistral AI

Disponibilidad general de la serie de máquinas virtuales Azure NC H100 v5, optimizada para la inferencia generativa y la informática de alto rendimiento

Microsoft también anunció la disponibilidad general de la serie de máquinas virtuales Azure NC H100 v5, diseñada para simulaciones de entrenamiento, inferencia y proceso de alto rendimiento (HPC, por sus siglas en inglés) de rango medio; que ofrece un alto rendimiento y eficiencia.

A medida que las aplicaciones de IA generativa se expandan a una velocidad increíble, los modelos de lenguaje fundamentales que las potencian también se expandirán para incluir tanto SLM como LLM. Además, los modelos de inteligencia artificial estrecha (ANI, por sus siglas en inglés) seguirán con su evolución, centrados en predicciones más precisas en lugar de en la creación de datos novedosos para seguir con las mejoras de sus casos de uso. Sus aplicaciones incluyen tareas como la clasificación de imágenes, la detección de objetos y el procesamiento más amplio del lenguaje natural.

Con las sólidas funcionalidades y la escalabilidad de Azure, ofrecemos herramientas informáticas que permiten a las organizaciones de todos los tamaños, sin importar sus recursos. Las máquinas virtuales Azure NC H100 v5 son otra herramienta informática disponible con carácter general que hará precisamente eso.

La serie de máquinas virtuales Azure NC H100 v5 se basa en la plataforma NVL NVIDIA H100, que ofrece dos clases de máquinas virtuales, que van de una a dos GPU NVIDIA H100 PCIe Tensor Core de 94 GB conectadas por NVLink con 600 GB/s de ancho de banda. Esta serie de máquinas virtuales es compatible con PCIe Gen5, que proporciona las velocidades de comunicación más altas (128 GB/s bidireccionales) entre el procesador host y la GPU. Esto reduce la latencia y la sobrecarga de la transferencia de datos y permite aplicaciones de IA y HPC más rápidas y escalables.

La serie VM también es compatible con la tecnología NVIDIA de GPU de instancias múltiples (MIG, por sus siglas en inglés), lo que permite a los clientes dividir cada GPU en hasta siete instancias, lo que proporciona flexibilidad y escalabilidad para diversas cargas de trabajo de IA. Esta serie de máquinas virtuales ofrece un ancho de banda de red de hasta 80 Gbps y hasta 8 TB de almacenamiento NVMe local en tamaños de máquina virtual de nodo completo.

Estas máquinas virtuales son ideales para entrenar modelos, ejecutar tareas de inferencia y desarrollar aplicaciones de vanguardia. Obtengan más información sobre la serie H100 v5 de Azure NC.

«Snorkel AI se enorgullece de asociarse con Microsoft para ayudar a las organizaciones a aprovechar de forma rápida y rentable el poder de los datos y la IA. La infraestructura de Azure AI ofrece el rendimiento que requieren nuestras cargas de trabajo de ML más exigentes, además de una implementación simplificada y características de administración optimizadas que tanto gustan a nuestros investigadores. Con la nueva serie de máquinas virtuales Azure NC H100 v5 con tecnología de GPU NVL NVIDIA H100, estamos entusiasmados de continuar con el aceleramiento del desarrollo iterativo de datos para empresas y usuarios de OSS por igual».

Paroma Varma, cofundadora y jefa de investigación de Snorkel AI

Microsoft y NVIDIA ofrecen avances para el cuidado de la salud y las ciencias de la vida

Microsoft amplía su colaboración con NVIDIA para ayudar a transformar la industria de la salud y las ciencias de la vida a través de la integración de la nube, la IA y la supercomputación.

Mediante el uso de la escala global, la seguridad y las capacidades informáticas avanzadas de Azure y Azure AI, junto con la nube DGX de NVIDIA y la suite NVIDIA Clara, los proveedores de atención médica, las empresas farmacéuticas y biotecnológicas, y los desarrolladores de dispositivos médicos ahora pueden acelerar de manera rápida la innovación en toda la cadena de valor de la investigación clínica para la prestación de atención en beneficio de los pacientes de todo el mundo. Más información.

Las nuevas API de Omniverse permiten a los clientes de todas las industrias incorporar capacidades masivas de gráficos y visualización

A partir de hoy, la plataforma Omniverse de NVIDIA para el desarrollo de aplicaciones 3D estará disponible como un conjunto de API que se ejecutan en Microsoft Azure, lo que permitirá a los clientes integrar capacidades avanzadas de gráficos y visualización en las aplicaciones de software existentes de Microsoft y los ISV de sus socios.

Basadas en OpenUSD, un intercambio universal de datos, las API de NVIDIA Omniverse Cloud en Azure hacen el trabajo de integración para los clientes, brindándoles capacidades de renderizado basadas en la física sin problemas en el front-end. Para demostrar el valor de estas API, Microsoft y NVIDIA han trabajado con Rockwell Automation y Hexagon para mostrar cómo se pueden combinar los mundos físico y digital para aumentar la productividad y la eficiencia. Más información.

Microsoft y NVIDIA prevén una integración más profunda de NVIDIA DGX Cloud con Microsoft Fabric

Las dos compañías también colaboran para unir la computación en la nube NVIDIA DGX y Microsoft Fabric para impulsar las cargas de trabajo de datos más exigentes de los clientes. Esto significa que los tiempos de ejecución optimizados específicos de la carga de trabajo de NVIDIA, los LLM y el aprendizaje automático funcionarán a la perfección con Fabric.

La integración de NVIDIA DGX Cloud y Fabric incluye la ampliación de las capacidades de Fabric mediante la incorporación de la personalización del modelo de lenguaje grande de NVIDIA DGX Cloud para abordar casos de uso intensivo de datos, como gemelos digitales y pronósticos meteorológicos con Fabric OneLake como almacenamiento de datos subyacente. La integración también proporcionará DGX Cloud como una opción para que los clientes aceleren sus cargas de trabajo de ciencia de datos e ingeniería de datos de Fabric.

Acelerar la innovación en la era de la IA

Durante años, Microsoft y NVIDIA han colaborado desde el hardware hasta los sistemas y las máquinas virtuales, para crear soluciones nuevas e innovadoras habilitadas para IA para abordar desafíos complejos en la nube. Microsoft continuará con la expansión y la mejora de su infraestructura global con la tecnología más avanzada en cada capa de la pila, para ofrecer un rendimiento y escalabilidad mejorados para las cargas de trabajo en la nube y de IA y capacitar a los clientes para lograr más en todas las industrias y dominios.

Únanse a Microsoft en la Conferencia de IA de NVIDIA CTA, del 18 al 21 de marzo, en el stand #1108 y asistan a una sesión para obtener más información sobre las soluciones en Azure y NVIDIA.