Por: Brad Smith. presidente.

Nota del editor: esta publicación es un capítulo escrito por el presidente de Microsoft, Brad Smith, para el informe de Microsoft IA en Europa: aprovechar la oportunidad en toda la Unión Europea (UE). Las ideas expresadas aquí se trataron en su discurso de apertura en el evento «La transformación digital de Europa: aceptar la oportunidad de la IA» en Bruselas el 29 de junio de 2023.

Pueden leer el informe global Governing AI: A Blueprint for the Future aquí.

Existen enormes oportunidades para aprovechar el poder de la IA para contribuir al crecimiento y los valores europeos. Pero otra dimensión es igual de clara. No es suficiente centrarse solo en las muchas oportunidades de usar la IA para mejorar la vida de las personas. Necesitamos enfocarnos con igual determinación en los desafíos y riesgos que la IA puede crear, y debemos gestionarlos de manera efectiva.

Esta es quizás una de las lecciones más importantes del papel de las redes sociales. Hace poco más de una década, tecnólogos y comentaristas políticos se entusiasmaron con el papel de las redes sociales en la difusión de la democracia durante la Primavera Árabe. Sin embargo, cinco años después, aprendimos que las redes sociales, como tantas otras tecnologías anteriores, se convertirían tanto en un arma como en una herramienta, en este caso, dirigida a la democracia misma.

Hoy, somos 10 años mayores y más sabios, y necesitamos poner esa sabiduría a trabajar. Necesitamos pensar desde el principio y con lucidez sobre los problemas que podrían surgir. A medida que avanza la tecnología, es tan importante garantizar un control adecuado sobre la IA como perseguir sus beneficios. Estamos comprometidos y decididos como empresa a desarrollar e implementar IA de manera segura y responsable. Sin embargo, también reconocemos que las barandillas necesarias para la IA requieren un sentido de responsabilidad compartido de manera amplia y no deben dejarse solo en manos de las empresas de tecnología. En resumen, las empresas tecnológicas deberán intensificar y los gobiernos deberán moverse más rápido.

Cuando en Microsoft adoptamos nuestros seis principios éticos para la IA en 2018, notamos que un principio era la base de todo lo demás: la responsabilidad. Esta es la necesidad fundamental de garantizar que las máquinas permanezcan sujetas a una supervisión efectiva por parte de las personas, y que las personas que diseñan y operan las máquinas se mantengan responsables ante todos los demás. En resumen, siempre debemos asegurarnos de que la IA permanezca bajo control humano. Esta debe ser una prioridad de primer orden tanto para las empresas de tecnología como para los gobiernos.

Esto conecta de manera directa con otro concepto esencial. En una sociedad democrática, uno de nuestros principios fundacionales es que ninguna persona está por encima de la ley. Ningún gobierno está por encima de la ley. Ninguna empresa está por encima de la ley, y ningún producto o tecnología debe estar por encima de la ley. Esto lleva a una conclusión crítica: las personas que diseñan y operan sistemas de IA no pueden rendir cuentas a menos que sus decisiones y acciones estén sujetas al estado de derecho.

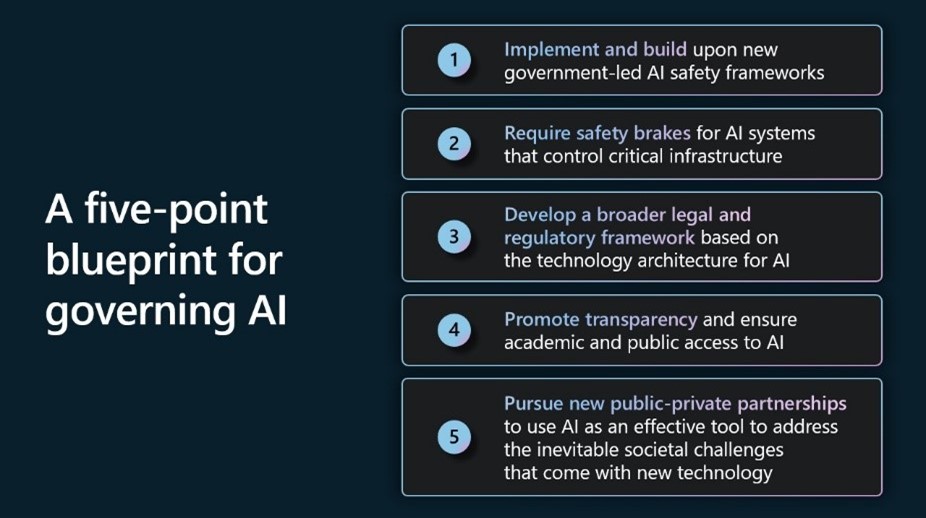

En mayo, Microsoft publicó un documento técnico, Governing AI: A Blueprint for the Future, que buscaba abordar la cuestión de cómo gobernamos mejor la IA y establecía el plan de cinco puntos de Microsoft.

El plan se basa en las lecciones aprendidas de muchos años de trabajo, inversión y aportes. Aquí, reunimos parte de ese pensamiento con un enfoque específico en Europa, su liderazgo en la regulación de la IA y cómo puede ser un camino viable para avanzar en la gobernanza de la IA a nivel internacional.

Con la reciente votación del Parlamento Europeo sobre la Ley de Inteligencia Artificial (IA) de la Unión Europea y las discusiones tripartitas en curso, Europa ahora está a la vanguardia del establecimiento de un modelo para guiar y regular la tecnología de IA.

Desde el principio, hemos apoyado un régimen regulatorio en Europa que aborde de manera efectiva la seguridad y defienda los derechos fundamentales mientras no deja de permitir innovaciones que garantizarán que Europa se mantenga competitiva a nivel mundial. Nuestra intención es ofrecer contribuciones constructivas para ayudar a informar el trabajo por delante. La colaboración con líderes y legisladores de toda Europa y de todo el mundo es importante y esencial.

En este espíritu, aquí queremos ampliar nuestro plan de cinco puntos, resaltar cómo se alinea con las discusiones de la Ley de IA de la UE y brindar algunas ideas sobre las oportunidades para construir sobre esta base regulatoria.

Primero, implementar y desarrollar nuevos marcos de seguridad liderados por el gobierno

Una de las formas más efectivas de acelerar la acción del gobierno es aprovechar los marcos gubernamentales existentes o emergentes para promover la seguridad de la IA.

Un elemento clave para garantizar el uso más seguro de esta tecnología es un enfoque basado en el riesgo, con procesos definidos en torno a la identificación y mitigación de riesgos, así como sistemas de prueba antes de la implementación. La Ley AI establece dicho marco y será un importante punto de referencia para el futuro. En otras partes del mundo, otras instituciones han avanzado en un trabajo similar, como el Marco de Gestión de Riesgos de IA desarrollado por el Instituto Nacional de Estándares y Tecnología de EE. UU., o NIST, y el nuevo estándar internacional ISO/IEC 42001 sobre Sistemas de Gestión de IA, que Se espera que se publique en el otoño de 2023.

Microsoft se ha comprometido a implementar el marco de gestión de riesgos de IA del NIST e implementaremos futuros estándares internacionales relevantes, incluidos los que surgirán después de la Ley de IA. Las oportunidades para alinear dichos marcos a nivel internacional deberían seguir siendo una parte importante del diálogo en curso entre la UE y los EE. UU.

A medida que la UE finalice la Ley de IA, la UE podría considerar el uso de reglas de contratación para promover el uso de marcos de IA confiables y relevantes. Por ejemplo, al adquirir sistemas de IA de alto riesgo, las autoridades de contratación de la UE podrían exigir a los proveedores que certifiquen mediante auditorías de terceros que cumplen con las normas internacionales pertinentes.

Reconocemos que el ritmo de los avances de la IA plantea nuevas preguntas y problemas relacionados con la seguridad y la protección, y estamos comprometidos a trabajar con otros para desarrollar estándares prácticos que ayuden a evaluar y abordar esas preguntas importantes. Esto incluye estándares nuevos y adicionales relacionados con modelos básicos de alta capacidad.

En segundo lugar, exigir frenos de seguridad efectivos para los sistemas de IA que controlan la infraestructura crítica

Cada vez más, el público debate cuestiones sobre el control de la IA a medida que se vuelve más poderosa. Del mismo modo, existen preocupaciones con respecto al control de IA de infraestructura crítica como la red eléctrica, el sistema de agua y los flujos de tráfico de la ciudad. Ahora es el momento de discutir estos temas, un debate que ya está en marcha en Europa, donde los desarrolladores de sistemas de IA de alto riesgo serán responsables de garantizar que se implementen las medidas de seguridad necesarias.

Nuestro plan propone nuevos requerimientos de seguridad que, en efecto, crearían frenos de seguridad para los sistemas de IA que controlan el funcionamiento de la infraestructura crítica designada. Estos sistemas a prueba de fallas serían parte de un enfoque integral para la seguridad del sistema que mantendría en mente la supervisión humana efectiva, la resiliencia y la solidez. Serían similares a los sistemas de frenado que los ingenieros han integrado durante mucho tiempo en otras tecnologías, como ascensores, autobuses escolares y trenes de alta velocidad, para gestionar de forma segura no solo los escenarios cotidianos, sino también las emergencias.

En este enfoque, el gobierno definiría la clase de sistemas de IA de alto riesgo que controlan la infraestructura crítica y garantizan tales medidas de seguridad como parte de un enfoque integral para la gestión del sistema. Las nuevas leyes requerirían que los operadores de estos sistemas construyan frenos de seguridad en los sistemas de inteligencia artificial de alto riesgo por diseño. Luego, el gobierno obligaría a los operadores a probar los sistemas de alto riesgo con regularidad. Y estos sistemas se implementarían solo en centros de datos de IA con licencia que proporcionarían una segunda capa de protección y garantizarían la seguridad.

Tercero, desarrollar un amplio marco legal y regulatorio basado en la arquitectura tecnológica para la IA

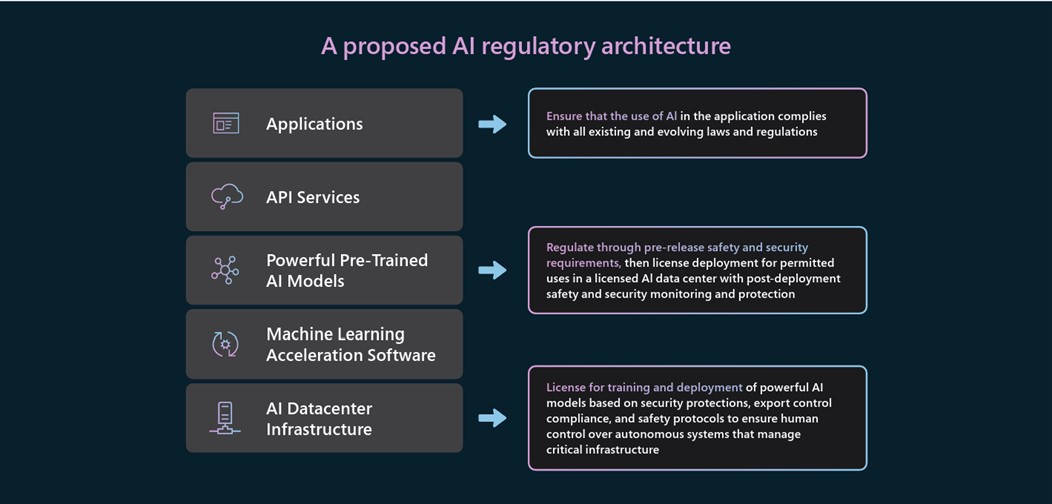

Como trabajamos el año pasado con modelos de IA en la frontera de esta nueva tecnología, llegamos a la conclusión de que es fundamental desarrollar una arquitectura legal y reglamentaria para la IA que refleje la arquitectura tecnológica de la propia IA.

Las responsabilidades regulatorias deben asignarse a diferentes actores en función de su papel en la gestión de diferentes aspectos de la tecnología de IA. Aquellos más cercanos a las decisiones relevantes sobre diseño, implementación y uso están mejor ubicados para cumplir con las responsabilidades correspondientes y mitigar los riesgos respectivos, ya que comprenden mejor el contexto específico y el caso de uso. Esto suena sencillo, pero como han demostrado los debates en la UE, no siempre es fácil.

La Ley de IA reconoce los desafíos de regular la arquitectura compleja a través de su enfoque basado en el riesgo para establecer requisitos para sistemas de alto riesgo. En la capa de aplicación, esto significa aplicar y hacer cumplir las reglamentaciones existentes y, al mismo tiempo, ser responsable de cualquier nueva implementación o consideraciones de uso específicas de la IA.

También es importante asegurarse de que las obligaciones estén vinculadas a modelos de IA potentes, con un enfoque en una clase definida de modelos básicos bastante capaces y calibrados para el riesgo a nivel de modelo. Esto tendrá un impacto en dos capas de la pila de tecnología. El primero requerirá nuevas regulaciones para estos modelos en sí. Y la segunda supondrá obligaciones para los operadores de infraestructuras de IA sobre las que se desarrollen y desplieguen estos modelos. El plan que desarrollamos ofrece objetivos y enfoques sugeridos para cada una de estas capas.

Los diferentes roles y responsabilidades requieren un apoyo conjunto. Estamos comprometidos a ayudar a nuestros clientes a aplicar los principios «Conozca a su cliente» (Know Your Customer – KYC, por sus siglas en inglés) a través de nuestro Programa de Garantía de IA anunciado de manera reciente. Las instituciones financieras utilizan este marco para verificar las identidades de los clientes, establecer perfiles de riesgo y monitorear transacciones para ayudar a detectar actividades sospechosas. Como detalla Antony Cook, creemos que este enfoque puede aplicarse a la IA en lo que llamamos «KY3C»: conocer su nube, sus clientes y su contenido. La Ley AI no incluye de manera expresa los requisitos de KYC, pero creemos que dicho enfoque será clave para cumplir tanto con el espíritu como con las obligaciones de la ley.

La Ley de IA requiere que los desarrolladores de sistemas de alto riesgo implementen un sistema de gestión de riesgos para garantizar que los sistemas se prueben, para mitigar los riesgos en la medida de lo posible, incluso a través del diseño y desarrollo responsable, y para participar en el seguimiento posterior al mercado. Apoyamos esto en su totalidad. El hecho de que la Ley de AI aún no se haya finalizado no debería impedirnos aplicar algunas de estas prácticas hoy. Incluso antes de que se implemente la Ley de IA, probaremos todos nuestros sistemas de IA antes del lanzamiento y utilizaremos equipos rojos para hacerlo en sistemas de alto riesgo.

Cuarto, promover la transparencia y garantizar el acceso académico y sin fines de lucro a la IA.

También es fundamental avanzar en la transparencia de los sistemas de IA y ampliar el acceso a los recursos de IA. Si bien existen algunas tensiones inherentes entre la transparencia y la necesidad de seguridad, existen muchas oportunidades para hacer que los sistemas de IA sean más transparentes. Es por eso que Microsoft se ha comprometido con un informe anual de transparencia de IA y otros pasos para expandir la transparencia de nuestros servicios de IA.

La Ley de IA requerirá que los proveedores de IA aclaren a los usuarios que interactúan con un sistema de IA. Del mismo modo, siempre que se utilice un sistema de IA para crear contenido generado de manera artificial, debería ser fácil de identificar. Apoyamos esto por completo. El contenido engañoso generado por IA o “deepfakes”, en especial el contenido audiovisual que se hace pasar por figuras políticas, es motivo de especial preocupación en términos de su daño potencial a la sociedad y al proceso democrático.

Al abordar este problema, podemos comenzar con los componentes básicos que ya existen. Uno de ellos es la Coalición para la Autenticidad de la Procedencia del Contenido, o C2PA, un organismo de estándares globales con más de 60 miembros, incluidos Adobe, BBC, Intel, Microsoft, Publicis Groupe, Sony y Truepic. El grupo se dedica a reforzar la confianza y la transparencia de la información en línea, incluida la publicación de la primera especificación técnica del mundo para certificar contenido digital en 2022, que ahora incluye soporte para IA generativa. Como dijo el director científico de Microsoft, Eric Horvitz, el año pasado: «Creo que la procedencia del contenido desempeñará un papel importante en el fomento de la transparencia y el fortalecimiento de la confianza en lo que vemos y escuchamos en línea».

Habrá oportunidades en los próximos meses para dar pasos importantes juntos en ambos lados del Atlántico y a nivel mundial para avanzar en estos objetivos. Microsoft pronto implementará nuevas herramientas de procedencia de última generación para ayudar al público a identificar contenido audiovisual generado por IA y comprender su origen. En Build 2023, nuestra conferencia anual para desarrolladores, anunciamos el desarrollo de un nuevo servicio de procedencia de medios. El servicio, que implementa la especificación C2PA, marcará y firmará videos e imágenes generados por IA con metadatos sobre su origen, lo que permitirá a los usuarios verificar que un contenido es generado por IA. Microsoft admitirá en un inicio los principales formatos de imagen y video y lanzará el servicio para su uso con dos de los nuevos productos de IA de Microsoft, Microsoft Designer y Bing Image Creator. Los requisitos de transparencia en la Ley de IA, y, de manera potencial, varios de los estándares que se desarrollarán relacionados con la Ley, presentan una oportunidad para aprovechar tales iniciativas de la industria hacia un objetivo compartido.

También creemos que es fundamental ampliar el acceso a los recursos de IA para la investigación académica y la comunidad sin fines de lucro. A menos que los investigadores académicos puedan obtener acceso a muchos más recursos informáticos, existe un riesgo real de que la investigación científica y tecnológica se vea afectada, incluida la relacionada con la propia IA. Nuestro plan requiere nuevos pasos, incluidos los que tomaremos en todo Microsoft, para abordar estas prioridades.

En quinto lugar, buscar nuevas asociaciones público-privadas para utilizar la IA como una herramienta eficaz para abordar los inevitables desafíos sociales que surgen con la nueva tecnología.

Una lección de los últimos años es que las sociedades democráticas a menudo pueden lograr más cuando aprovechan el poder de la tecnología y unen a los sectores público y privado. Es una lección que debemos aprovechar para abordar el impacto de la IA en la sociedad.

La IA es una herramienta extraordinaria. Pero, al igual que otras tecnologías, también puede convertirse en un arma poderosa, y habrá algunos en todo el mundo que buscarán usarla de esa manera. Necesitamos trabajar juntos para desarrollar tecnologías defensivas de inteligencia artificial que crearán un escudo que pueda resistir y derrotar las acciones de cualquier mal actor en el planeta.

Ahora se necesita un trabajo importante para usar la IA para proteger la democracia y los derechos fundamentales, proporcionar un amplio acceso a las habilidades de IA que promoverán el crecimiento inclusivo y utilizar el poder de la IA para promover las necesidades de sostenibilidad del planeta. Quizás más que nada, una ola de nueva tecnología de IA brinda una ocasión para pensar en grande y actuar con audacia. En cada área, la clave del éxito será desarrollar iniciativas concretas y reunir a gobiernos, empresas y ONG para promoverlas. Microsoft hará su parte en cada una de estas áreas.

Asociación internacional para promover la gobernanza de la IA

El inicio temprano de Europa hacia la regulación de la IA ofrece la oportunidad de establecer un marco legal efectivo, basado en el estado de derecho. Pero más allá de los marcos legislativos a nivel de los estados nacionales, se necesita una asociación público-privada multilateral para garantizar que la gobernanza de la IA pueda tener un impacto hoy, no solo dentro de unos años, y a nivel internacional.

Esto es importante para servir como una solución provisional antes de que entren en vigor regulaciones como la Ley de IA, pero, quizás lo más importante, nos ayudará a trabajar hacia un conjunto común de principios compartidos que pueden guiar tanto a los estados nacionales como a las empresas.

En paralelo al enfoque de la UE en la Ley de AI, existe una oportunidad para que la Unión Europea, los Estados Unidos, los otros miembros del G7, así como India e Indonesia, avancen juntos en un conjunto de valores y principios compartidos. Si podemos trabajar con otros de forma voluntaria, entonces todos avanzaremos más rápido y con mayor cuidado y enfoque. Esas no son solo buenas noticias para el mundo de la tecnología, son buenas noticias para el mundo en general.

Es importante trabajar hacia un enfoque coherente a nivel mundial, para reconocer que la IA, como muchas tecnologías, se desarrolla y se utilizará a través de las fronteras. Y permitirá que todos, con los controles adecuados establecidos, accedan a las mejores herramientas y soluciones para sus necesidades.

Nos sentimos muy alentados por los recientes pasos internacionales, incluido el Consejo de Comercio y Tecnología (TTC) UE-EE. UU. a fines de mayo, que anunció una nueva iniciativa para desarrollar un Código de conducta voluntario de IA. Esto puede reunir a socios privados y públicos para implementar estándares internacionales no vinculantes sobre transparencia de IA, gestión de riesgos y otros requisitos técnicos para empresas que desarrollan sistemas de IA. Del mismo modo, en la Cumbre anual del G7 en Hiroshima en mayo de 2023, los líderes se comprometieron a “avanzar en los debates internacionales sobre la gobernanza e interoperabilidad de la inteligencia artificial (IA) inclusiva para lograr nuestra visión y objetivo comunes de una IA confiable, en línea con nuestros valores democráticos compartidos”. Microsoft apoya y respalda por completo los esfuerzos internacionales para desarrollar dicho código voluntario. El desarrollo tecnológico y el interés público se beneficiarán de la creación de barandillas a nivel de principio, incluso si en un inicio no son vinculantes.

Para que los diferentes aspectos de la gobernanza de la IA funcionen a nivel internacional, necesitaremos un marco multilateral que conecte varias normas nacionales y garantice que un sistema de IA certificado como seguro en una jurisdicción también pueda calificar como seguro en otra. Hay muchos precedentes efectivos para esto, como los estándares de seguridad comunes establecidos por la Organización de Aviación Civil Internacional, lo que significa que no es necesario reacondicionar un avión en pleno vuelo de Bruselas a Nueva York.

En nuestra opinión, un código internacional debería:

- Aprovechar el trabajo ya realizado en la OCDE para desarrollar principios para una IA confiable

- Proporcionar un medio para que los desarrolladores de IA regulados den fe de la seguridad de estos sistemas frente a los estándares acordados a nivel internacional.

- Promover la innovación y el acceso a través de un medio para el reconocimiento mutuo del cumplimiento y la seguridad a través de las fronteras

Antes de que entren en vigor la Ley de IA y otras reglamentaciones formales, es importante que tomemos medidas hoy para implementar frenos de seguridad para los sistemas de IA que controlan la infraestructura crítica. El concepto de frenos de seguridad, junto con la concesión de licencias para modelos básicos de alta capacidad y las obligaciones de infraestructura de IA, deberían ser elementos clave del código G7 voluntario coordinado a nivel internacional, que los estados nacionales signatarios acuerdan incorporar a sus sistemas nacionales. Los sistemas de IA de alto riesgo, relacionados con infraestructura crítica (p. ej., transporte, redes eléctricas, sistemas de agua) o sistemas que pueden conducir a graves violaciones de los derechos fundamentales u otros daños significativos, podrían requerir agencias reguladoras internacionales adicionales, según el modelo de International Organización de Aviación Civil, por ejemplo.

La Ley AI crea una disposición para una base de datos de la UE para sistemas de alto riesgo. Creemos que es un enfoque importante y debería ser una consideración para el código internacional. Desarrollar un enfoque global, conjunto y coherente tiene mucho sentido para todos los involucrados en el desarrollo, uso y regulación de la IA.

Por último, debemos asegurarnos de que los investigadores académicos tengan acceso para estudiar los sistemas de IA en profundidad. Hay importantes preguntas de investigación abiertas en torno a los sistemas de IA, incluida la forma en que se evalúan de manera adecuada en las dimensiones de IA responsable, la mejor manera de hacer que sean explicables y la mejor manera de alinearse con los valores humanos. El trabajo que realiza la OCDE en la evaluación de los sistemas de IA experimenta un buen progreso. Pero existe la oportunidad de ir más lejos y más rápido a través de fomentar la colaboración de investigación internacional e impulsar los esfuerzos de las comunidades académicas al alimentar ese proceso. La UE está bien posicionada para liderar esto, asociándose con los EE. UU.

La gobernanza de la IA es un recorrido, no un destino. Nadie tiene todas las respuestas y es importante que escuchemos, aprendamos y colaboremos. Un diálogo sólido y saludable entre la industria tecnológica, los gobiernos, las empresas, el mundo académico y las organizaciones de la sociedad civil es vital para garantizar que la gobernanza se mantenga al ritmo de la velocidad a la que se desarrolla la IA. Juntos, podemos ayudar a materializar el potencial de la IA para ser una fuerza positiva para el bien.