Le ministère de l’éducation d’Australie-Méridionale a voulu tester l’IA générative dans ses écoles au début de l’année. Mais il devait d’abord résoudre un problème : comment le faire de façon responsable ?

Simon Chapman, qui s’occupe de l’architecture numérique au ministère, a dit que le principal défi était de protéger les élèves des contenus qui peuvent être nocifs ou inappropriés et qui peuvent apparaître dans les productions d’un grand modèle de langage, car il a été entraîné sur de grandes parties non filtrées de l’internet.

“Il n’y a pas beaucoup d’options pour l’éducation dans les versions publiques de l’IA générative”, a-t-il affirmé. “Il n’y a pas de contrôle sur la façon dont les étudiants peuvent interagir avec elles ».

Le ministère est en train de finaliser un projet pilote d’EdChat, un chatbot basé sur l’IA. Environ 1 500 élèves et 150 enseignants de huit collèges ont expérimenté le chatbot pour les aider dans leurs recherches, de la mitose à l’histoire de “Des souris et des hommes” de John Steinbeck.

Le ministère n’a pas encore fini d’analyser les résultats, a indiqué M. Chapman. Mais le système Microsoft qu’il a utilisé comme contrôle a été bien accueilli : Azure AI Content Safety, une plateforme basée sur l’IA pour aider les organisations à créer des espaces en ligne plus sécurisés.

Les fonctions de sécurité intégrées d’EdChat bloquent les requêtes inappropriées et filtrent les réponses dangereuses, ce qui permet aux enseignants de se concentrer sur les aspects pédagogiques de la technologie au lieu de contrôler le contenu.

“Il aurait été impossible de progresser aussi vite si le service de sécurité du contenu n’avait pas été intégré dès le premier jour”, a déclaré M. Chapman. “C’est indispensable”.

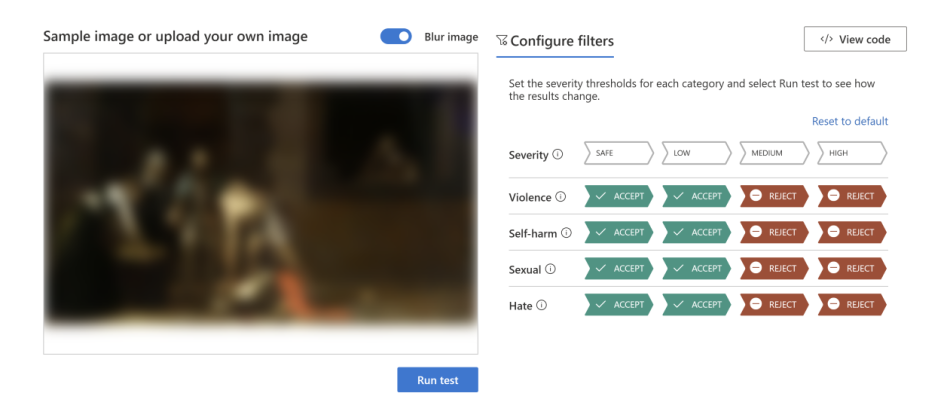

Microsoft a annoncé aujourd’hui la disponibilité générale d’Azure AI Content Safety dans Azure AI, qui utilise des modèles de langage et de vision avancés pour aider à détecter les contenus haineux, violents, sexuels et d’automutilation. Lorsque les modèles détectent un contenu potentiellement dangereux, ils le marquent avec un score de gravité estimé. Cela permet aux entreprises et aux organisations d’adapter le service pour bloquer ou signaler le contenu en fonction de leurs politiques.

Initialement intégré à Azure OpenAI Service, Azure AI Content Safety est désormais un service indépendant. Cela signifie que les clients peuvent l’utiliser pour le contenu généré par l’IA à partir de modèles open-source et de modèles d’autres entreprises, ainsi que pour le contenu généré par l’utilisateur dans le cadre de leurs systèmes de contenu.

“Nous vivons actuellement un moment extraordinaire où les entreprises découvrent l’incroyable puissance de l’IA générative.”

Alors que l’IA générative se généralise, Microsoft entend doter les entreprises des outils nécessaires pour la déployer en toute sécurité.

“Nous vivons actuellement un moment extraordinaire où les entreprises découvrent l’incroyable puissance de l’IA générative”, a déclaré Eric Boyd, vice-président de Microsoft AI Platform. “Le lancement d’Azure AI Content Safety en tant que service propre signifie que nous pouvons répondre au mieux aux besoins de nos clients.”

Cette annonce illustre ainsi comment Microsoft applique ses principes de création d’une IA responsable. L’entreprise dispose d’une équipe de près de 350 personnes dédiées à l’IA responsable. Microsoft a plaidé en faveur d’une gouvernance responsable de l’IA et soutenu les engagements volontaires de la Maison-Blanche en matière d’IA ; l’entreprise a repoussé les limites de la recherche sur l’IA responsable afin de guider le développement de ses produits et solutions, ; elle a publié une norme d’IA responsable pour la conception, la construction et le test des systèmes d’IA ; et elle a mis à la disposition des clients des outils tels que le tableau de bord de l’IA responsable dans Azure Machine Learning.

“Cela fait partie intégrante de notre histoire d’innovation en matière d’IA. Nous mettons à disposition les meilleurs outils pour trouver comment relever ces défis de l’IA responsable”, a expliqué Sarah Bird, en charge de l’IA responsable pour les technologies fondamentales. “Azure AI Content Safety est un élément clé qui nous permet de rendre nos applications d’IA générative accessibles à davantage de clients”.

Personnalisable pour différents cas d’usage

Pour sécuriser ses utilisateurs contre les contenus dangereux générés par l’IA, Microsoft se sert de sa propre technologie Azure AI Content Safety dans ses produits qui utilisent l’IA, comme Bing, GitHub Copilot, Microsoft 365 Copilot et Azure Machine Learning.

L’IA responsable est un enjeu majeur pour toutes les organisations et tous les domaines d’activité, face à la profusion de contenus disponibles. C’est pourquoi Azure AI Content Safety offre l’avantage de permettre des réglages personnalisés. Les politiques peuvent être ajustées en fonction du contexte et des besoins spécifiques de chaque client. Par exemple, une plateforme dédiée aux jeux aura des critères différents sur des aspects comme le langage violent, par rapport à une plateforme utilisée pour l’éducation scolaire.

Shell, l’entreprise d’énergie, a créé une plateforme d’IA génératrice appelée Shell E. Elle permet aux équipes d’utiliser des modèles de langage open source et d’autres modèles à grande échelle pour développer des applications qui facilitent la recherche et la récupération d’informations par les employés dans le cadre de leurs activités. Selon Siva Chamarti, responsable technique principal des systèmes d’IA chez Shell, Shell E vise à aider les travailleurs à exploiter plus efficacement les connaissances de l’entreprise. Les applications couvrent tous les domaines de Shell et incluent la création, le résumé et la traduction de contenu, la génération et la vérification de code, ainsi que la gestion des connaissances dans tous les domaines techniques. Les équipes explorent aussi des applications plus avancées comme la création de molécules.

Azure AI Content Safety assure la gouvernance de la plateforme Shell E en permettant la production de textes et d’images tout en évitant les réponses inappropriées ou nuisibles, a-t-il ajouté. L’outil contrôle que chaque entrée et sortie respecte la politique avant de laisser le contenu produit atteindre les utilisateurs.

Selon Siva Chamarti, l’intérêt pour la génération par l’IA est croissant : “Nous en sommes encore aux débuts, mais les collègues suggèrent des applications innovantes dans leurs domaines respectifs, et notre liste d’exemples d’utilisation continue de s’étendre.”

Instaurer la confiance à l’ère de l’IA

Alors que l’adoption de l’IA générative se fait de plus en plus massive, les menaces potentielles qui pèsent sur les espaces en ligne se multiplient. Dans ce contexte, Microsoft travaille à l’amélioration en continu de ses outils de protection notamment grâce aux retours des clients mais également en investissant dans la recherche. Ainsi, le travail sur les modèles multimodaux vise à renforcer la détection des combinaisons d’images et de textes potentiellement répréhensibles – comme les mèmes – qui peuvent échapper aux vérifications individuelles.

Depuis plusieurs décennies, Microsoft est engagé au service de la modération des contenus et de la protection des utilisateurs depuis les forums Xbox à Bing. Cette expertise, comme celle d’Azure Content Moderator, service qui permet aux clients de paramétrer leurs outils de modération, ont permis de développer Azure AI Content Safety qui intègre en outre de nouveaux modèles de langage et de vision.

Sarah Boyd a affirmé que “Microsoft et Azure ont toujours fait de la confiance un élément essentiel de leur marque”. “Nous renforçons sans cesse nos mesures pour garantir la protection de nos clients, à l’heure où l’IA prend de plus en plus d’importance.”

Ressources complémentaires

- En savoir plus : Azure AI Content Safety

- Reflecting on our responsible AI program: Three critical elements for progress

- Announcing Microsoft’s AI Customer Commitments

- Our commitments to advance safe, secure, and trustworthy AI

- Learning in the AI era: How South Australia’s Department for Education is empowering students and teachers with AI in the classroom

Image du haut : Une élève et une enseignante de la Mitcham Girls High School d’Adélaïde travaillent avec EdChat, un chatbot alimenté par l’IA qui utilise Azure AI Content Safety pour aider à protéger les élèves contre les risques de production de contenu inapproprié ou préjudiciable par des grands modèles de langage. Photo reproduite avec l’aimable autorisation du ministère de l’Éducation de l’Australie-Méridionale.