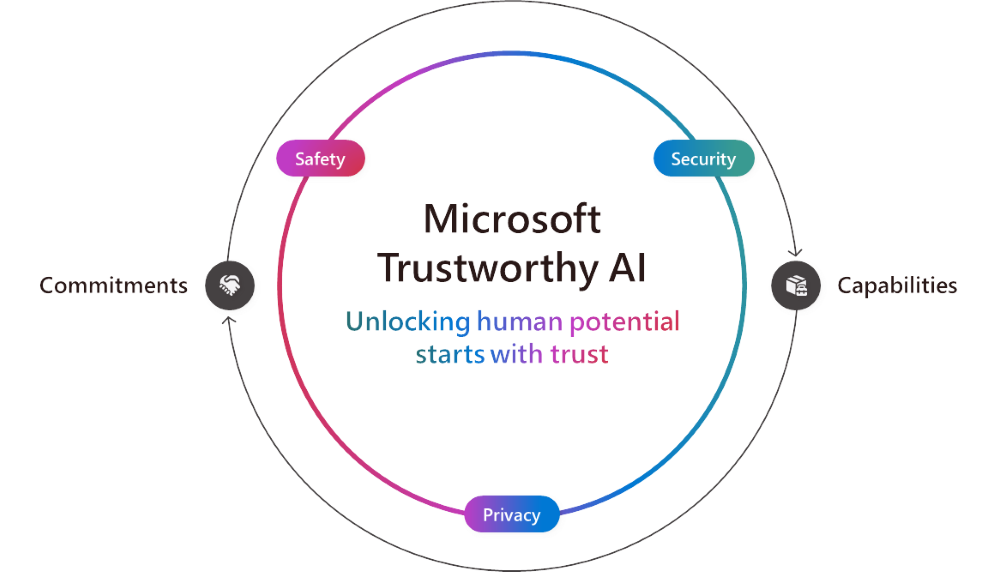

隨著AI的進步,我們每個人就發揮AI對全球企業及社區的影響力扮演著重要的角色。因此,我們專注幫助客戶使用及建立值得信賴的AI,確保其AI受保障、具安全性及私隱性。

在Microsoft,我們致力確保可信任AI,並提供領先業界的支援技術。我們的承諾與能力並駕齊驅,以確保客戶和開發人員受到不同層面的保障。

憑藉我們一貫的承諾,我們今天宣佈全新產品功能,以加強AI系統的保障、安全及私隱。

保障(Security):在 Microsoft,我們一直將安全放在首位,而我們延伸的「安全未來倡議」(Secure Future Initiative, SFI) 強調全公司對保障客戶安全的承諾和責任。本週,我們發佈了首份 SFI 進展報告,重點介紹在企業文化、管治、技術和營運方面的最新進展。這亦印證了我們將安全放在首位的承諾,並遵循三大原則,包括設計安全、安全性預設,以及安全作業。除了我們的自家產品 Microsoft Defender 和 Purview 外,我們的 AI 服務亦有基本的安全控制,例如幫助防止指令注入 (prompt injections)及侵犯版權的内建功能。在此基礎上,我們今天宣佈兩項全新功能:

- Azure AI Studio 的Evaluations功能以支援主動式風險評估。

- Microsoft 365 Copilot 將提供對網頁查詢的透明度,協助管理員和用戶更清楚了解網頁搜尋如何改善 Copilot 的回應。此功能即將推出。

我們的安全功能已被客戶廣泛採用。擁有 105 年歷史的康明斯公司(Cummins),以其引擎製造及清潔能源技術開發聞名,選擇了 Microsoft Purview ,通過自動化數據分類、標籤和標記,加強其數據安全和管治。而軟件工程及商業顧問公司EPAM Systems 亦利用 Microsoft 提供的數據保護功能,為 300 名用戶部署了 Microsoft 365 Copilot。 IT 高級總監 J.T. Sodano 表示:「 Microsoft Purview 中配置的信息和數據保護政策同樣適用於 Copilot,因此與其他大型語言模型(LLMs)相比,我們對 Copilot for Microsoft 365更有信心。 」

安全性(Safety):Microsoft 於2018 年制定更廣泛的負責任 AI 原則,涵蓋保安和私隱兩大要素,繼續指引我們橫跨全公司安全地建立和部署 AI。在實踐中,這意味著正確地建立、測試和監測系統,以避免不良行為,例如有害內容、偏見、濫用和其他意外風險等。多年來,我們投放大量資源以建立必要的管治架構、政策、工具和流程,藉此維護這些原則,並同時安全地建立和部署 AI。Microsoft 致力與客戶分享我們在謹守負責任 AI 原則的過程中所學到的知識。Microsoft透過最佳實踐與學習成果,以及提供所需的功能與工具,協助用戶及機構建立與我們所追求的高標準AI 應用程式。

今日,我們宣佈協助客戶追求AI效益並同時降低風險的新功能:

- Microsoft Azure AI Content Safety 中Groundedness檢測工具裡的Correction功能,可在使用者看到幻覺問題之前即時協助修復。

- Embedded Content Safety可讓客戶在裝置上嵌入 Azure AI 內容安全功能,對於雲端連結間斷或無法使用時的裝置情境十分重要。

- Azure AI Studio中的New evaluations幫助客戶評估AI輸出內容的質素和關聯性,以及其AI應用程式輸出受保護資料的頻率。

- Azure AI Content中的Protected Material Detection for Code現已進入預覽階段,有助偵測預先存在的內容與代碼。此功能可協助開發人員探索 GitHub儲存庫中的公開原始代碼,促進合作與提升透明度,並同時作出更明智的編碼決策。

我們很高興見到不同行業的客戶均已採用Microsoft解決方案以建立更安全和可靠的AI 應用程式。例如,3D遊戲平台Unity 運用 Microsoft Azure OpenAI 服務建構AI 助手Muse Chat;Muse Chat透過Azure AI Content Safety中的內容過濾模型以保障負責任的軟件應用,令遊戲開發過程更簡易。另外,座擁將近900個品牌合作夥伴的英國時裝零售商ASOS同樣利用Azure AI Content Safety的內置內容過濾工具,透過 AI 應用程式支援高品質的互動,協助客戶發掘新造型。

我們亦看見教育界善用AI的成果。紐約市公立學校與Microsoft合作發展出一個安全且適合教育情景的聊天系統,目前已於學校試行。同樣地,南澳洲教育局透過 EdChat 將生成式AI帶到課室,藉著相同的基礎架構確保學生與老師都能安全使用。

私隱(Privacy):數據是 AI 的基礎,而 Microsoft 的首要任務是透過我們長久以來的私隱原則確保客戶資料受保護和合規,這些原則包括用戶控制、透明度以及法律和監管保護。為了加強這一點,我們今天宣佈:

- Confidential inferencing 在我們的 Azure OpenAI 服務Whisper 模型中已進入預覽階段,因此客戶可以開發支援可驗證端到端私隱生成式 AI 的應用程式。Confidential inferencing 確保在推斷過程,即受過訓練的 AI模型根據新數據進行預測或決策時,敏感的客戶資料始終保持安全和私密。這對於醫療、金融服務、零售、製造和能源等受高度監管的行業尤其重要。

- 配備 NVIDIA H100 Tensor Core GPUs 的 Azure Confidential VMs 全面可用性允許客戶直接在 GPU 上保護資料,而這建基於我們的機密運算解決方案之上,以確保客戶資料在安全環境中加密和受保護,因此沒有人能在未經許可的情況下訪問資料或系統。

- 專為歐盟和美國而設的Azure OpenAI Data Zones即將推出,並建立在 Azure OpenAI 服務提供的現有數據儲存地,讓生成式 AI 應用程式的資料處理和儲存更易於管理。這項新功能可讓客戶彈性地在一個區域內擴充所有 Azure 區域的生成式 AI 應用程式,同時讓客戶控制歐盟或美國境內的資料處理和儲存。

我們見證客戶對機密運算和機密 GPUs 的興趣和期待與日俱增,其中包括應用程式安全供應商 F5 正在使用配備 NVIDIA H100 Tensor Core GPUs 的 Azure Confidential VMs 建構先進的 AI 驅動安全性解決方案,並同時確保其模型正在分析的數據私隱性。另外,跨國銀行企業加拿大皇家銀行(RBC)已將 Azure 機密運算融入其平台,在保護客戶私隱的同時分析加密資料。伴隨著配備 NVIDIA H100 Tensor Core GPUs 的 Azure 機密 VMs 全面可用性,加拿大皇家銀行現在可以使用這些進階的 AI 工具提升工作效率和開發更強大的 AI 模型。

和值得信任的AI一起成就更多

我們都需要和期待可信任的 AI ,而我們見證當人們被賦能以可信任方式使用 AI時,從豐富員工經驗和重塑業務流程,到重新定義客戶互動,以至重新想像我們的日常生活,一切皆變得可能。隨著提高保障、安全和私隱的新功能推出,我們繼續為客戶提供和建構可信任的 AI 解決方案,以幫助地球上的每個人和機構成就更多。歸根結柢,可信任AI 涵蓋我們在 Microsoft 所做的一切,而且對我們的使命亦是不可或缺的,我們會致力拓展機會、贏得信任、保護基本權利,並在我們所做的每一件事中推進可持續性。

更多相關資訊:

承諾

功能