Microsoft-Forscher arbeiten seit Jahren daran ein Unterwasser-Rechenzentrum zu entwickeln, das schnell einsatzbereit ist, die Umwelt schont und vollkommen autonom betrieben werden kann. Damit soll dem steigenden Bedarf nach Cloud-Infrastruktur in der Nähe von Ballungszentren Rechnung getragen werden. Im Juni 2018 haben die Forscher die zweite Phase im sogenannten „Project Natick“eingeläutet: Am European Marine Energy Centre auf den schottischen Orkney Inseln haben sie einen Prototyp des Unterwasser-Rechenzentrums in der Grösse eines Containers ins Meer gelassen. In dieser Projektphase werden die Vorteile und Herausforderungen, die im täglichen Betrieb aus ökonomischer und logistischer Sicht entstehen, evaluiert. Obwohl sich Wasser und Technik in der Regel nicht vertragen, gibt es viele Gründe, die für ein Rechenzentrum auf dem Meeresgrund sprechen.

Schnellere Datenübertragung aus der Cloud

Mehr als die Hälfte der Menschheit lebt innerhalb eines etwa 200 Kilometer breiten Küstenstreifens. Durch den Betrieb von Rechenzentren in Gewässern nahe diesen Küstenstädten kann die Latenzzeit bei der Datenübertragung aus der Cloud noch mehr beschleunigt werden. Die zunehmende Nutzung von cloudbasierten KI- oder IoT-Szenarien, die viel Rechenleistung und eine hohe Geschwindigkeit bei der Datenübertragung erfordern, wird dadurch erleichtert. Wie wir zuletzt auf der Hannover Messe 2018 gesehen haben, können künstliche Intelligenz (KI) und das Internet der Dinge (IoT) in sämtlichen Anwendungsfeldern, wie etwa Präzisionsmedizin und autonomes Fahren, und Industrien zum Einsatz kommen. Zum Beispiel können cloudbasierte IoT- und KI-Dienste dazu beitragen, die Verkehrssicherheit zu verbessern oder die Produktivität von Unternehmen zu steigern.

„Damit wir künstliche Intelligenz wirklich bereitstellen können, sind wir auf die Cloud angewiesen,“ so Peter Lee, Corporate Vice President AI and Research von Microsoft. „Wenn wir uns dabei innerhalb zweier Datennetzknoten befinden, die alle erreichen, verbessern wir nicht nur unsere Produkte, sondern auch die Produkte unserer Kunden und Partner.”

Noch mehr Infrastruktur bereitstellen für steigende Nachfrage nach Cloud-Lösungen

Ein Netz aus Rechenzentren bildet die Infrastruktur des Cloud Computings. Das heisst: Kunden profitieren durch ein globales Netzwerk aus Datenzentren von Skaleneffekten bei der Speicherung und Verarbeitung von Daten. Die Nachfrage nach solchen Ressourcen steigt an, da Unternehmen ihre IT verstärkt in die Cloud verlagern und sich über das Internet vernetzte, intelligente Geräte und Dienste immer mehr verbreiten. In den vergangenen drei Jahren hat Microsoft die Zahl der verfügbaren Azure-Regionen mehr als verdoppelt. Aktuell hat Microsoft für Azure weltweit 54 Regionen angekündigt, darunter allein 14 in Europa – mehr als jeder andere Cloud-Anbieter auf der Welt.

Project Natick ist deshalb ein weiterer Meilenstein in der Cloud-Strategie von Microsoft, dessen Ziel es ist Unternehmen aller Grössen und Branchen darin zu befähigen, mehr zu erreichen. Zum Beispiel, indem sie ihr Geschäft mit IoT- und KI-Lösungen digital transformieren. Microsoft wird hierfür in den kommenden vier Jahren insgesamt fünf Milliarden US-Dollar allein in das Internet der Dinge (Internet of Things, IoT) investieren.

Nachhaltigkeit: Auf erneuerbare Energien setzen

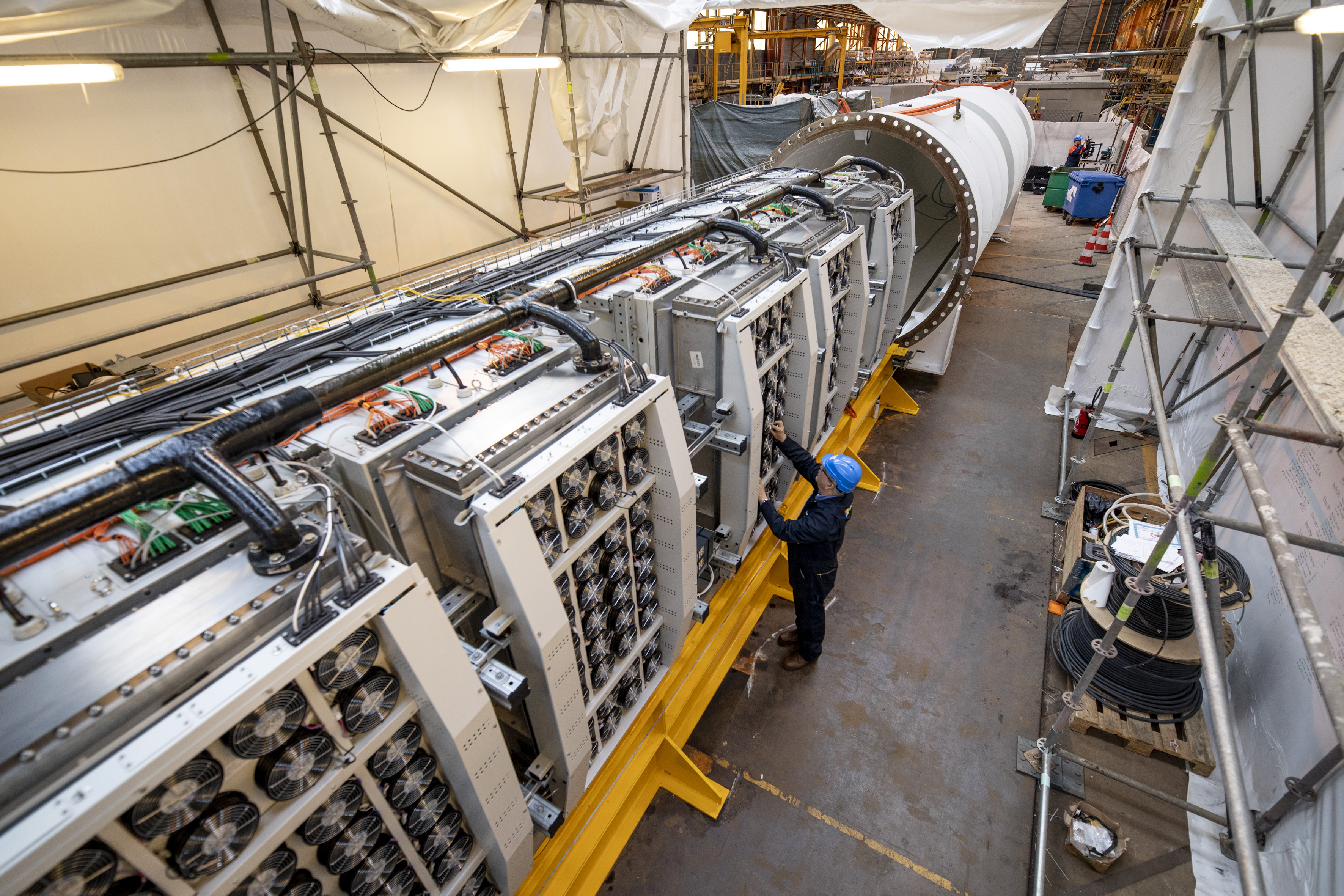

Um von der Kraft des Wassers zu profitieren setzt Microsoft bei der Kühlung des Unterwasser-Rechenzentrums auf ein Wärmeaustauschverfahren der Naval Group, das häufig zur Kühlung von U-Booten genutzt wird. Das System leitet zunächst das Meerwasser durch die Kühler auf der Rückseite der 12 Server-Racks und anschliessend zurück ins Meer. Erkenntnisse aus der ersten Projektphase haben gezeigt, dass sich das Wasser aus dem Rechenzentrum schnell mit den umgebenden Strömungen vermischt und verteilt. Die kostenlose Kühlung durch das Meerwasser ist ein grosser Vorteil, da diese am Land hohe Kosten verursacht. Unterwasser-Datenzentren könnten zudem mit erneuerbaren Energien betrieben werden, zum Beispiel mit Strom aus Offshore-Windparks oder Gezeitenkraftwerken. Project Natick ist damit ein weiterer Schritt, den nachhaltigen Betrieb und die Klimaneutralität von Rechenzentren langfristig zu sichern.

Klimaneutralität und Energieeffizienz stehen im Fokus

Nachhaltigkeit ist nicht nur bei Project Natick ein elementarer Aspekt. Microsoft agiert bei allen globalen Aktivitäten zu 100 Prozent klimaneutral – und das in mehr als 100 Ländern. Der Energieverbrauch wurde flächendeckend reduziert und über saubere Energie abgedeckt. Für CO2-Emissionen, die nicht kompensiert oder ersetzt werden konnten, hat Microsoft in Kompensationsprojekte invesiert. Im Jahr 2017 hat sich Microsoft dazu verpflichtet, seine betrieblichen CO2-Emissionen bis 2030 um 75 Prozent zu reduzieren und liegt damit aktuell im Plan.

Beim Betrieb von Rechenzentren hält sich Microsoft schon heute an den europäischen Code of Conduct für Rechenzentren, einer Initiative des Joint Research Center sowie des Institute for Energy and Transport der Europäischen Kommission. Alle Unterzeichner verpflichten sich dazu die Energieeffizienz der Rechenzentren nachvollziehbar zu verbessern und regelmässig darüber zu berichten. Zudem investiert Microsoft in nachhaltige Projekte mit künstlicher Intelligenz (KI): Die Initiative AI for Earth zielt zum Beispiel darauf ab, die großen Herausforderungen der Menschheit mit Hilfe von künstlicher Intelligenz zu lösen.

Phase 1: Out-of-the-Box, die Projekt-Idee stammt von Mitarbeitern

Die Idee für „Project Natick“ entstand auf der ThinkWeek, die einst von Bill Gates initiiert wurde. Bei der ThinkWeek haben Microsoft-Mitarbeiter in einem offenen Forum die Möglichkeit, ihre Ideen zu teilen und dem Management vorzustellen.

Dann ging alles schnell: Zwölf Monate später, im Juli 2014, hat das Natick-Team einen im Labor erbauten Prototypen getestet. Der Test wurde in den ruhigen, flachen Gewässern an der Küste Kaliforniens durchgeführt.

„Wir haben in der ersten Testphase festgestellt, dass sich das Unterwasser-Rechenzentrum hervorragend mit dem empfindlichen Ökosystem des Ozeans verträgt,“ erklärt Projektleiter Ben Cutler. „Zum Beispiel haben wir herausgefunden, dass sich das Wasser in der direkten Umgebung des Rechenzentrums um nicht mehr als ein Tausendstel Grad Celsius erhitzt. Unsere Messungen haben ausserdem ergeben, dass man schon ein paar Meter entfernt vom Tank von Hintergrundgeräuschen aus dem Ozean, zum Beispiel vom Schnappen einer Garnele, übertönt wird. Das Rechenzentrum ist also sehr leise.“

Beispiele wie diese zeigen, dass die Unternehmenskultur ein wichtiger Grundpfeiler ist, damit innovative Ideen entstehen können. Erst vor kurzem hat Microsoft hierzu eine Kulturstudie veröffentlicht: Die Studie zeigt, dass nur jedes zweite deutsche Unternehmen seine Mitarbeiter darin ermutigt, mit neuen Technologien zu experimentieren. Wer sich jedoch erfolgreich digital transformieren möchte, sollte die Mitarbeiter aktiv miteinbinden und von deren Ideen profitieren. Das gelingt am besten mit einer Kultur des Vertrauens, so ein Ergebnis der Studie. Nur 11 Prozent der Befragten gaben an, dass sie daran beteiligt waren neue, digitale Geschäftsmodelle zu entwickeln.

Phase 2: Wie es weiter geht

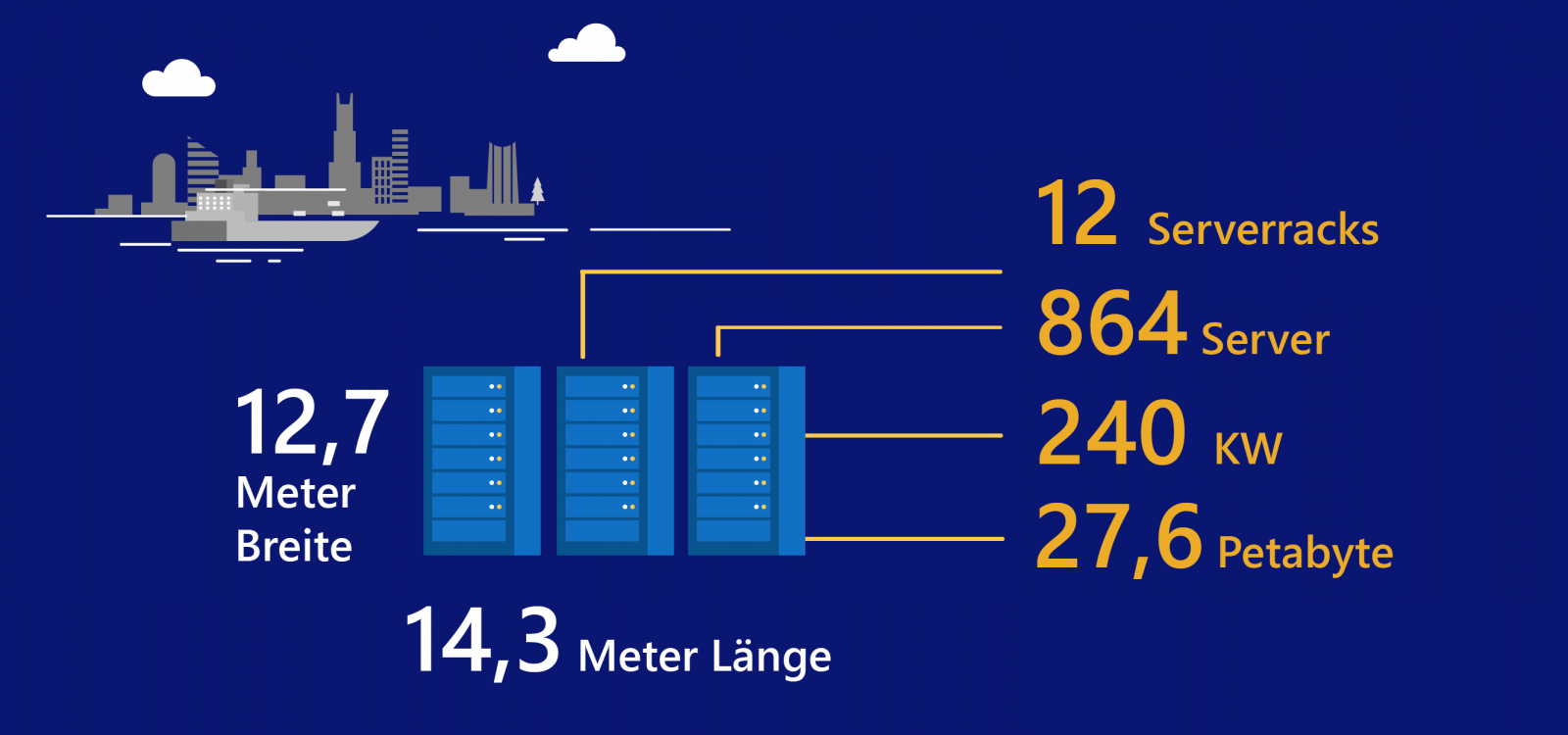

In der zweiten Phase des Projektes hat das Forscherteam ein rund 12 Meter langes Rechenzentrum vor der schottischen Küste, bestehend aus 12 Racks mit insgesamt 864 Servern und zugehöriger Kühlsysteminfrastruktur, abgesenkt. Der containergrosse Prototyp wurde in Frankreich montiert und auf der Ladefläche eines 18 Rad-LKWs auf die Orkney Islands transportiert. Damit sollte bereits die Logistik für ein mögliches Zukunftsszenario getestet werden: Kleine, containergrosse Rechenzentren werden vorproduziert, die bei Bedarf schnell via LkW oder Schiff dorthin gebracht werden können, wo sie benötigt werden. Das Test-Rechenzentrum ist über den Meeresboden mit Glasfaser- und Stromleitungen verbunden.

In den nächsten zwölf Monaten wird das Projektteam die Leistung des Datenzentrums überwachen. Protokolliert werden sämtliche Dinge: Vom Stromverbrauch über die innere Luftfeuchtigkeit bis hin zu Schall- und Temperatur rund um das Rechenzentrum.

Weiterführende Links

- Project Natick Webseite

- Microsoft Corp. Feature “Project Natick”

- Microsoft Corp. YouTube-Video “Microsoft tests Project Natick, self-sustaining underwater datacenter”

- Microsoft Corp. Blog “Green IT”