Microsoft hat neue interne Standards für den eigenen verantwortungsvollen Umgang mit Künstlicher Intelligenz (KI) veröffentlicht. Es ist ein wichtiger Schritt, um verantwortungsvolle KI zu verbessern und zu präzisieren. Zudem ist es auch ein Beitrag zur Diskussion, damit die Entwicklung besserer Normen und Standards nicht auf uns beschränkt bleibt, sondern zum Gegenstand einer breiten gesellschaftlichen Debatte wird.

KI wird immer mehr zu einem normalen Teil unseres Lebens, aber die Gesetze und ethischen Standards für ihren Einsatz spiegeln das unserer Ansicht nach noch nicht angemessen wider. Wir sehen zwar Anzeichen dafür, dass sich das ändert, können darauf aber nicht warten, da die technologische Entwicklung schnell voranschreitet. Wir sind uns unserer eigenen Verantwortung bewusst, zu handeln, damit KI-Systeme von vornherein und über ihren gesamten Lebenszyklus verantwortungsvoll gestaltet sind.

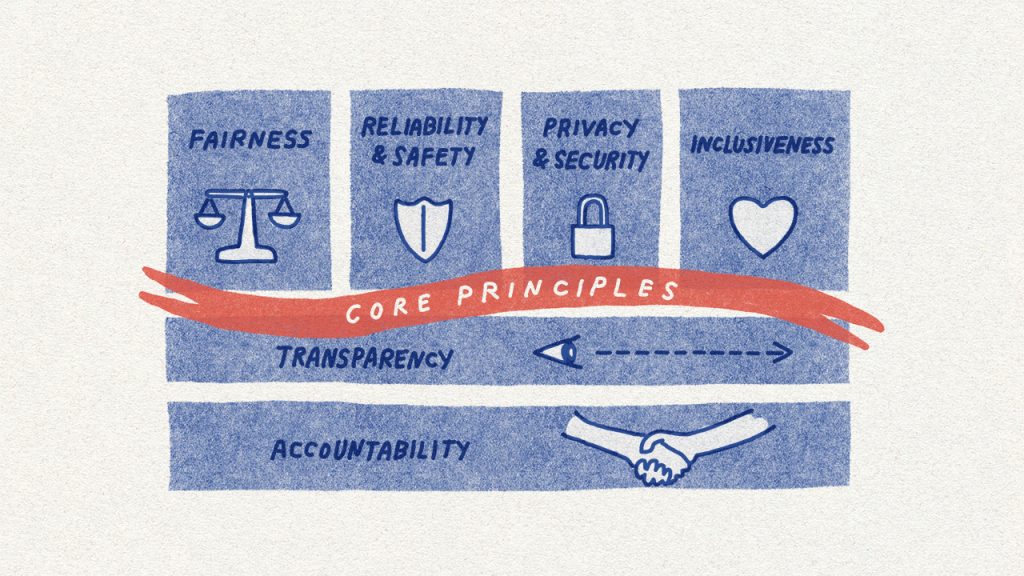

Wir sehen es daher als unsere Aufgabe an, KI-Systeme so zu entwickeln, dass sie der Gesellschaft nützen. Wir tun das, indem wir die Menschen in den Mittelpunkt unserer Entwicklungen von Anwendungen mit künstlicher Intelligenz stellen. Dabei lassen wir uns von zentralen menschlichen Werten leiten: Fairness, Zuverlässigkeit, Recht auf Privatsphäre und Sicherheit, umfassender Teilhabe sowie von Transparenz und Verantwortung.

Für die verantwortungsvolle Entwicklung und Nutzung von KI haben wir Standards entwickelt, die unseren eigenen Teams als praktisch umsetzbare Leitlinien dienen. Damit gehen wir über die allgemeinen Grundsätze und Verlautbarungen hinaus, die bisher die Diskussionen um „Responsible AI“ bestimmt haben, aber wenig praktischen Nutzen in der täglichen Umsetzung zeigen.

Mit den Standards helfen wir zum Beispiel dabei, das weit gefasste Prinzip der von uns geforderten „Rechenschaftspflicht“ von Menschen für Algorithmen aufzuschlüsseln – mit Themen wie Folgeabschätzungen, Datenverwaltung und menschlicher Kontrolle. Jedes dieser Ziele wiederum präzisieren wir mit einer Reihe von Anforderungen für die praktische Umsetzung. So können Entwicklungsteams sicherstellen, dass KI-Systeme die Ziele über ihren gesamten Lebenszyklus auch erfüllen. Schliesslich ordnen wir den Prinzipien und Anforderungen Tools und Best Practices zu, sodass Entwicklungsteams verfügbare Ressourcen nutzen können, um diese Prinzipien umzusetzen.

Details zu den Verbesserungen unserer ethischen Standards

In den vergangenen Monaten hat eine interdisziplinäre Gruppe von Forschenden, Ingenieur*innen und Politikexpert*innen eine neue, inzwischen schon zweite Version unserer Standards für verantwortungsvolle KI erarbeitet. Sie baut auf der ersten Fassung von 2019 auf, aber auch auf neuen Forschungsergebnissen und auf wichtigen Erkenntnissen aus unserer eigenen Arbeit.

1) Änderungen bei der Spracherkennung

KI-Systeme sind nicht per se gut oder böse. Sie können aber gesellschaftliche Vorurteile und Ungleichheiten spiegeln oder sogar verstärken, wenn sie mit falschen, unvollständigen oder einseitigen Daten trainiert werden und das bei Tests und Kontrollen – so diese denn tatsächlich vorgenommen werden – nicht auffällt. Genau genommen ist dieses Phänomen die Ursache der am weitesten verbreiteten Probleme von KI.

Wir bieten in Azure einen Service an, der in mehr als 100 Sprachen und Varianten Audioaufnahmen und -streams in Text umwandelt. Im März 2020 hat eine wissenschaftliche Studie ergeben, dass der Einsatz von Sprache-zu-Text-Technologie im gesamten Technologiesektor für Angehörige mancher Schwarzer und afroamerikanischer Gemeinschaften Fehlerquoten aufwies, die fast doppelt so hoch waren wie für weisse Nutzer*innen. Wir haben dieses Phänomen für unsere Dienste analysiert und dabei festgestellt, dass wir bei den Tests der Technologie die Vielfalt der Sprache von Menschen mit unterschiedlichem Hintergrund und aus verschiedenen Regionen nicht ausreichend berücksichtigt haben.

Daher haben wir Soziolinguist*innen gebeten, uns bei einem besseren Verständnis dieser Vielfalt zu helfen. Zudem haben wir unsere Datenbasis vergrössert, um Lücken im Training unserer Sprache-zu-Text-Technologie zu schliessen.

Dabei haben wir uns auch mit der Frage auseinandersetzen müssen, wie wir Daten spezieller Communities oder Gruppen erheben können, damit sie angemessen und respektvoll genutzt werden können. Und wir haben gelernt, wie wichtig es ist, Expert*innen frühzeitig in diesen Prozess einzubeziehen – auch, um die Faktoren zu verstehen, die für Schwankungen in der Leistung der KI-Systeme verantwortlich sein könnten.

Das alles hat zu einem neuen Standard für verantwortungsbewusste KI geführt, der unsere Sprache-zu-Text-Technologie verbessert. Wir führen diesen Standard in unserem Unternehmen ein und gehen davon aus, dass die darin enthaltenen Fairness-Ziele und -Anforderungen uns dabei helfen werden, potenziellen Problemen auch bei ganz anderen KI-Lösungen vorzubeugen.

2) Einschränkungen bei benutzerdefinierten Stimmen und Gesichtserkennung

Microsoft Azure kann mit der Funktion Custom Neural Voice aus einer natürlichen Stimme eine synthetische erzeugen, die dem Original täuschend ähnelt. Diese Funktion lässt sich gewinnbringend im Bildungswesen, in der Unterhaltung und bei der Inklusion einsetzen. Aber sie beinhaltet auch das Potenzial, missbräuchlich eingesetzt zu werden, etwa um Stimmen zu imitieren und Menschen zu täuschen.

Wir haben auch diese Technologie auf den Prüfstand gestellt und in der Konsequenz ein mehrschichtiges Kontrollsystem eingeführt: Wir haben den Zugang zu diesem Service eingeschränkt, zulässige Einsatzszenarien definiert und diese transparent an unsere Kunden kommuniziert. Und wir haben technische Leitplanken eingezogen. Damit gewährleisten wir, dass die echten Sprecher*innen an der Erstellung ihrer synthetischen Stimme aktiv beteiligt sein müssen. So stellen wir sicher, dass die Technologie weiterhin genutzt, aber nicht mehr unangemessen eingesetzt werden kann.

Ähnliche Kontrollen werden wir auf unseren Service für Gesichtserkennung in Azure anwenden. Auch hier werden wir nach einer Übergangszeit den Zugang zu unserem Service auf Geschäftskunden und Partner sowie die Zahl der Einsatzszenarien beschränken und dies jeweils individuell vertraglich vereinbaren. Zudem werden wir technische Daten aus dem Betrieb des Dienstes nutzen, um die Wirksamkeit dieser Massnahmen kontrollieren zu können.

Unser Service für Gesichtserkennung hat ein weiteres Problem offenbart: seine Fähigkeit, Emotionen zu erkennen und aus den bildlichen Darstellungen von Menschen Identitätsmerkmale wie Geschlecht oder Alter abzuleiten. Expert*innen innerhalb und ausserhalb unseres Unternehmens haben darauf hingewiesen, dass es keinen wissenschaftlichen Konsens über die Definition von Emotionen gibt. Deshalb ist es schwierig, valide Schlussfolgerungen aus den genannten Identitätsmerkmalen etwa über verschiedene Bevölkerungsgruppen hinweg zu ziehen. Zudem gibt es bei den Fachleuten grosse Bedenken hinsichtlich des Datenschutzes und der Wahrung von Persönlichkeitsrechten bei dieser Funktion.

Daher haben wir uns entschlossen, keinen offenen Zugang mehr zu Technologien zu gewähren, die Gesichter scannen und versprechen, aus Gesichtsausdrücken oder Bewegungen auf den emotionalen Zustand oder die Identität von Menschen zu schliessen. Ausserdem werden wir alle KI-Systeme sorgfältig analysieren, die diese Fähigkeit besitzen – unabhängig davon, ob die Systeme unsere Gesichtserkennung oder andere KI-Technologien verwenden. Wir erhoffen uns davon, dass wir so differenzierte und wissenschaftlich fundierte Leitlinien erhalten, um diese Technologie künftig für spezielle Anwendungsfälle kontrolliert und verantwortungsvoll bereitstellen zu können.

Der Weg zu verantwortungsvoller KI ist eine multidisziplinäre und iterative Reise

In unseren aktualisierten internen Standards für verantwortungsvolle KI sind viele hundert Beiträge aus unterschiedlichen Teams, Berufsgruppen, Forschungsbereichen, Technologien und Regionen von Microsoft eingeflossen. Für uns sind die Aktualisierungen ein bedeutender Schritt nach vorne, weil wir damit praktische Ansätze für die frühzeitige Identifizierung, Messung und Eindämmung von Schäden liefern. Zudem verlangen die neuen Standards von den Entwicklungs- und Trainingsteams, dass sie Kontrollen einführen, um einen unangemessenen Einsatz von KI zu verhindern.

Unser Unternehmensstandard ist ein wichtiger Schritt auf unserem Weg zu verantwortungsvoller KI, aber es ist nur ein Schritt. Wir werden auf Herausforderungen stoßen, für die wir neue Antworten brauchen. Unsere Standards werden mit diesen Herausforderungen wachsen, neue Erkenntnisse aus der Forschung sowie neue Technologien und Regulierungen aufnehmen und sich darüber insgesamt weiterentwickeln.

Ein wichtiger Teil dieser Entwicklung ist der Dialog. Wir profitieren einerseits von den vielen Gesprächen mit unseren Partnern und Kunden, mit gesellschaftlichen Gruppen, politisch Verantwortlichen und den vielen Entscheider*innen aus Unternehmen und Institutionen. Wir werden uns andererseits in dieser Debatte auch selbst zu Wort melden, denn wir glauben fest daran, dass nur die Zusammenarbeit von Industrie, Wissenschaft, Zivilgesellschaft und Regierungen die Technik vorantreiben und so gestalten wird, dass sie uns allen nützt und nicht schadet. Gemeinsam werden wir offene Fragen beantworten, Wissenslücken schließen und neue Praktiken, Modelle, Ressourcen und Instrumente dafür entwickeln.

All das brauchen wir für eine bessere und gerechtere Zukunft. Unsere neuen KI-Standards setzen Leitplanken auf dem Weg dorthin. Wir laden Sie ein, uns auf diesem Weg kritisch und offen zu begleiten.