Przyszłość bezpieczeństwa napędzanego AI

Odpowiednio wykorzystana sztuczna inteligencja może być nieocenionym wsparciem zarówno w codziennym życiu jak i biznesie. Może być również wykorzystana na polu walki z cyberprzestępczością, jeżeli będzie uwzględniona w mechanizmach obronnych. Inteligentne algorytmy dostarczają zespołom ds. bezpieczeństwa nowe możliwości szybszej i dokładniejszej identyfikacji zagrożeń i reagowania na incydenty, a także pomagają powstrzymać ataki zanim się rozprzestrzenią.

Ostatnie lata pokazały, w jak szybkim tempie zwiększa się potencjał, produktywność i kreatywność ludzi na całym świecie. Korzyści z AI czerpią także cyberprzestępcy do przeprowadzania zorganizowanych ataków, często zlecanych przez organizacje lub państwa. W efekcie skala zagrożenia rośnie wykładniczo – tylko w ciągu ostatnich 12 miesięcy liczba wykrytych przez Microsoft prób wyłudzeń haseł dostępowych zwiększyła się z 1287 do ponad 4000 na sekundę. Rośnie również cena, jaką płacimy za straty spowodowane cyberatakami. Według najnowszych wyliczeń FBI Internet Crime Complaint Center (IC3), całkowite straty dla gospodarki USA wzrosły z 6,9 mld USD w 2021 roku do ponad 10,2 mld USD w 2022 roku. Liczby te są jeszcze większe w skali globalnej.

Wszystko to sprawia, że zapewnienie bezpieczeństwa cyfrowego jest jednym z największych wyzwań naszych czasów. Stale zmieniające się narzędzia i taktyki cyberprzestępców, a także rozproszenie danych pozyskiwanych przez rozwiązania bezpieczeństwa sprawiają, że coraz trudniej jest uzyskać pełny wgląd w krajobraz zagrożeń. Jeśli przedsiębiorstwa będą nadal funkcjonować w ramach fragmentarycznego systemu bezpieczeństwa i nie wykorzystają do walki z zagrożeniami inteligentnych narzędzi, pozostaną daleko za przeciwnikiem.

Bez półśrodków

Sztuczna inteligencja już dzisiaj odgrywa istotną rolę w naszym codziennym życiu, znajdując zastosowanie w wielu obszarach. W handlu online personalizuje rekomendacje i wspiera proces zakupowy. W finansach wspiera inwestycje i identyfikuje zagrożenia. Nie obcy są nam również wirtualni asystenci, którzy wspomagają obsługę klienta. Szacuje się, że do 2025 roku boty mają odpowiadać za 95 proc. interakcji z użytkownikami Internetu. Nie ulega wątpliwości, że sztuczna inteligencja będzie coraz istotniejszym elementem naszego życia. Wg Statista, przychody z rynku oprogramowania sztucznej inteligencji na całym świecie mają osiągnąć 126 miliardów dolarów do 2025 roku. Zgodnie z danymi Gartnera, 37 proc. organizacji już wdrożyło AI w swych strukturach. Odsetek przedsiębiorstw korzystających z tej technologii wzrósł o 270 proc. w ciągu ostatnich czterech lat.

Podobny trend jest widoczny w obszarze bezpieczeństwa cyfrowego. Liczni eksperci wskazują, że wykorzystanie inteligentnych algorytmów będzie miało kluczowe znaczenie w walce z cyberprzestępczością. Skoro nasi adwersarze coraz częściej wykorzystują sztuczną inteligencję do prowadzenia skomplikowanych ataków i kampanii, dlaczego nie miałyby robić tego mechanizmy obronne?

„Działamy w erze, w której walka ze sztuczną inteligencją za pomocą sztucznej inteligencji nie podlega negocjacjom. Poprzez współpracę z Microsoft Security Copilot możemy wyrównać szanse obrony” – zapewnia Matthew Prince, współzałożyciel, prezes wykonawczy i dyrektor generalny w firmie Cloudflare.

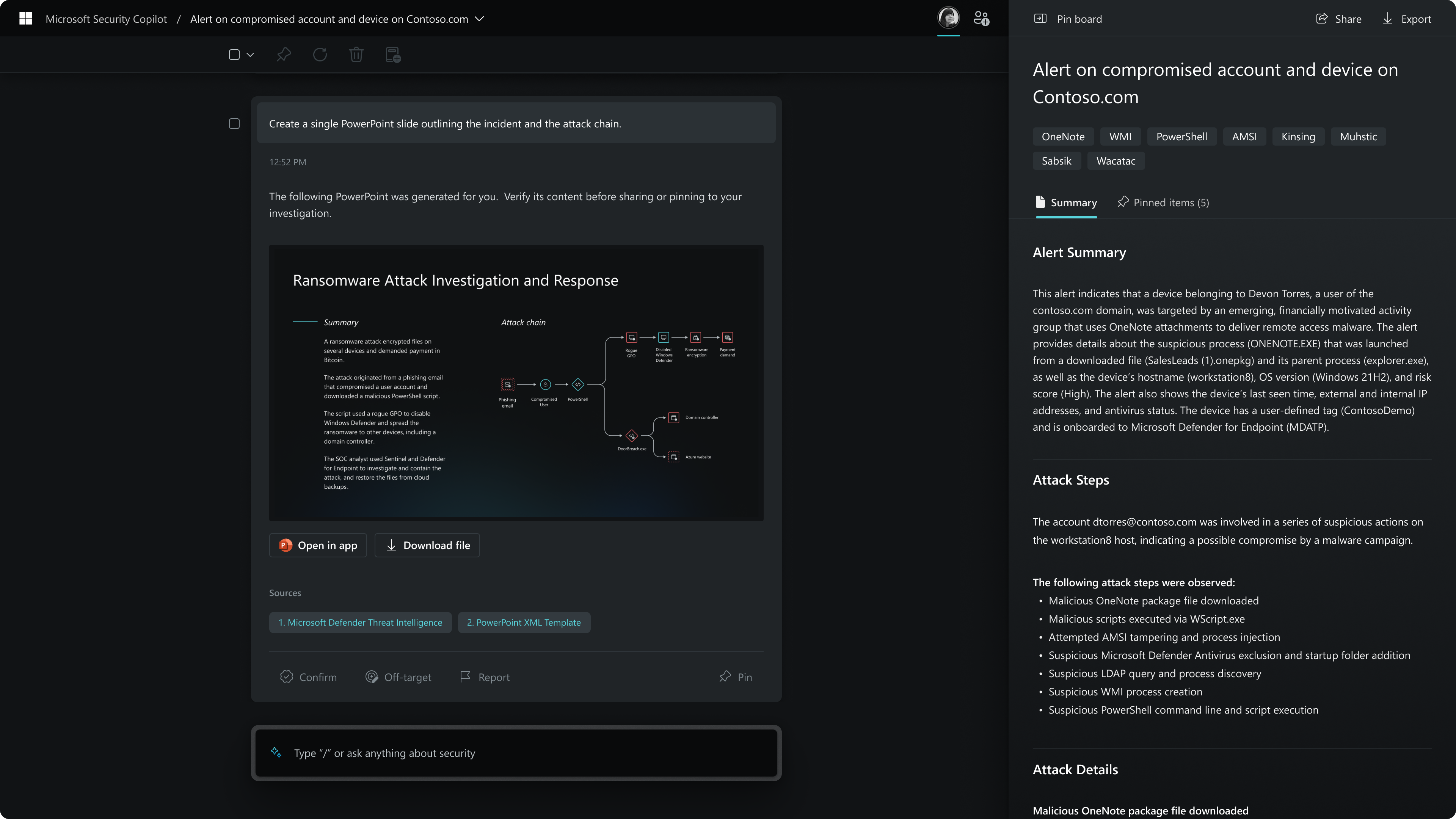

Security Copilot – bezpieczeństwo wpisane w ekosystem

Mając na uwadze powyższe zagrożenia, Microsoft w marcu tego roku ogłosił wprowadzenie na rynek usługi wykorzystującej nową generację sztucznej inteligencji do walki z cyberprzestępczością – Microsoft Security Copilot. To usługa napędzana sztuczną inteligencją, która pozwoli zespołom odpowiedzialnym za bezpieczeństwo lepiej zrozumieć krajobraz cyberzagrożeń, dając im narzędzia do szybszego ich wykrywania i reagowania na potencjalne incydenty.

„Niestety specjaliści ds. bezpieczeństwa wciąż muszą toczyć nierówną walkę z nieustępliwymi i wyrafinowanymi cyberprzestępcami” – powiedziała Vasu Jakkal, wiceprezes Microsoft ds. bezpieczeństwa. „Security Copilot zmienia równowagę sił na naszą korzyść. To pierwsze i jedyne tego typu rozwiązanie oparte na generatywnej sztucznej inteligencji, które pozwala osobom odpowiedzialnym za bezpieczeństwo poruszać się z prędkością i skalą AI”.

W świecie, w którym hasła są atakowane 1 287 razy na sekundę, fragmentaryczne narzędzia i infrastruktura nie wystarczają do powstrzymania atakujących. Liczba ataków w ciągu ostatnich 5 lat wzrosła o 67 proc, a firmy i organizacje nie są w stanie zatrudnić odpowiedniej liczby specjalistów ds. cyberbezpieczeństwa. Doprowadziło to do sytuacji, w której osoby odpowiedzialne za bezpieczeństwo są przytłoczone wyszukiwaniem trudno zauważalnych ataków w ciągle zwiększającym się ruchu sieciowym i pośród sygnałów z różnych źródeł.

Sztuczna inteligencja zaszyta w Security Copilot zmniejsza złożoność tych procesów i zwiększa możliwości zespołów bezpieczeństwa w zakresie identyfikowania złośliwych aktywności.

„Wierzymy, że generatywna AI będzie prawdziwie rewolucyjna i pozwoli naszej firmie stać się bardziej skuteczną i wydajną w ochronie naszych klientów. Przewidujemy wzrost produktywności naszych analityków SOC korzystających z Security Copilot w takich sytuacjach, jak reagowanie na incydenty i wyszukiwanie zagrożeń, a także wierzymy, że istnieje potencjał do podnoszenia kwalifikacji, umożliwiając każdemu analitykowi wykonywanie bardziej zaawansowanych zadań szybciej niż kiedykolwiek wcześniej” – powiedział Brian Beyer, dyrektor zarządzający w Red Canary.

Microsoft dysponuje odpowiednimi zasobami, które pomogą firmom badać i wdrażać technologię AI w celu zwiększenia ich możliwości z zakresu cyberobrony. Microsoft Security aktywnie śledzi więcej niż 50 grup wykorzystujących ataki ransomware, ponad 250 unikalnych organizacji cyberprzestępczych działających na zlecenie państw i codziennie odbiera 65 bilionów sygnałów o zagrożeniach. Technologia Microsoft blokuje ponad 25 miliardów prób kradzieży haseł na sekundę, a ponad 8 000 specjalistów ds. bezpieczeństwa w firmie analizuje więcej sygnałów bezpieczeństwa niż jakakolwiek inna firma. Do tego celu analitycy Security Operations Center Microsoft wykorzystują ponad 100 różnych źródeł danych.

„Dobry manager bezpieczeństwa powinien do znudzenia wpajać swojemu otoczeniu, że bezpieczeństwo to proces, a nie stan docelowy. Ten proces to de facto niekończąca się walka pomiędzy „bezpiecznikami” i cyberprzestępcami, którzy wskutek demokratyzacji technologii mają równy dostęp do cyfrowego uzbrojenia.

„Dobry manager bezpieczeństwa powinien do znudzenia wpajać swojemu otoczeniu, że bezpieczeństwo to proces, a nie stan docelowy. Ten proces to de facto niekończąca się walka pomiędzy „bezpiecznikami” i cyberprzestępcami, którzy wskutek demokratyzacji technologii mają równy dostęp do cyfrowego uzbrojenia.

Niestety, cyberprzestępcy do tej pory mieli nad „bezpiecznikami” przewagę w kilku aspektach. Jest ich dużo więcej niż nas, mają większy budżet, są wolni od procedur i procesu decyzyjnego, nie obowiązują ich zamówienia publiczne ani rygory RODO, nie wspominając już o kwestiach moralnych. Często ich działania sponsorują niedemokratyczne państwa.

Szanse w tej walce wyrównuje potencjał sztucznej inteligencji zasilanej ogromną mocą chmury obliczeniowej. Security Copilot pozwala na zautomatyzowanie wielu procesów realizowanych przez zespoły SOC, a przede wszystkim znacząco przyspiesza analizę ogromnej ilości danych, na podstawie których można wykryć anomalie lub nowe wektory ataku w sieciach i systemach teleinformatycznych.

Rozwiązania takie jak Microsoft Security Copilot znoszą ograniczenia wynikające z mechanizmów ludzkiej percepcji, a ich powszechna dostępność z pewnością przełoży się na zwiększenie poziomu cyberbezpieczeństwa współczesnego świata. Jestem przekonany, że ten trend będzie widoczny w nadchodzącym tegorocznym raporcie Microsoft Digital Defence Report” – komentuje Krzysztof Malesa, dyrektor ds. strategii bezpieczeństwa w polskim oddziale Microsoft.

Etyka i odpowiedzialność w erze sztucznej inteligencji

Tworzenie, rozwijanie i wdrażanie rozwiązań wykorzystujących sztuczną inteligencję wymaga jednak wysokich standardów bezpieczeństwa i odpowiedzialności. Microsoft aktywnie angażuje się w tworzenie rozwiązań „bezpiecznych z założenia”, a także wspiera międzynarodowe wysiłki na rzecz opracowania dobrowolnego kodeksu postępowania w zakresie sztucznej inteligencji, który połączy partnerów prywatnych i publicznych. Celem jest stworzenie międzynarodowych standardów dotyczących przejrzystości sztucznej inteligencji i zarządzania ryzykiem oraz wytycznych dla twórców technologii.