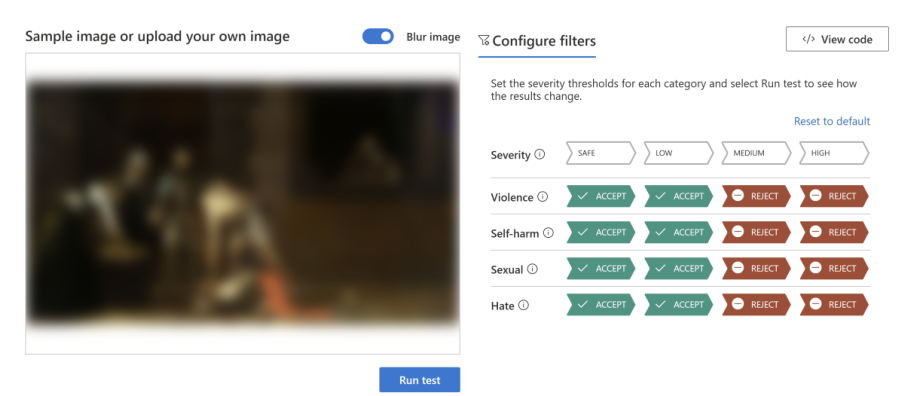

Idag lanserar Microsoft tjänsten Azure AI Content Safety på Azure AI-plattformen. Tjänsten använder avancerade modeller för språk och bild för att identifiera innehåll som är hatiskt, våldsbejakande, sexuellt eller antyder självskadebeteende. När Azure AI Content Safety upptäcker potentiellt skadligt innehåll flaggar den innehållet och bedömer den uppskattade allvarlighetsgraden. Det gör att företag och organisationer kan skräddarsy tjänsten att blockera eller flagga innehåll baserat på deras policyer.

Azure AI Content Safety, som ursprungligen introducerades som en del av Azure OpenAI Service, är från och med idag en fristående tjänst. Det innebär att kunder kan använda tjänsten på AI-genererat innehåll även från modeller med öppen källkod, och från andra företags modeller samt för användargenererat innehåll som en del av kundens hela innehållssystem, vilket utökar tjänstens användbarhet avsevärt.

”Det finns ett otroligt intresse för artificiell intelligens i svenska verksamheter, och i takt med att AI-lösningarna blir fler är det viktigt för oss att parallellt utrusta verksamheterna med verktygen för att ta dem i drift på ett tryggt och säkert sätt. Azure AI Content Safety är det senaste exemplet på en lösning som hjälper våra kunder att utveckla AI-tjänster som är trygga och säkra”, säger Daniel Akenine, nationell teknikchef på Microsoft Sverige.

Internt har Microsoft förlitar sig på Azure AI Content Safety för att skydda användare i sina egna AI-drivna produkter. Tekniken används redan i de senaste chattbaserade innovationerna i produkter som Bing, GitHub Copilot, Microsoft 365 Copilot och Azure Machine Learning.