Ab heute ist die neu integrierte Hybrid-Funktion in Azure Quantum verfügbar. Das gab die Microsoft Corporation in einem Blogpost von Krysta Svore, Distinguished Engineer and Vice President of Advanced Quantum Development, Quantum bei Microsoft, bekannt.

Die neue Funktion ermöglicht die nahtlose Integration von Quanten- und klassischen Berechnungen in der Cloud – ein Novum in der Branche und ein wichtiger Schritt auf dem Weg zu skalierbarem Quantencomputing. Mit der Integration von klassischem und Quanten-Code können Wissenschaftler*innen nun hybride Quantenanwendungen entwickeln, die auf einem der bereits heute verfügbaren Quantencomputer in Azure Quantum laufen, dem Quantinuum.

Fehlertolerantes Quantencomputing ist nur über die Cloud möglich

Damit Forscher*innen zur Lösung komplexer Probleme beitragen können, etwa zur Bewältigung des Klimawandels oder der weltweiten Ernährungsprobleme, sind Quanten in großem Maßstab erforderlich. Nach heutigem Kenntnisstand brauchen Maschinen, die das können, mindestens eine Million stabiler und kontrollierbarer Qubits. Zum Vergleich: Heute verfügbare Quantenrechner bieten gerade einmal 100 bis 200 Qubits. Microsoft macht große Fortschritte bei der Entwicklung von Maschinen mit einer exponentiellen Zahl von Qubits. Bis diese Rechner verfügbar sein werden, setzt das Unternehmen aber auf die Integration von Quantenmaschinen und klassischen Supercomputern in der Cloud.

Die Leistungsfähigkeit der Cloud ist für den Betrieb einer fehlertoleranten und dennoch stabilen Quantenmaschine notwendig, weil es dafür eine enorme Rechenleistung braucht. Daher integriert Microsoft den Quantencomputer mit klassischen Rechnern im Peta-Maßstab in Azure. Damit sind Rechensysteme gemeint, die mindestens 1015 Gleitkommaoperationen pro Sekunde (1 petaFLOPS) berechnen und zudem in der Kommunikation zwischen Quanten- und klassischen Systemen über eine Bandbreite von bis zu 100 Terabit pro Sekunde kommunizieren können. Wie wichtig diese Fehlertoleranz ist, zeigt eine weitere Zahl: Eine Maschine muss in der Lage sein, eine Quintillion (1030) Operationen durchzuführen und darf dabei höchstens einen Fehler machen. Oder noch mal anschaulicher: Wenn jede Operation einem Sandkorn auf der Erde entspräche, dürfte höchstens eins dieser Sandkörner fehlerhaft sein.

Cloud-Rechenkapazität hilft bei Lösung quantenmechanischer Probleme

Die Hochverfügbarkeit und die Möglichkeiten zur Skalierung von Rechenleistungen in den Peta-Bereich über die Cloud schafft nicht nur neue Möglichkeiten für das Lösen quantenmechanischer Probleme. Es ist auch wichtig, dass diese Rechenleistungen effizient und kostengünstig verfügbar sind. So haben vor kurzem Wissenschaftler*innen der ETH Zürich und des Pacific Northwest National Laboratory zusammen mit Forschenden von Microsoft einen automatisierten Arbeitsablauf vorgestellt, mit dem Prozesse für Forschung und Entwicklung in Quantenchemie und Materialwissenschaften verbessert werden können. Durch das Optimieren des klassischen Simulationscodes und seine Umwandlung in Cloud-nativen Code konnte das interdisziplinäre Team die Kosten für Simulationen von katalytischen chemischen Reaktionen um den Faktor 10 senken.

Solche Möglichkeiten werden sich noch häufiger ergeben, weil die Rechenleistung in der Cloud kontinuierlich wächst. High-Performance-Computing in Azure bietet in der Kombination mit künstlicher Intelligenz ein riesiges Potenzial für Fortschritte in der Chemie und Materialwissenschaft – kurzfristig durch Skalierung und Hochgeschwindigkeit im klassischen Computing sowie langfristig über eine skalierbare Quantenmaschine in Azure.

Diese Maschine wird eine exponentiell höhere Genauigkeit bei der Modellierung neuer Pharmazeutika, Chemikalien und Materialien ermöglichen. Die Möglichkeiten, damit Fortschritt und Wachstum freizusetzen, sind enorm, wenn man bedenkt, dass Chemie und Materialwissenschaft ganze 96 Prozent aller hergestellten Waren beeinflussen.

Fortschritte durch Hyperscale-Cloud mit KI, HPC und Quantencomputing

Solche Fortschritte lassen sich aber nur erzielen, wenn so eine Quantenmaschine mit den KI-Supercomputern und der Skalierbarkeit von Azure integriert ist. Wissenschaftler*innen und Menschen aus der Praxis werden damit in der Lage sein, eine neue Klasse von Cloud-Anwendungen zu entwerfen, die KI, High Performance Computing (HPC) und Quantencomputer in großem Maßstab zusammenbringen.

Stellen Sie sich zum Beispiel vor, welche Möglichkeiten sich ergeben, wenn Forschende mithilfe von KI riesige Datensätze sortieren, die Erkenntnisse mit HPC analysieren und anschließend über Quantencomputer in großem Maßstab die Genauigkeit von modellhaften Rechnungen verbessern. Solche Szenarien werden durch die nahtlose Integration von HPC, KI und Quantencomputing in einer einzigen Anwendung auf Azure möglich sein.

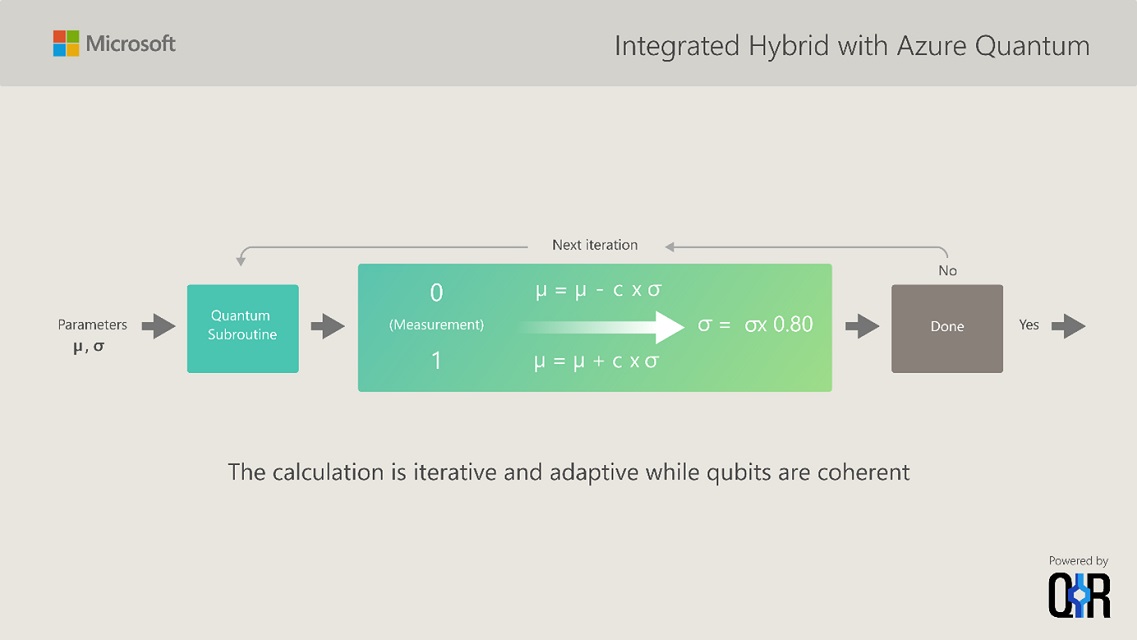

Mit seiner Ankündigung der Integration von klassischen und Quantenmaschinen geht Microsoft einen bedeutenden Schritt auf dem Weg zu diesen Möglichkeiten. Ab sofort werden Forschende und Anwender*innen in der Lage sein, hybride Quantenanwendungen aus einer Mischung von klassischem und Quantencode zu entwickeln. Das wird zum Beispiel Algorithmen mit der Fähigkeit zur Adaptive Quantum Phase Estimation hervorbringen, welche die Vorteile klassischer Berechnungen nutzen, sich dabei aber schrittweise (iterativ) entwickeln und anpassen, während die physikalischen Qubits kohärent und damit in der Lage sind, mehrere mögliche Ergebnisse gleichzeitig und fehlertolerant zu berücksichtigen. Darüber hinaus sind auf Quantencomputern Berechnungen möglich, für die klassische Computer gar nicht in Frage kommen. So wird ein wichtiger Meilenstein auf dem Weg zum skalierbaren Quantencomputing erreicht.

Mehr Informationen zu den Entwicklungen im Quantencomputing finden Sie auf dem Azure Quantum Blog von Microsoft.

Ein Beitrag von Markus Göbel

Senior Communications Manager Data Applications and Infrastructure