Разработчики: ответственный подход к машинному обучению Microsoft формирует доверие к ИИ-системам

Каждый владелец бизнеса знает, как сложно обвинить клиента в нарушении условий использования продукта. Вот почему сотрудники отдела по борьбе с мошенничеством «Скандинавских авиалиний», прежде чем обвинить клиента в попытке злоупотребления программой лояльности компании, хотели быть абсолютно уверенными в том, что не ошиблись.

«Если случайно обвинить в мошенничестве невиновных, это навредит компании еще больше», — говорит Даниель Энгберг, глава подразделения информационной аналитики и искусственного интеллекта SAS, авиакомпании с головным офисом в Стокгольме, Швеция.

«Авиакомпания в данный момент работает по сокращенному графику и ограничила объем сервисных услуг, предоставляемых на борту, с целью замедлить распространение COVID-19, болезни, вызванной коронавирусом нового типа. До введения ограничений SAS отправляла более 800 рейсов ежедневно и перевозила 30 миллионов пассажиров в год. Поддержание корректной работы программы лояльности EuroBonus — первоочередная задача в период, когда авиакомпания ждет возможности восстановить работу в обычном объеме», – отметил Энгберг.

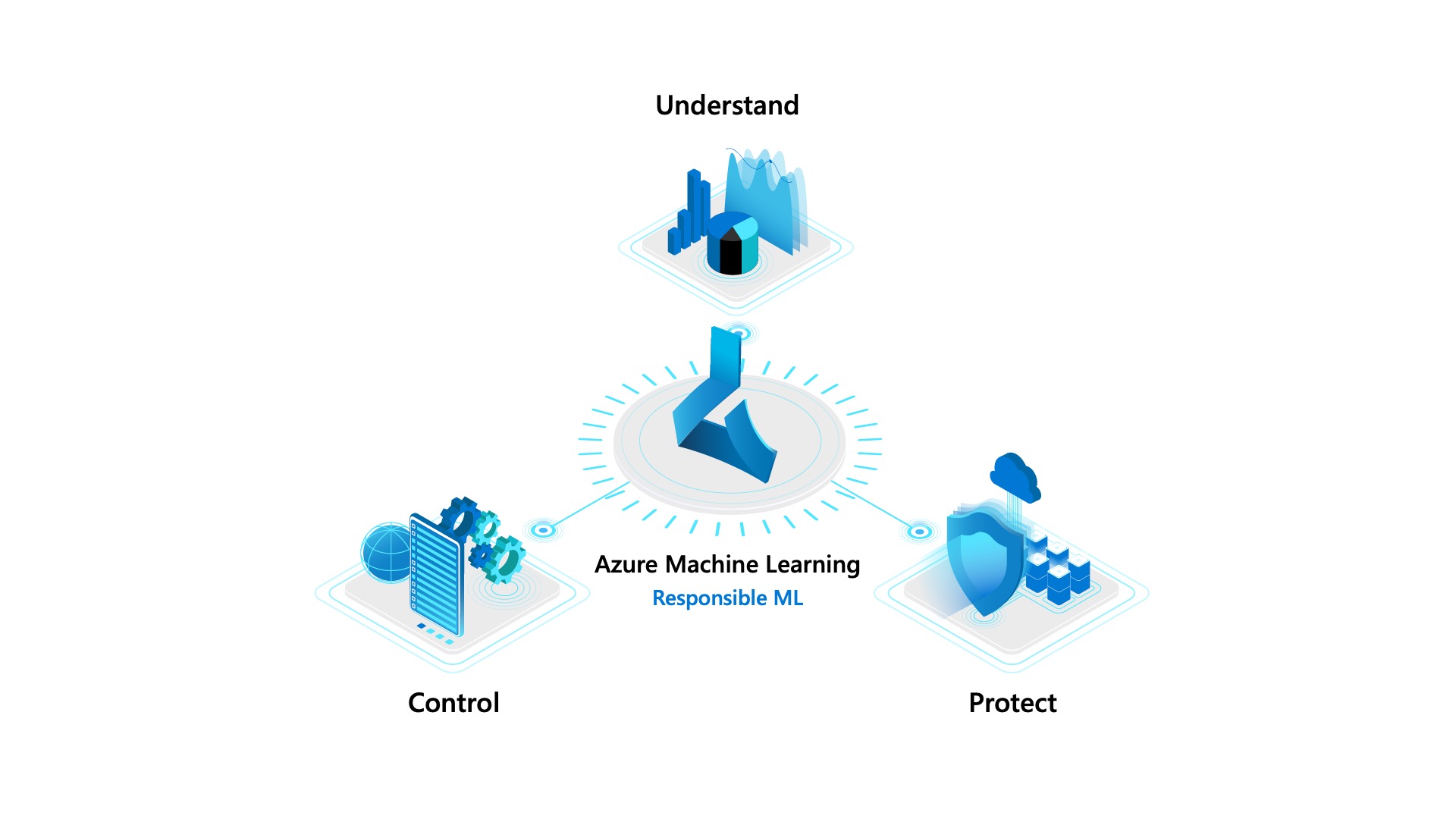

Мошенники пытаются как можно быстрее получить максимум баллов в системе EuroBonus, чтобы забронировать бонусный перелет для себя или на продажу. В таком случае добропорядочные клиенты лишаются возможности получить места, зарезервированные для участников программы лояльности, и SAS теряет важную часть дохода. Сегодня значительный объем данных о мошеннических операциях с EuroBonus поступает из ИИ-системы, разработанной Энгбергом и его командой с помощью Microsoft Azure Machine Learning. Это сервис для создания, обучения и развертывания моделей машинного обучения, позволяющий лучше понимать поведение алгоритмов, контролировать их, а также обеспечивать их защиту.

ИИ-система SAS обрабатывает сведения о полетах, транзакциях, использовании баллов программы лояльности и другие данные, поступающие в режиме реального времени через модели машинного обучения с тысячами параметров для идентификации подозрительных типов поведения.

«Чтобы понять, как моделью осуществляется прогнозирование, и благодаря этому отслеживать случаи злоупотреблений, отдел по борьбе с мошенничеством использует такую функцию Azure Machine Learning, как интерпретируемость, осуществляемую благодаря набору инструментов InterpretML. Эта функция показывает, какие параметры были наиболее значимыми в каждом конкретном случае. Например, она может указать на параметры, предполагающие мошенничество путем объединения баллов «призрачных» аккаунтов для бронирования перелетов. Интерпретируемость модели позволяет сделать работу сервисов на основе машинного обучения более прозрачной, благодаря чему формируется уверенность и доверие к прогнозам, которые дают эти сервисы», – отмечает Энгберг.

«Когда мы используем модели, прозрачность которых обеспечивается еще на этапе их создания, люди испытывают доверие и начинают использовать их, благодаря чему мы можем оценить преимущества машинного обучения, — говорит он. — Это не объяснения ради объяснений. Мы наглядно демонстрируем нашим клиентам и сотрудникам, что делают эти модели и как они помогают нам».

Решения в области машинного обучения: понимание, защита и управление

«За последние несколько лет машинное обучение вышло далеко за пределы исследовательских лабораторий. Из нишевой дисциплины для специалистов по данным с ученой степенью оно превратилось в направление, разбираться в котором сегодня необходимо каждому разработчику», – отмечает Эрик Бойд, корпоративный вице-президент Microsoft Azure AI в Редмонде, штат Вашингтон.

Microsoft создала Azure Machine Learning, чтобы разработчики со специализацией в любой области работы с данными могли создавать и развертывать ИИ-системы. «Сегодня, – говорит Бойд, – от разработчиков всё чаще требуют создание ИИ-систем, работу которых легко объяснить и которые соответствуют нормативным требованиям к конфиденциальности и отсутствию дискриминации».

«Не так просто ответить на вопросы: Действительно ли я оценил справедливость работы своей модели?, Точно ли я понимаю, почему эта модель строит прогнозы так, а не иначе?», — говорит он.

Чтобы преодолеть эти препятствия, сегодня Microsoft анонсировала инновации для ответственного использования машинного обучения, которые помогут лучше понимать поведение моделей машинного обучения, контролировать их, а также обеспечивать конфиденциальность данных в течение всего цикла работы с ними. Новый функционал будет доступен в Azure Machine Learning и в виде открытого кода на GitHub.

Способность понимать поведение модели включает возможности интерпретируемости, которые обеспечивает инструмент InterpretML — именно его использует SAS для распознавания случаев мошенничества в программе лояльности EuroBonus.

Кроме того, Microsoft объявила, что набор инструментов Fairlearn, включающий в себя возможности оценки и повышения объективности ИИ-систем, в июне будет интегрирован с Azure Machine Learning.

Microsoft также анонсировала доступность для разработчиков набора инструментов для обеспечения дифференциальной приватности White Noise. Они могут экспериментировать с открытым кодом на GitHub или использовать его в Azure Machine Learning. Функционал дифференциальных режимов конфиденциальности был разработан в сотрудничестве с исследователями Гарвардского института количественной социологии и Школы проектирования.

Техники дифференциальной приватности дают возможность извлекать выводы из частных данных, предоставляя статистические гарантии, что конфиденциальные сведения — например, имена и дни рождения — останутся под защитой.

Например, благодаря технологии дифференциальной приватности несколько больниц вместе смогут создать более точную прогностическую модель эффективности лечения рака, в то же время соблюдая требования законодательства по защите конфиденциальности медицинской информации и гарантируя, что никакие личные данные пациентов не выйдут за пределы модели.

У Azure Machine Learning также есть встроенные инструменты контроля, позволяющие разработчикам отслеживать и автоматизировать весь процесс создания, обучения и развертывания модели. Эта система, известная как «машинное обучение и операции» (machine learning and operations, MLOps), помогает организациям отвечать различным нормам и требованиям.

«Система MLOps связана с операционными, повторяющимися процессами машинного обучения, — говорит Бойд. — Она позволяет вести учет разнообразных экспериментов, которые я проводил, установленных в них параметров и наборов данных, использовавшихся при этом, и потом использовать их для воссоздания тех же самых процессов».

«Контекстуальные бандиты» и ответственность

В середине 2010-х Сара Берд и ее коллеги из исследовательской лаборатории Microsoft в Нью-Йорке работали над технологией машинного обучения под названием «контекстуальные бандиты» (contextual bandits), основанной на исследовательских экспериментах, предполагающих процесс совершенствования в выполнении отдельных задач в течение времени.

Например, если посетитель новостного сайта кликает на тексты о кошках, «контекстуальный бандит» учится предлагать посетителям больше текстов о кошках. Чтобы продолжить обучаться, «бандит» выполняет новые эксперименты: показывает посетителю тексты о спортивной команде Jacksonville Jaguars («Ягуары из Джексонвилля») и популярном мюзикле «Кошки». То, какую историю в итоге выберет посетитель, дополнит набор данных и поможет в будущем давать более персонализированные рекомендации.

«Это потрясающе: когда технология работает, вы получаете совершенно новый уровень персонализации, — говорит Берд, возглавляющая сейчас подразделение ИИ в Azure AI. — Мы начали общаться с заказчиками и в сотрудничестве с нашей командой продаж искать желающих протестировать эту новую исследовательскую технологию».

Пообщавшись с руководителями по продажам, Берд решила взять небольшую паузу. Когда потенциальные заказчики начали выдвигать идеи использования «контекстуальных бандитов» для оптимизации собеседований и экспертизы страховых исков, она осознала, что многим пока непонятны принципы их работы.

«Я стала спрашивать: этично ли это — проводить эксперименты в таких сценариях?», — вспоминает Берд.

Вопрос вызвал дискуссию с коллегами из подразделения исследовательской группы Microsoft Fairness, Accountability, Transparency and Ethics in AI (FATE, «Справедливость, отчетность, прозрачность и этика искусственного интеллекта») и привел к совместным исследованиям истории экспериментальной этики и потенциальных последствий обучения с подкреплением, типа машинного обучения, лежащего в основе «контекстуальных бандитов».

«Технология достаточно хороша, чтобы мы могли применять ее в реальных кейсах, и если мы выбираем ее в ситуациях, влияющих на жизнь людей, очень важно убедиться, что она справедлива и безопасна», — говорит Берд, полностью сосредоточившаяся на создании инструментов, делающих ответственное машинное обучение доступным для разработчиков.

Хаски, волки и мошенники

За несколько лет стремительно увеличилось количество исследований в области этики ИИ. Объективность и интерпретируемость моделей стали горячими темами главных отраслевых мероприятий, а академические издания пестрят публикациями об инструментах ответственного машинного обучения.

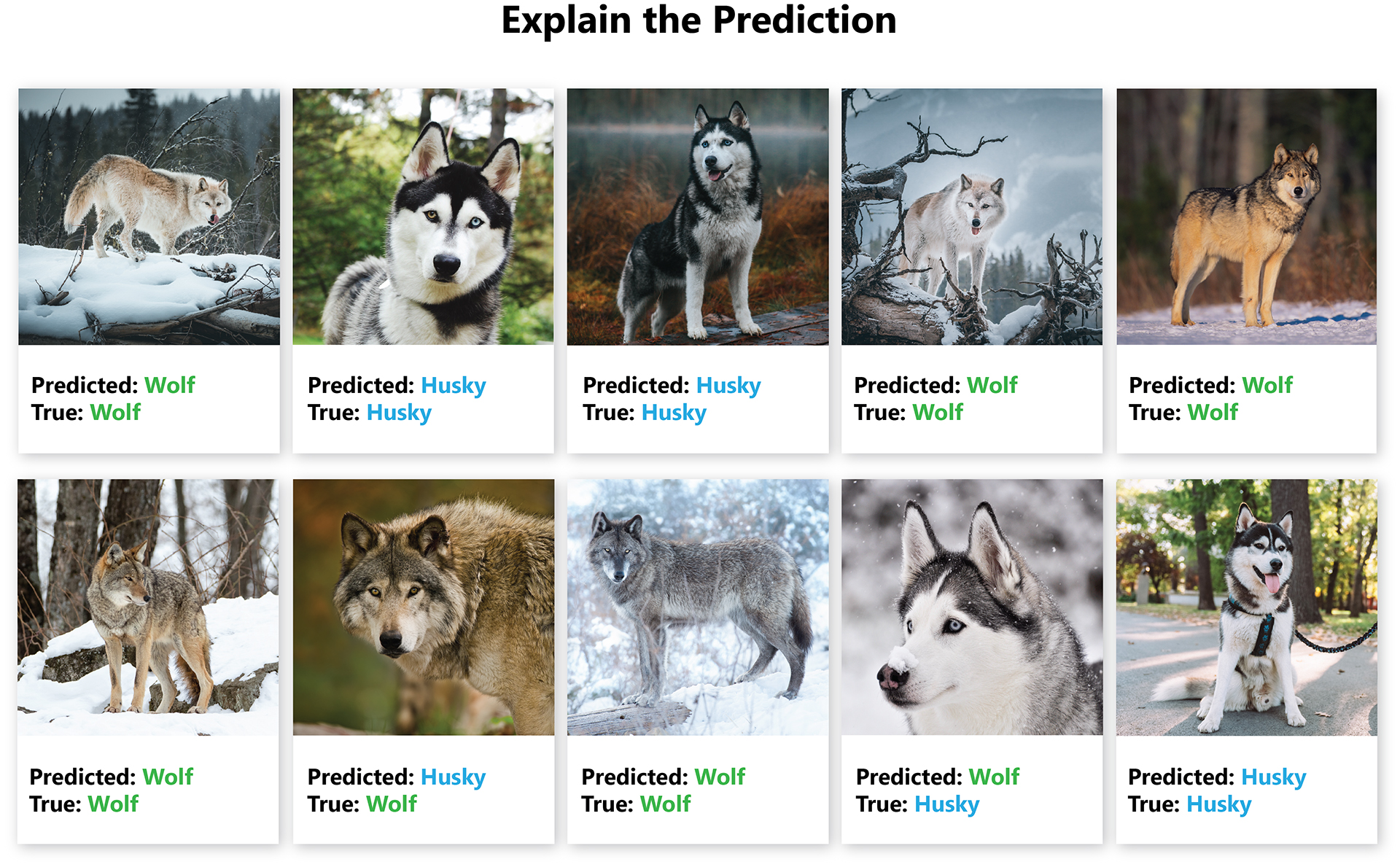

В 2016 году Марко Тулио Рибейро, который сейчас является старшим исследователем лаборатории Microsoft в Редмонде, представил в научном докладе технику, объясняющую принципы работы классификаторов, таких как модели компьютерного зрения, обученные для классификации объектов на фото.

Чтобы показать, как работает эта техника, он обучил классификатор предсказывать, что на фото со снежным фоном будет изображен «волк», а без снега — «хаски». Затем он применил модель на изображениях волков в основном в заснеженных пейзажах и хаски — в основном без снега — и показал результаты экспертам в области машинного обучения, задав два вопроса: «Вы доверяете этой модели?», «Как она строит прогнозы?».

«Многие эксперты сказали, что доверяют модели, и представили теории о том, почему она предсказывает появление изображений с волками или хаски: например, заостренные зубы», –говорит Рибейро. Меньше половины экспертов упомянули фон в качестве потенциального фактора и почти никто не указал на снег.

«Затем я показал им объяснения, и увидев их, разумеется, практически все поняли, что модель ориентируется только по фону, — говорит он. — Это доказывает, что плохая модель способна ввести в заблуждение даже экспертов».

Доработанный вариант техники объяснения Рибейро стал одной из нескольких функций интерпретируемости в Azure Machine Learning — набора инструментов, который отдел по борьбе с мошенничеством SAS применяет в программе лояльности EuroBonus.

С помощью Azure Machine Learning специалисты SAS создали еще два решения на базе ИИ: одно — для прогнозирования объемов продаж билетов, а другое — для оптимизации хранения свежей еды для продажи на рейсах. Решение для оптимизации хранения еды помогло сократить количество пищевых отходов более чем на 60% до того, когда продажи были приостановлены в рамках глобальных усилий по замедлению распространения COVID-19.

Энгберг со своей командой аналитиков и специалистов в области ИИ продолжает создавать, обучать и тестировать модели машинного обучения, проводить новые эксперименты и исследовать возможности Azure Machine Learning в области интерпретируемости и справедливости.

«Думаю, чем больше мы применяем ИИ в вопросах, затрагивающих интересы наших заказчиков или нас как отдельных личностей, тем важнее развивать объективные, прозрачные и ответственные модели ИИ», — говорит Энгберг.

Работа над устранением несправедливости

Коллеги Берд по FATE первыми протестировали многие возможности набора инструментов Fairlearn. Его функционал позволяет разработчикам проверить эффективность модели на группах людей разного пола, цвета кожи, возраста и по другим характеристикам.

«Возможно, вы отлично представляете, что значит «объективность» в контексте практического использования, но, поскольку эти модели столь сложны, вы можете даже не заметить, что они не так справедливы к одним группам людей, как к другим, — объясняет Берд. — Fairlearn позволяет вам обнаруживать эти несоответствия».

EY, глобальный лидер в области страховых, налоговых, транзакционных и консультационных услуг, опробовал функцию определения объективности набора инструментов Fairlearn на модели машинного обучения, которую компания разработала для автоматизированной системы генерации решений по кредитованию.

Модель обучили на данных о рассмотрении ипотечных заявок из банков. Данные включали в себя историю транзакций и платежей, а также информацию из кредитного бюро. Этот тип данных обычно используется для оценки способности и желания клиента выплатить заем. Но вызывает озабоченность его соответствие нормам и требованиям законодательства, а также потенциальная предвзятость в отношении отдельных слоев населения.

EY использовала Fairlearn, чтобы оценить объективность выводов модели применительно к биологическому полу заявителей. Набор инструментов, оценивающий результаты на визуальной интерактивной информационной панели, выявил разницу в 15,3% между позитивными кредитными решениями в пользу мужчин.

Набор инструментов Fairlearn позволил команде специалистов по разработке моделей в EY быстро спроектировать и обучить несколько улучшенных моделей и визуализировать стандартное распределение между справедливостью и точностью модели. В итоге команда выбрала финальную модель, оптимизированную и сохраняющую высокий уровень точности, в которой разница между позитивными решениями для мужчин и для женщин составляет всего 0,43%.

«Возможность для каждого разработчика оценивать уровень предвзятости и снижать его в своих моделях становится ключевой для финансовой отрасли», – отмечает Бойд.

«Мы всё чаще видим пристальное внимание к таким моделям со стороны регуляторов, — говорит он. — Возможность зафиксировать и показать, что она следовала передовым практикам и много работала над повышением уровня нейтральности наборов данных, является ключевым фактором для продолжения работы компании».

Ответственное машинное обучение

Берд считает, что машинное обучение меняет мир к лучшему, добавляя, что каждому разработчику необходимы инструменты и ресурсы для создания моделей, в которых ответственность является приоритетом.

Рассмотрим такой пример. Группа ученых-медиков формирует базы данных пациентов с COVID-19, чтобы спроектировать модель машинного обучения, предсказывающую, кто подвержен серьезному риску осложнений при коронавирусной инфекции.

Берд говорит, что прежде чем развертывать такую модель, разработчики должны понять, как она принимает решения, чтобы объяснить процесс врачам и пациентам. Разработчики также захотят оценить объективность модели, чтобы она фиксировала, в частности, повышенные риски для мужчин.

«Мне не нужна модель, которая никогда не предсказывает высокий уровень риска для мужчин, это было бы ужасно, — говорит Берд. — Затем, разумеется, я хочу, чтобы модель не раскрывала данные людей, использованные для ее обучения, и именно для этого нужна дифференциальная приватность».

Заглавное фото предоставлено SAS.

Материалы по теме

♦ Узнайте подробнее об Azure Machine Learning

♦ Узнайте, как Microsoft поддерживает ответственный ИИ

♦ Больше материалов об ответственном ИИ