De átomos a quarks, al cosmos – Internet de las Cosas ayuda a laboratorio a explorar los orígenes del universo

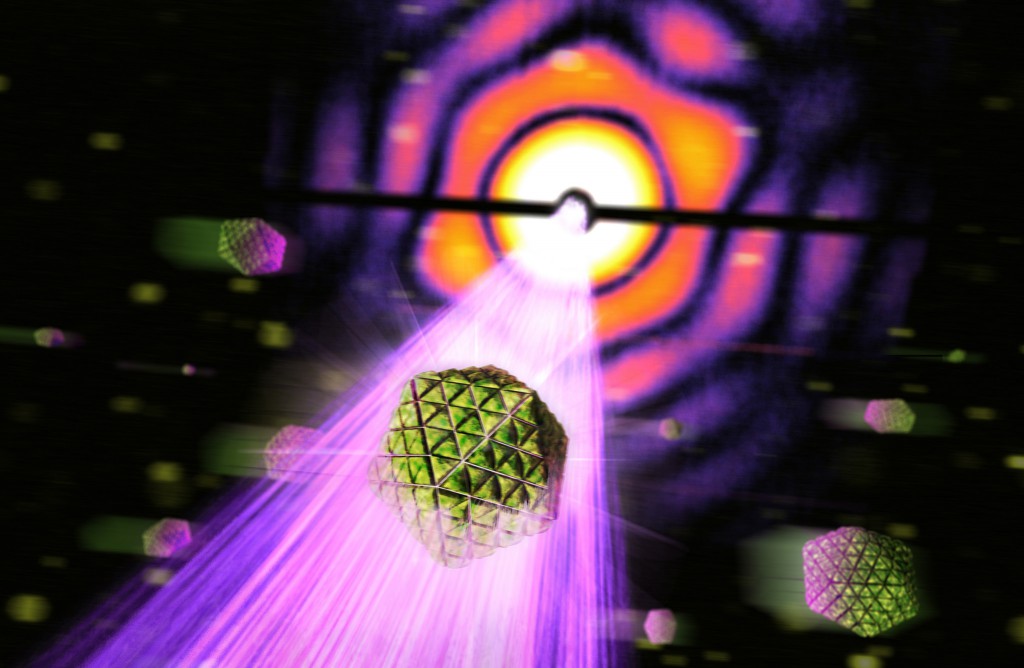

Enclavado en las colinas occidentales de la Universidad de Stanford se encuentra el edificio más largo y recto del mundo – el Laboratorio Nacional del Acelerador de SLAC – un acelerador de partículas de 3.2 kilómetros de longitud, construido en los años sesenta.

En sus 50 años de historia, el SLAC (Centro de Aceleración Lineal de Stanford) ha ayudado a los científicos a descubrir nuevas medicinas, nuevos materiales para la electrónica y nuevas maneras de producir energía limpia. Las investigaciones realizadas ahí han revelado detalles íntimos de átomos, llevado al descubrimiento de bloques de construcción de materia fundamental, y revelado información de valor sobre el origen del universo y la naturaleza de la energía oscura.

Seis científicos han sido reconocidos con Premios Nobel por su trabajo hecho en el centro y más de mil documentos científicos son publicados cada año, basados en investigaciones realizadas ahí. En la actualidad, la Universidad de Stanford opera el SLAC para el Departamento de Energía (DOE, por sus siglas en inglés), uno de los 10 laboratorios de la Oficina de Ciencias de DOE. SLAC corre uno de los rayos laser de rayos X más poderosos del mundo y genera algunos de los datos científicos más valiosos a nivel mundial.

“Debido a que se espera que el rayo funcione 24×7, puede ser considerado como algo de utilidad”, dice Marcus Keenan, gerente de instrumentación y controles para la junta directiva de Instalaciones y Operaciones para SLAC. “Investigadores de todo el mundo vienen aquí y pueden esperar años para tener acceso al rayo; tal vez sólo tengan dos o tres espacios para hacer el trabajo que tienen que hacer”.

Es una parcela de tiempo muy valiosa y si esa utilidad para, la ciencia también. El mayor impacto potencial es la pérdida de ciencia y descubrimiento: “Si un experimento está en proceso, pueden imaginar una situación donde un equipo que haya viajado desde otro país esté cerca de recolectar datos que podrían llevar a un logro científico y el rayo se detiene, esto podría terminar de manera abrupta el experimento. En algunos casos son capaces de recuperar el tiempo, pero en ocasiones tienen que empezar de nuevo”.

Después de décadas de manejar la instalación, el equipo de SLAC ya está bien afinado, pero las fallas inesperadas llegan a suceder. El tiempo de funcionamiento del rayo está estimado en alrededor del 95%, con algunos tiempos de paro agendados durante el año para mantenimiento planeado.

Para continuar con la mejora y asegurar la máxima operación de este recurso científico crítico, las instalaciones de SLAC y algunos grupos de tecnologías de la información colaboran en conjunto para explorar Internet de las Cosas (IoT). El equipo interno trabaja en un plan futuro para tomar datos de todos los sensores inteligentes que monitorean los vastos sistemas en SLAC e ingresar los datos en la nube, donde pueden ser procesados, analizados y entregados de regreso a los ingenieros de control – para que puedan tomar las acciones necesarias antes de que ocurran fallas potenciales.

“Esto personifica el valor de Internet de las Cosas y el aprendizaje de máquina para SLAC”, dice James Williams, CIO de SLAC. “Los sistemas inteligentes nos alertan sobre algún problema antes de que utilicemos los datos del sistema para descubrirlo de manera manual. Esta capacidad se alinea con la estrategia del laboratorio para mantener las instalaciones principales y asegurar que estamos conscientes de manera constante del estado de la salud de la instalación para que podamos maximizar la ciencia”.

Keenan se ha asociado con Mayank Malik, jefe de arquitectura para el cómputo de SLAC, y Jerry Pierre, arquitecto de soluciones para SLAC, en este importante cambio de paradigma para organizaciones e instalaciones típicas de tecnologías de la información – ir de “tener las cosas en funcionamiento” a asegurar que “habilitan la ciencia a través de la habilitación de las tecnologías”.

Controlar las variables a una escala sin precedentes

Pero no solo los paros en el funcionamiento son los que afectan que la ciencia suceda en SLAC. Mantener en funcionamiento un acelerador de partículas de 3.22 kilómetros de largo y 50 años de edad de la misma manera consistente y confiable en que lo hacía el día en que fue construido es tan complicado como suena.

Los sistemas de soporte de las instalaciones están bastante controlados, con decenas de miles de sensores que monitorean cada condición posible. La meta es crear el ambiente más consistente posible – para eliminar cualquier variable posible de la ecuación – para que los resultados obtenidos de los experimentos realizados en la instalación sean tan puros como sea posible.

Es un papel crítico: Algunos experimentos tienen el potencial de consumir hasta tres y medio gigabytes por segundo y los científicos que viajan al SLAC confían en esos datos para realizar su investigación en casa, en ocasiones con un post-procesamiento de datos por años. Las pequeñas cosas visibles como los niveles de energía y temperatura pueden inyectar variables no deseadas que pueden desviar su interpretación e invalidar su investigación.

Algunas de las personas que reportan a Keenan de manera directa trabajan desde un cuarto de control que monitorea los muchos sistemas de soporte para el laboratorio – distribución de energía, control de procesos, calefacción y enfriamiento, automatización del edificio, por sólo nombrar algunas áreas clave. Tan solo los sistemas de energía requieren de un gran esfuerzo: El equipo monitorea 350 medidores sofisticados de energía que ofrecen tendencias en cerca de 100 diferentes parámetros cada uno.

“En resumen, tenemos cientos de miles de dispositivos que están involucrados de alguna manera con el sistema de control de las instalaciones”, menciona Keenan. “Muchos de ellos son críticos, porque de principio a fin, tenemos energía, y hay muchas cosas en el medio que hacen que eso suceda”.

Gracias a que los sensores son cada vez más accesibles y poderosos, la instalación los implementa a una escala mucho mayor que antes, por lo que el equipo requiere monitorear decenas de miles de puntos de datos en tiempo real y ajustar de manera continua los umbrales para mantener un conjunto constante de condiciones. Es un proceso que nunca se detiene, y los operadores lo recorren por completo, sistema por sistema, a diario, mientras observan tablas con 10 a 20 líneas de tendencia en ellas para patrones que podrían desviarse de lo normal. Un proceso que depende mucho de las habilidades y conocimiento del operador – y que es ideal para el aprendizaje de máquina.

“Establecer umbrales de alarma a través de decenas de miles de puntos de datos no es una manera escalable para nosotros de manejar esto”, comenta Keenan. “Toma años, en realidad, ajustarlos bien. Si establecemos parámetros muy ajustados, obtendremos falsas alarmas, si los establecemos muy holgados, es probable que no obtengamos la alarma que necesitamos”.

La visibilidad para tomar un enfoque más inteligente

El volumen actual de datos generados por sensores puede ser abrumador para los ingenieros que utilizan procesos manuales tradicionales, pero no hay duda de que estos también pueden proveer enormes beneficios para que SLAC mantenga constante la instalación masiva. Un proyecto piloto enfocado en uno de los sistemas klistrón de enfriamiento de la facilidad fue lanzado hace poco para tener un mejor uso de estas pesadas fuentes de datos. Al trabajar con Microsoft Open Technologies para modernizar el proceso, SLAC utilizó el proyecto de código abierto ConnectTheDots.io para integrar el diverso conjunto de formatos de sensores de la instalación a la nube con Azure Events Hubs. Luego, los datos son empacados y dirigidos a través de Azure Machine Learning para análisis en tiempo real.

“Lo primero que queremos hacer es obtener información utilizable de los datos que recolectamos”, menciona Keenan. “Hemos recolectados años y años de datos, pero ¿Cuánto de eso podemos llamar información?”

Para el piloto actual, los datos en tiempo real del sistema klistrón de enfriamiento son llevados a través de detección de anomalías de algoritmos. La meta es dar a los operadores una línea base para lo que es normal y lo que no bajo ciertas condiciones. En lugar de tener a los operadores del cuarto de control recorriendo cientos de tablas para buscar patrones, los algoritmos de aprendizaje de máquina hacen el trabajo pesado, lo que permite a los operadores enfocarse en problemas actuales detectados por el sistema.

“La ventaja que obtenemos es que los algoritmos pueden buscar a través de todo al mismo tiempo y sólo regresar las cosas en las que sí debemos enfocarnos, para que podamos tomar la acción necesaria. “Esta es una de las pruebas a menor escala en un sistema klistrón de enfriamiento, y funciona”.

Un ejemplo reciente mostró al equipo qué tan alto es el potencial de poder que tiene la solución: “Tuvimos una falla en el bombeo”, comenta Keenan. “El sistema se cayó, y el rayo se detuvo”.

Al revisar sus datos, hubo un indicador potencial dos días antes – que pudo haber dado un indicio, una pequeña anomalía que pronto regresó a la normalidad.

“Tomé esos mismos datos y los corrí a través del servicio de Azure ML, y el algoritmo identificó la anomalía – en realidad la etiquetó”, menciona Keenan. “Así que en ese escenario, el sistema pudo haber visto la información, y pudimos haber tomado alguna acción para investigar el problema potencial o planear el mantenimiento apropiado”.

De predictivo a proactivo: enseñar a la máquina

La capacidad de ver los problemas antes de que sucedan es solo el inicio. De acuerdo con Keenan, la instalación podría también operar de manera más eficiente al analizar los datos para entender cuándo se necesita en realidad realizar el mantenimiento, en lugar de gastar esfuerzos en volver a ajustar intervalos cuando tal vez no sean necesarios – un proceso que puede ser mejorado de manera importante con el aprendizaje de máquina.

Otro gran reto que se debe enfrentar está en los sistemas tan disparados involucrados en una instalación de 50 años de edad. Conforme las cosas evolucionan, los programas científicos vienen y van, los sistemas son instalados, mejorados y eliminados (o no). Con tantos sistemas críticos en operación a través de 3 kilómetros y cinco décadas, es casi imposible decir cuál depende en cuál. El impacto de perder la interdependencia puede llevar a un rango de consecuencias no deseadas, desde costos adicionales, a tiempos de paro, a incluso de manera potencial, problemas de seguridad.

“Podemos tener algo sucediendo a más de un kilómetro que afecta a otra cosa a más de dos kilómetros de distancia”, comenta Keenan. “Entre mejor entendamos la dependencia entre todos los componentes y los sistemas, mejor vamos a poder colocar los recursos y planear la siguiente mejora. El aprendizaje de máquina será la clave para que mejoremos eso”.

A largo plazo, la meta del equipo colaborativo de instalaciones de tecnologías de la información de SLAC es implementar el aprendizaje de máquina de manera más amplia, tal como los millones de puntos de datos que corren por dentro y por fuera de los sistemas de control. Esto incluye datos que son utilizados para controlar y monitorear el rayo. Se concibe un proceso de aprendizaje continuo, para el “sistema” pueda entender las condiciones y predecir anomalías con una presencia cada vez mayor. Llegar a esto requiere un proceso continuo de recepción de alertas del sistema y entregar información de regreso sobre las causas principales del problema.

“El círculo completo sería cuando tengamos operadores que trabajan en una fila de anomalías y alimentan la inteligencia de regreso al algoritmo sobre qué causó esa anomalía”, comenta Keenan. “Eso coloca a nuestros operadores en el rol de enseñar al sistema, en lugar de su rol actual, donde luchamos por tratar de obtener información de valor sobre lo que sucede y reaccionar a ese problema”.

De esa manera, menciona Keenan, su equipo aprende a escuchar a la máquina, y enseñándole a la máquina a comunicarse con ellos.

“Esa es la meta final”, comenta. “La máquina nos dice qué síntomas tendrán sobre cualquier problema”.

Todo es en nombre de la ciencia y por mantener el rayo en funcionamiento por los siguientes 50 años.