Los nuevos modelos Z-code Mixture of Experts mejoran la calidad y la eficiencia en Translator y Azure AI

Microsoft realiza actualizaciones a Translator y otros servicios de Azure IA impulsados por una nueva familia de modelos de inteligencia artificial que sus investigadores han desarrollado llamada Z-code, que ofrece el tipo de rendimiento y beneficios de calidad que tienen otros modelos de lenguaje a gran escala, pero que pueden ejecutarse de manera mucho más eficiente.

“Nuestro objetivo es ayudar a todas y cada una de las organizaciones del planeta a comunicarse mejor, y para lograr ese objetivo hay dos dimensiones en verdad importantes: queremos que la calidad de las traducciones sea la mejor posible y queremos admitir tantos idiomas como sea posible”, dijo Xuedong Huang, miembro técnico de Microsoft y director de tecnología de Azure AI.

Z-code aprovecha los elementos lingüísticos compartidos en varios idiomas a través del aprendizaje por transferencia, que aplica el conocimiento de una tarea a otra tarea relacionada, para mejorar la calidad de la traducción automática y otras tareas de comprensión del idioma. También ayuda a extender esas capacidades más allá de los idiomas más comunes en todo el mundo a idiomas subrepresentados que tienen menos datos de capacitación disponibles.

“Con Z-code conseguimos un progreso increíble porque aprovechamos el aprendizaje por transferencia y el aprendizaje multitarea a partir de datos monolingües y multilingües para crear un modelo de lenguaje de última generación que creemos que tiene la mejor combinación de calidad, rendimiento y eficiencia que podemos ofrecer a nuestros clientes”, dijo Huang.

Estos modelos utilizan un enfoque escaso de «Mezcla de expertos» (Mixture of Experts) que es más eficiente de ejecutar porque solo necesita involucrar una parte del modelo para completar una tarea, a diferencia de otras arquitecturas que tienen que activar un modelo de IA completo para ejecutar cada solicitud. Esta arquitectura permite una escala masiva en la cantidad de parámetros del modelo mientras mantiene constante la cantidad de cómputo.

Para poner estos modelos en producción, Microsoft utiliza GPU NVIDIA y Triton Inference Server para implementarlos y escalarlos de manera eficiente para una inferencia de alto rendimiento.

De manera reciente, Microsoft ha implementado modelos de Z-code para mejorar las tareas comunes de comprensión del lenguaje, como el reconocimiento de entidades de nombre, el resumen de texto, la clasificación de texto personalizado y la extracción de frases clave en sus servicios de Azure AI. Pero esta es la primera vez que una empresa demuestra de manera pública que puede utilizar esta nueva clase de modelos Mixture of Experts para potenciar los productos de traducción automática.

El nuevo modelo de traducción basado en Z-code ahora está disponible, en un inicio por invitación, para los clientes que utilizan la traducción de documentos en Translator, un servicio cognitivo de Microsoft Azure que forma parte de Azure AI.

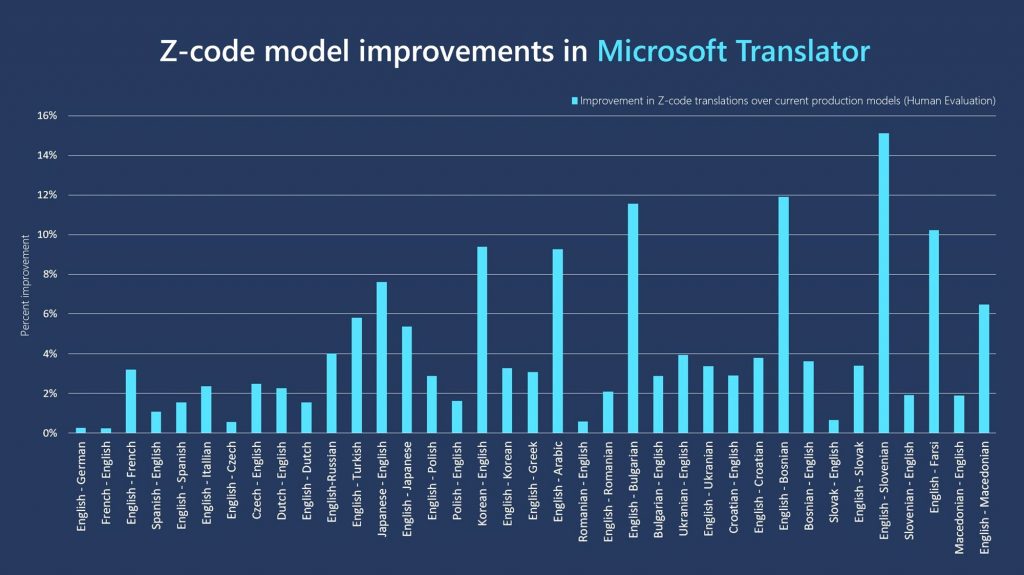

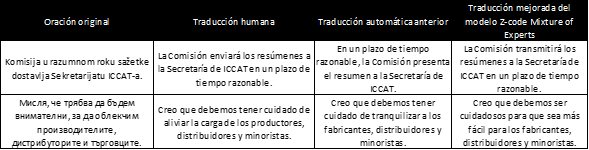

Los modelos de Z-code de Microsoft mejoraron de manera constante la calidad de la traducción en comparación con los modelos de producción actuales, según métricas comunes de la industria. En contraste con los enfoques típicos de aprendizaje por transferencia multilingüe, que por lo general muestran mejoras en la calidad de la IA en idiomas que tienen menos ejemplos de traducción directa disponibles para la capacitación, los modelos de Z-code Mixture of Experts muestran ganancias constantes incluso en los idiomas más grandes.

Evaluadores humanos en una prueba ciega encargada por Microsoft encontraron que los modelos Z-code Mixture of Experts mejoraron las traducciones entre idiomas, con una ganancia promedio del 4%. Por ejemplo, los modelos mejoraron las traducciones del inglés al francés en un 3.2%, del inglés al turco en un 5.8%, del japonés al inglés en un 7.6%, del inglés al árabe en un 9.3% y del inglés al esloveno en un 15%.

Creación de sistemas de IA más potentes e integradores

Z-code es parte de la iniciativa XYZ-code más grande de Microsoft, que busca combinar modelos de texto, visión, audio y múltiples idiomas para crear sistemas de inteligencia artificial más potentes e integradores que puedan hablar, escuchar, ver y comprender mejor a las personas.

En los últimos cinco años, Microsoft ha desarrollado modelos que han igualado el rendimiento humano en reconocimiento de voz conversacional, traducción automática, subtítulos de imágenes, comprensión del lenguaje natural SuperGLUE y respuesta a preguntas de sentido común. Estos avances proporcionan la base para realizar sistemas de IA más ambiciosos que pueden lograr un aprendizaje multisensorial y multilingüe más cercano a cómo las personas aprenden y entienden, dijo Huang.

“Esas son las piezas, los bloques de construcción que utilizamos para construir una inteligencia en verdad diferenciada… y para formar sistemas de producción que sean rentables”, dijo Huang.

Los modelos de Z-code se desarrollaron como parte de las iniciativas AI at Scale y Turing de Microsoft, que buscan desarrollar modelos grandes que se entrenan de manera previa en grandes cantidades de datos textuales para comprender los matices del lenguaje, que pueden integrarse en múltiples productos de Microsoft y también estar disponibles para los clientes para sus propios usos.

El mismo modelo subyacente se puede ajustar para realizar diferentes tareas de comprensión del idioma, como traducir entre idiomas, resumir un discurso, ofrecer formas de completar una oración o generar tweets sugeridos, en lugar de tener que desarrollar modelos separados para cada uno de esos propósitos limitados.

Nuestro objetivo es ayudar a todas y cada una de las organizaciones del planeta a comunicarse mejor, y para lograr ese objetivo hay dos dimensiones en verdad importantes: queremos que la calidad de las traducciones sea la mejor posible y queremos admitir tantos idiomas como sea posible.

Muchos de estos modelos de lenguaje, sin embargo, son tan grandes que puede ser un desafío integrarlos en productos del mundo real. Pero los modelos Z-code Mixture of Experts son lo que se conoce como «dispersos», lo que significa que solo activan una fracción de los parámetros del modelo para realizar una tarea individual, en lugar de involucrar todo el modelo cada vez.

Eso los hace mucho más rentables de operar, de la misma manera que es más barato y más eficiente calentar su casa solo en invierno durante las horas del día que lo necesitan y en los espacios que usan de manera regular, en lugar de mantener un horno en funcionamiento a toda potencia todo el tiempo.

Los investigadores de Microsoft colaboraron de manera estrecha con NVIDIA para implementar modelos Z-code Mixture of Experts en producción por primera vez y en GPU NVIDIA. Con el servidor de inferencia NVIDIA Triton, pudieron implementar estos modelos al utilizar un tiempo de ejecución más eficiente que aprovechó CUTLASS y FasterTransformer para optimizar estos nuevos tipos de modelos. El nuevo tiempo de ejecución pudo lograr una aceleración de hasta 27 veces más que los tiempos de ejecución de GPU no optimizados.

El equipo de Z-code también trabajó en estrecha colaboración con los investigadores de Microsoft DeepSpeed para aprender cómo entrenar de manera eficiente modelos masivos de Mixture of Experts como Z-code, así como modelos de Z-code de tamaño más modesto para escenarios de producción.

“Hemos podido construir este modelo único que puede cubrir una gran cantidad de idiomas y cumplir varias tareas, desde el resumen hasta la generación de texto y la traducción, y ser útil para muchos otros equipos de Microsoft”, dijo Hany Hassan Awadalla, investigador principal y gerente de investigación de Microsoft que ayuda a liderar el desarrollo de modelos de código Z para Traductor y otros servicios cognitivos de Azure.

«Así que trabajamos para difundir esto en toda la compañía y reducir sus costos de implementación, que es la visión de la AI a escala en general», dijo.

Integración de la investigación en los productos de los clientes

Los modelos de Z-code se utilizan en un inicio para impulsar las funciones de traducción de documentos de Translator, que permiten a los clientes traducir documentos completos de Word, PDF, presentaciones de PowerPoint u otros documentos a nuevos idiomas mientras se conserva todo el formato.

Esto se debe a que Z-code se ejecuta de manera más eficiente cuando tiene lotes de oraciones para traducir a la vez, y la traducción de documentos se presta bien para esa tarea, dijo Vishal Chowdhary, gerente de desarrollo de socios de Translator, quien lideró los esfuerzos para convertir un modelo de investigación en algo que podría implementarse en escenarios de producción del mundo real y ponerse a disposición de los clientes.

Antes, Translator necesitaba 20 modelos distintos para traducir entre 10 idiomas: uno de inglés a francés, de francés a inglés, de inglés a macedonio, de macedonio a inglés, etc.

Ahora, un solo modelo de producción de Z-code puede traducir los 10 idiomas desde y hacia el inglés, lo que elimina la necesidad de múltiples sistemas. Los modelos de Z-code de investigación más grandes han podido traducir de manera directa entre 101 idiomas en 10 mil direcciones, sin tener que pasar primero por el inglés.

Las empresas con operaciones internacionales en múltiples mercados a menudo necesitan una forma de mejorar la comunicación entre departamentos con empleados que hablan muchos idiomas diferentes. Los modelos de aprendizaje automático actuales necesitan enormes conjuntos de datos de traducción con dialectos para la capacitación, y es posible que no haya suficientes datos para todos los idiomas y dialectos deseados, en especial en los mercados más pequeños.

La capacidad de compartir conocimientos entre diferentes idiomas permite que Z-code produzca resultados más precisos para idiomas subrepresentados que no tienen una gran cantidad de ejemplos de traducción para aprender. Esto ayudará a mejorar la imparcialidad de la IA y garantizará que las traducciones de alta calidad no se limiten solo a idiomas con abundantes recursos de capacitación, dijo Huang.

“Los 107 idiomas que admitimos en la actualidad podrían cubrir lo que se habla en los Juegos Olímpicos o en las Naciones Unidas”, dijo Huang. “Pero se hablan 7 mil idiomas en todo el mundo y hay muchas comunidades pequeñas que aún no podemos apoyar. Queremos ser multilingües por completo con nuestra IA porque nuestro objetivo es servir a todos los ciudadanos del planeta”.

Contenido relacionado:

- Conozcan más: Proyecto Z-code

- Leer más: Microsoft Translator mejorado con modelos Z-code Mixture of Experts

- Leer más: Una representación holística hacia la IA Integrativa

- Leer más: DeepSpeed impulsa el entrenamiento modelo Mixture of Experts 8 veces más grande con alto rendimiento

- Leer más: Capacitación Mixture of Experts escalable y eficiente para modelos multitarea multilingües

- Leer más: Microsoft Translator

- Conozcan más: Azure Cognitive Services

- Leer más: Hacer que la gente hable: Microsoft mejora la calidad y la eficiencia de la IA en el traductor con NVIDIA Triton

Imagen principal: Vishal Chowdhary, gerente de desarrollo de socios de traductores (izquierda) y el investigador principal Hany Hassan Awadalla (derecha) ayudaron a liderar el equipo de Microsoft que ahora usa modelos de IA de Z-code Mixture of Experts para potenciar las mejoras de traducción automática en Traductor. Foto de Dan DeLong para Microsoft.

Jennifer Langston escribe sobre investigación y desarrollo en Microsoft. Síganla en Twitter.