Reducir el ‘desierto de datos’: Esfuerzos internos para hacer más inclusivos los sistemas de IA para las personas con discapacidades

Saqib Shaikh dice que las personas ciegas, como él, por lo general desarrollan rutinas con una alta organización para mantener un registro de sus cosas: poner las llaves, billeteras, bastones y otros elementos esenciales en los mismos lugares cada vez.

Pero en ocasiones la vida se vuelve desordenada: Un niño necesita ayuda para encontrar su animal de peluche perdido, botes de basura idénticos se mueven en la acera o los abrigos se quedan apilados juntos en una fiesta.

Hoy en día, una persona que utilice la aplicación Seeing AI de Microsoft, puede apuntar la cámara del teléfono hacia una escena, como una mesa de una sala de conferencias, y escuchar una descripción de lo que se encuentra a cuadro: laptops, botellas de agua, cables de energía, teléfonos. Pero en ocasiones, podría ser útil para los algoritmos de aprendizaje automático que impulsan a la app, reconocer objetos que son específicos para esa persona en particular, comentó Shaikh, ingeniero de Microsoft cuyo equipo inventó Seeing AI.

Hasta hace poco, no había datos relevantes suficientes para entrenar a los algoritmos de aprendizaje automático para hacer frente a este tipo de reconocimiento de objeto personalizado para las personas con discapacidades visuales. Es por eso que City, Universidad de Londres, un beneficiario de Microsoft AI for Accessibility, ha lanzado el proyecto de investigación Object Recognition for Blind Image Training (ORBIT), para crear desde cero un conjunto público de datos, a través de videos enviados por personas con ceguera o baja visión.

Los datos serán utilizados para entrenar y probar nuevos algoritmos para reconocer y ubicar objetos personales importantes, que pueden ir desde teléfonos celulares, cubrebocas o utensilios de cocina.

“Sin datos, no hay aprendizaje automático”, comentó Simone Stumpf, profesora principal en el Centro para el Diseño de Interacción Humano-Computacional en City, Universidad de Londres, quien lidera ORBIT. “Y en realidad no ha habido ningún conjunto de datos de un tamaño que cualquier pueda utilizar para introducir un cambio de peso en esta área de IA que es, de manera relativa, nueva”.

La falta de conjuntos de datos de aprendizaje automático que representen o incluyan a personas con discapacidades, es un obstáculo común para investigadores o desarrolladores que trabajan con esas comunidades en el desarrollo de soluciones que puedan asistir con tareas diarias, o en la creación de sistemas de IA que sean menos propensos a magnificar los prejuicios que pueden sesgar la toma de decisiones.

“Estamos en un desierto de datos”, comentó Mary Bellard, líder principal de arquitectura de innovación en Microsoft, quien también supervisa el programa AI for Accessibility. “Existe mucha pasión y energía alrededor de hacer cosas en verdad increíbles con IA y las personas con discapacidades, pero no tenemos datos suficientes”.

“Es como guardar todo en un auto y que listo para partir, pero no tiene gasolina. No tenemos datos suficientes para impulsar esas ideas”.

Para comenzar a achicar ese desierto de datos, los investigadores de Microsoft han trabajado en el último año y medio en investigar y sugerir maneras de hacer más inclusivos los sistemas de IA para las personas con discapacidades. La empresa también financia y colabora con beneficiarios de AI for Accessibility para crear o utilizar conjuntos de datos de entrenamiento representativos, como con ORBIT y la Microsoft Ability Initiative con investigadores de la Universidad de Texas en Austin.

Ahora, Team Gleason ha anunciado que se asocia con Microsoft en Project Insight, el cual creará un conjunto de datos abiertos de imágenes faciales de personas que viven con ALS, para ayudar a avanzar en la innovación de la visión de cómputo y entrenar esos modelos de IA de manera más inclusiva.

Es un problema de toda la industria que no será resuelto por sí solo, por un proyecto u organización, comentó Microsoft. Pero nuevas colaboraciones han comenzado a abordar el problema.

Una hoja de ruta de investigación sobre AI Fairness and Disability (Justicia y Discapacidad en IA), publicada por Microsoft Research, y un taller sobre Discapacidad, Sesgo e IA, organizado en 2019 con el AI Now Institute en la Universidad de Nueva York, encontró una serie de áreas potenciales en las cuales los algoritmos convencionales de IA que no son entrenados en datos inclusivos, no funcionan bien para las personas con discapacidades o pueden dañarlas de manera activa.

Por dar un ejemplo, si a los algoritmos de detección de peatones de un vehículo autónomo, no se les han mostrado ejemplos de personas que utilizan sillas de ruedas o cuya postura o andar es diferente debido a la edad avanzada, es posible que no identifiquen de manera correcta a esas personas como objetos a evitar o estimar cuánto tiempo más necesitan para cruzar con seguridad una calle, señalaron los investigadores.

Los modelos de IA utilizados en los procesos de contratación, que tratan de leer las personalidades o interpretar sentimientos de candidatos potenciales a un empleo pueden leer mal las señales y descartar a candidatos cualificados con autismo o que se emocionan de manera diferente. Los algoritmos que leen escritura a mano tal vez no puedan hacer frente a ejemplos de personas con Parkinson o con temblores. Los sistemas de reconocimiento de gestos podrían confundirse por personas con miembros amputados o por diferentes formas corporales.

Es bastante común que algunas personas con discapacidades sean los primeros en adoptar tecnologías inteligentes, pero a menudo no han estado representadas de manera adecuada en los datos que informan cómo funcionan esos sistemas, comentan los investigadores.

“Cuando las tecnologías son tan deseadas por una comunidad, a menudo están dispuestas a tolerar una tasa más alta de errores”, comentó Meredith Ringel Morris, investigadora senior principal que administra al equipo de Microsoft Research Ability. “Así que, los sistemas imperfectos de IA todavía tienen valor, pero podrían brindar mucho más y trabajar de mejor forma si fueran entrenados con datos más inclusivos”.

‘Impulsar la vanguardia’

Danna Gurari, beneficiaria de AI for Accessibility y profesora asistente en la Universidad de Texas en Austin, tuvo en mente la meta cuando comenzó a desarrollar los conjuntos de datos VizWiz. Estos incluyen decenas de miles de fotografías y preguntas enviadas por personas con ceguera o baja visión a una aplicación que, en un principio, fue desarrollada por investigadores en la Universidad Carnegie Mellon.

Las preguntas son las siguientes: ¿Cuál es la fecha de caducidad de esta leche? ¿Qué dice esta playera? ¿Las puntas de mis dedos se ven azules? ¿Las nubes son de tormenta? ¿El carbón de la parrilla está listo? ¿Cómo es la foto de esta tarjeta de cumpleaños?

En un principio, la aplicación obtuvo respuestas de personas a través de internet, pero Gurari se preguntaba si podía utilizar los datos para mejorar la manera en que los algoritmos de visión de cómputo interpretan fotos tomadas por personas con ceguera.

Muchas de esas preguntas requieren leer textos, como determinar cuánto de un medicamento de venta libre es seguro tomar. La investigación en visión de cómputo a menudo ha tratado esto como un problema por separado, por ejemplo, desde reconocer objetos o tratar de interpretar fotos de baja calidad. Pero describir fotos del mundo real con éxito requiere de un enfoque integrado, comentó Gurari.

Además, los algoritmos de visión de cómputo suelen aprender de grandes conjuntos de datos de imágenes que han sido descargadas de internet. La mayoría son tomadas por personas que pueden ver y que reflejan el interés del fotógrafo, con elementos centrados y en foco.

Pero es probable que un algoritmo que sólo ha sido entrenado en imágenes perfectas, funcione mal en describir lo que hay en una foto tomada por una persona ciega; podría estar borrosa, no estar centrada o retroiluminada. Y en ocasiones, lo que esa persona quiere saber depende de un detalle que una persona que sí puede ver podría no pensar en etiquetar, como si una playera está limpia o sucia.

“A menudo, lo que es significativo para la gente no es obvio, y es por eso que es tan importante no solo diseñar para, sino diseñar esas tecnologías con, personas que forman parte de la comunidad de la ceguera o la baja visión”, comentó Gurari, que también dirige el Grupo de Imagen y Video Computacional de la Escuela de la Información en la Universidad de Texas en Austin.

Su equipo emprendió la enorme tarea de limpiar el conjunto original de datos VizWiz para que pudiera utilizarse para entrenar algoritmos de aprendizaje automático: eliminar imágenes inapropiadas, obtener nuevas etiquetas, limpiar información personal, e incluso traducir preguntas de audio a texto para eliminar la posibilidad de que la voz de alguien pudiera ser reconocida.

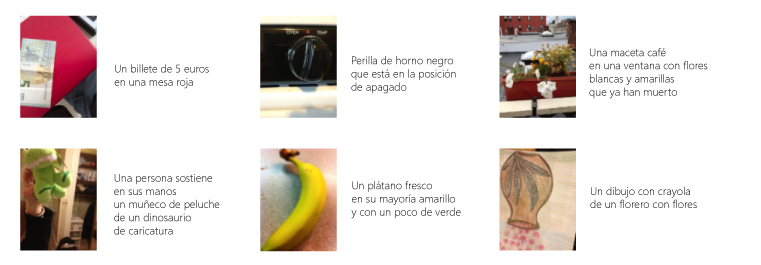

Al trabajar con el financiamiento e investigadores de Microsoft, el equipo de Gurari ha desarrollado un nuevo conjunto público de datos para entrenar, validar y probar algoritmos de subtitulado de imagen. Incluye más de 39 mil imágenes tomadas por participantes con ceguera o baja visión, y cinco posibles subtítulos para cada una. Su equipo también trabaja en algoritmos que puedan reconocer de inmediato cuando una imagen que alguien ha enviado está muy borrosa, oscura o con poca iluminación y sugiere cómo intentarlo de nuevo.

A principios de 2020, Microsoft patrocinó un desafío abierto para otros investigadores académicos y de la industria, para probar sus algoritmos de subtitulado de imagen en el conjunto de datos VizWiz. En una métrica común de evaluación, el algoritmo con mejor desempeño registró una mejora de 33% sobre el anterior algoritmo de vanguardia.

“Esto en verdad empuja hacia adelante la vanguardia en el subtitulado para la comunidad de la ceguera”, comentó Shaikh, el líder de ingeniería de Seeing AI, que trabaja con los beneficiarios de AI for Accessibility y sus conjuntos de datos para desarrollar mejoras potenciales para la aplicación.

El conjunto de datos VizWiz Image Captioning brinda cinco posibles subtítulos para cada imagen, como en esos ejemplos a la derecha de cada foto. Esto ayuda a los algoritmos de visión de cómputo a aprender mejor a reconocer y describir lo que es mostrado en las fotografías enviadas por las personas con ceguera o baja visión. Las fotos están disponibles a través de una licencia Creative Commons 4.0.

Poner a disposición de todos los conjuntos de datos inclusivos

Dado que los sistemas de IA modelan el mundo en función de los datos que les dan, las personas que no reflejan los patrones en los datos pueden ser pasadas por alto o discriminadas de manera activa. Aunque cada vez más, la comunidad de IA ha reconocido y trabajado para mejorar la equidad de estos sistemas cuando se trata de género y raza, las conversaciones sobre ser inclusivos con las personas con discapacidades son mucho más incipientes, mencionaron los investigadores.

Microsoft Research ha lanzado un esfuerzo múltiple para definir el alcance del problema y las vías de mejora: incluido el taller organizado con el AI Now Institute de la NYU el año pasado. El taller convocó a académicos y activistas de la discapacidad, practicantes de aprendizaje automático e investigadores en ciencias de la computación para comenzar a discutir cómo crear sistemas de IA que eviten tratar a las personas con discapacidades casos extremos o valores atípicos.

“Esto en verdad apunta a la cuestión de cómo es definido lo ‘normal’ por los sistemas de IA y quién decide esto”, comentó Kate Crawford, investigadora senior principal en Microsoft Research Nueva York, y cofundadora del grupo Equidad, Responsabilidad, Transparencia y Ética (FATE, por sus siglas en inglés) en IA de la compañía.

Tomen como ejemplo un sistema de contratación predictiva que evalúa entrevistas en video de candidatos al puesto y sugiere cómo debe sonar y verse un empleado “exitoso”, comentó Crawford.

“¿Ha sido entrenado con datos que sugieren que ciertas capacidades o maneras de ser son estándar y por lo tanto, deseables? ¿Las personas con discapacidades o aquellas que son de alguna manera diferentes, se clasifican más bajo para la potencial contratación debido a que difieren de los datos en el conjunto de entrenamiento? Es por esto que en verdad necesitamos estar conscientes de y trabajar en contra”, comentó Crawford.

Para avanzar en esta meta, un área que los investigadores de Microsoft investigan es qué tan a menudo los conjuntos públicos de datos utilizados por lo general para entrenar sistemas de IA incluyen datos de personas mayores de 80 años, porque la edad se correlaciona de manera importante con la discapacidad. Morris y sus colegas también han explorado cómo se podrían ajustar los algoritmos de búsqueda para mejorar los resultados para personas con dislexia.

El pasado verano, Microsoft recibió al experto en tecnologías para la discapacidad, Shaun Kane, un profesor asociado de ciencias de la computación en la Universidad de Colorado Boulder, como investigador visitante para investigar en conjunto cómo los sistemas inteligentes de detección pueden fallar en reconocer o responder de manera apropiada a personas que usan sillas de ruedas o tienen miembros amputados, discapacidades motoras o morfología corporal que caen fuera de los ejemplos en los que han entrenado a esos algoritmos.

A menudo, no es obvio lo que es significativo para las personas, y es por eso que es tan importante no sólo diseñar para, pero diseñar esas tecnologías con, personas que están en la comunidad de la ceguera o la baja visión.

Microsoft y sus beneficiarios también exploran cómo navegar desafíos prácticos y se encuentran en el desarrollo de enfoques éticos para solicitar datos de entrenamiento de IA para personas con discapacidades. Por ejemplo, algunas personas que se preocupan por estigmas o responsabilidades, no quieren revelar su estado de discapacidad, así que mantener la privacidad es primordial.

El equipo de Stumpf revisa cada video enviado al conjunto de datos ORBIT para garantizar que no incluye, de manera inadvertida, información de identificación. También han creado instrucciones detalladas sobre cómo filmar videos de cada artículo, porque necesitan material desde varios ángulos y también quieren que la gente pueda recolectar los datos sin la ayuda de una persona que puede ver.

En la primera fase del proyecto dentro de Reino Unido, el equipo recolectó varios miles de videos, lo que lo hace, por mucho, el más grande conjunto de datos de su tipo. El equipo planea abrir a nivel mundial la segunda fase de la recolección de datos a mediados de octubre de 2020.

“En realidad, todavía estamos en el trabajo de cómo equilibrar la obtención de buenos datos con los que podamos innovar como investigadores y permitir a las personas ser los impulsores de tecnologías que van a utilizar en una manera que no sea muy difícil o que tiene muchas reglas”, comentó Cecily Morrison, investigadora principal en Microsoft Research Cambridge, en Reino Unido. “Si la gente encuentra el proceso difícil o aburrido, van a pensar: ‘la IA no es para mí’”.

Morrison co-dirige Project Tokyo, que se enfoca en cómo la IA puede ayudar a las personas con ceguera o baja visión a dar sentido a sus entornos. Para este fin, ella colabora con el equipo de Stumpf en algoritmos que son capaces de aprender de menos ejemplos, lo que podría tener aplicaciones de gran alcance.

La meta es que el conjunto de datos ORBIT esté disponible de manera pública, comentó Stumpf, para ayudar a hacer mejor la vida diaria en tantas situaciones como sea posible. Por ejemplo, si una persona que es ciega visita la casa de un amigo por primera vez, una aplicación de navegación que se apoye en un sistema GPS sólo puede acercarlas tanto.

“Cuando estás frente a una dirección, todavía necesitas saber si esta es en verdad la casa de tu amigo o la de alguien más”, comentó Stumpf. “Con imágenes de la puerta delantera de tu amigo u otros lugares de interés, podrías utilizar reconocimiento de objeto personalizado para identificar ubicaciones que son en particular importantes para ti”.

Imagen principal: El conjunto de datos VizWiz incluye fotografías tomadas por personas con ceguera o baja visión, como esta imagen de un animal de peluche y un libro en una cama, para entrenar a los algoritmos de visión de cómputo a que brinden información más precisa sobre ellos. Foto disponible a través de una licencia Creative Commons 4.0.

Contenido relacionado:

- Conozcan más: Conjunto de datos Object Recognition for Blind Image Training (ORBIT)

- Conozcan más: Taller VizWiz Grand Challenge 2020

- Conozcan más: Aplicación Seeing AI

- Conozcan más: Grupo Microsoft Research Ability

- Conozcan más: Microsoft AI for Accessibility

- Lean sobre: Disability, Bias and AI

- Lean sobre: Microsoft Ability Initiative: Una búsqueda colaborativa para innovar en el subtitulado de imágenes para personas con ceguera o baja visión

- Lean sobre: ¿Dónde están mis cosas? Desarrollar IA con la ayuda de personas con ceguera o baja visión para satisfacer sus necesidades

- Vean: Diseñar algoritmos computacionales para describir el mundo visual para las personas con ceguera o baja visión (webinar)

Jennifer Langston escribe sobre investigación e innovación en Microsoft. Síganla en Twitter.