다국어 지원, 우수한 성능을 갖춘 Phi-3.5 SLMs의 혁신

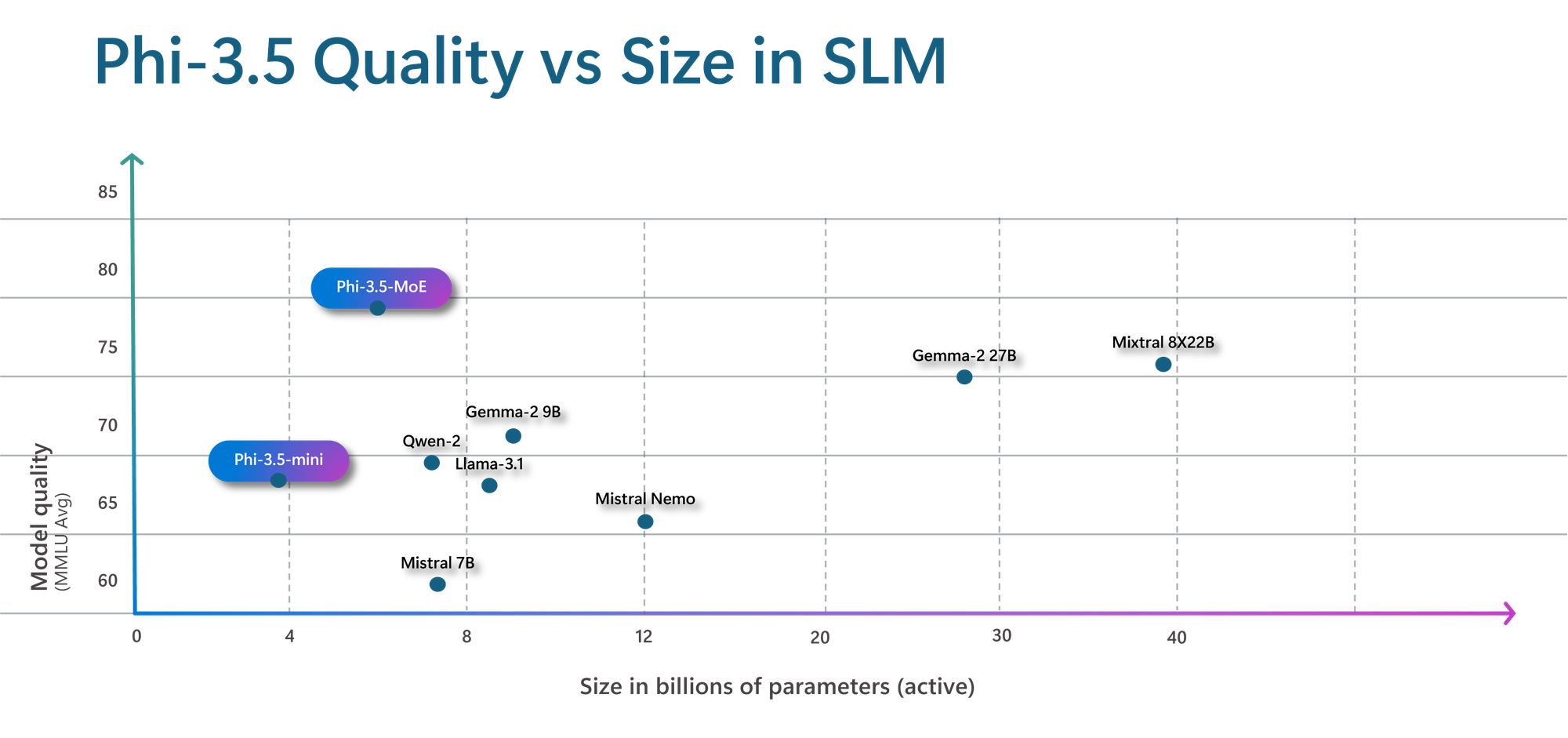

Phi-3모델 컬렉션은 마이크로소프트의 최신 소형 언어 모델(Small Language Models, SLMs) 제품입니다. 이 모델들은 언어, 추론, 코딩, 수학 등 다양한 벤치마크에서 더 큰 모델보다 유사하거나 우수한 성능과 비용 효율을 제공할 수 있도록 설계되었습니다. Phi-3 모델의 도입으로 애저(Azure) 고객들은 고품질 모델에 대한 선택의 폭이 넓어져, 생성형 AI 애플리케이션을 설계하고 구축할 때 더욱 실용적인 옵션을 갖게 되었습니다. 2024년 4월 출시 이후, 고객과 커뮤니티 구성원들로부터 Phi-3 모델에 대한 다양한 피드백을 받았습니다. 이에 마이크로소프트는 Phi-3.5-mini, Phi-3.5-vision, 그리고 새로운 제품인 Phi-3.5-MoE, 전문가 혼합(Mixture of Experts) 모델을 발표하게 되어 자랑스럽게 생각합니다. Phi-3.5-mini는 12만 8천개의 컨텍스트 길이로 다국어 지원을 강화하였으며, Phi-3.5-vision은 멀티 프레임 이미지 이해 및 추론을 개선해 단일 이미지 벤치마크에서 뛰어난 성능을 발휘합니다. Phi-3.5-MoE는 16개의 MoE와 66억 개의 활성 파라미터를 갖춰, 고성능, 지연 시간 단축, 다국어 지원, 강력한 안전 조치를 제공하며, 더 큰 모델보다 효율성을 유지하면서도 뛰어난 성능을 보입니다.

Phi-3.5-MoE: 전문가 혼합 모델(Mixture of Experts)

Phi-3.5-MoE는 Phi 모델 제품에 최근 추가된 모델입니다. 이 모델은 16개의 MoE로 구성되어 있으며, 각 MoE는 38억 개의 파라미터를 포함합니다. 총 모델 크기는 420억 개의 파라미터로, 2개의 MoE를 활성화할 경우 66억 개의 파라미터가 사용됩니다. 이 MoE 모델은 품질과 성능 면에서 비슷한 크기의 고밀도 모델보다 뛰어나며, 20개 이상의 언어를 지원합니다. Phi-3 모델과 마찬가지로, MoE 모델은 오픈 소스와 독점적인 합성 명령어, 선호도 데이터 세트를 결합해 강력한 안전 사후 학습 전략을 구현합니다. 이 사후 학습(post-training) 과정은 사람이 직접 라벨링한 데이터 세트와 합성 데이터 세트를 모두 활용하는 지도 미세 조정(Supervised Fine-Tuning, SFT)과 직접 선호도 최적화(Direct Preference Optimization, DPO)를 함께사용합니다. 이 과정에는 다양한 안전 범주는 물론, 유용성과 무해성에 중점을 둔 데이터 세트도 포함됩니다. 또한, Phi-3.5-MoE는 최대 12만 8천개의 컨텍스트 길이를 지원해, 긴 컨텍스트 작업도 효율적으로 처리할 수 있습니다.

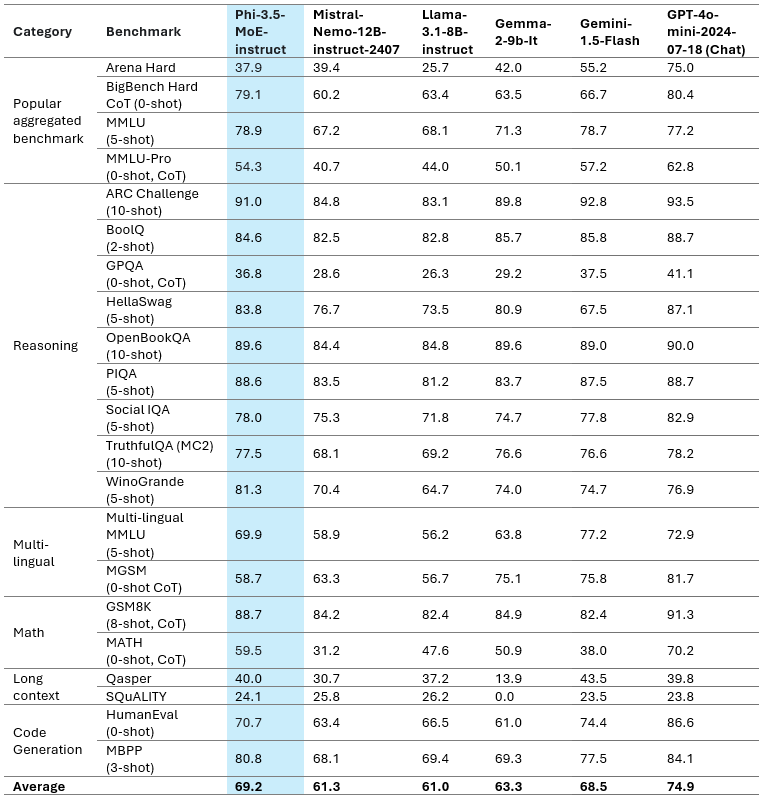

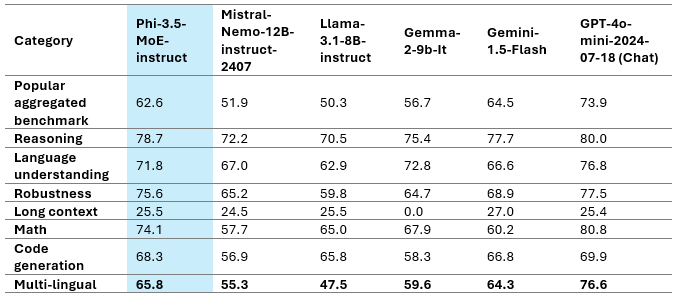

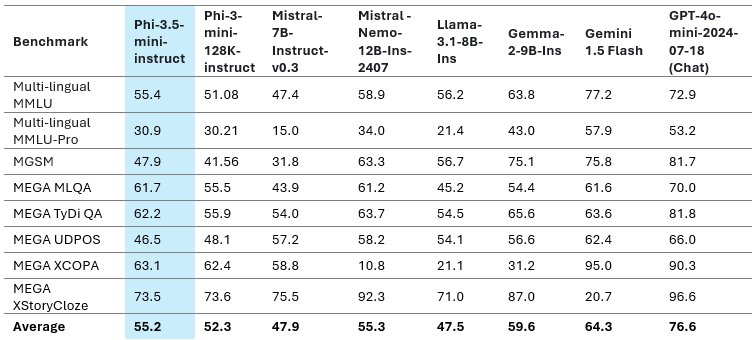

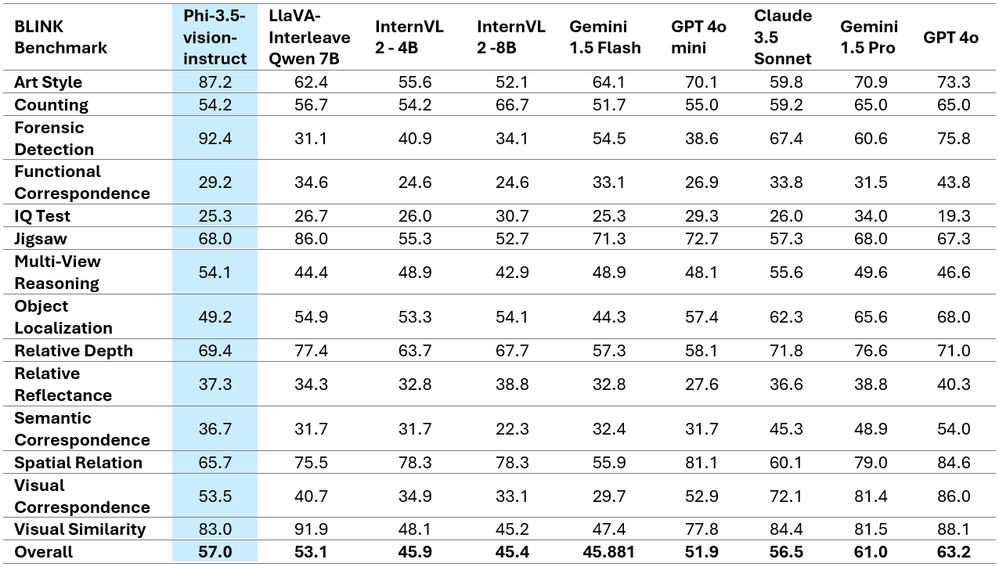

모델 품질을 이해하기 위해 아래 표 1과 같이 다양한 벤치마크에서 Phi-3.5-MoE를 여러 모델과 비교했습니다

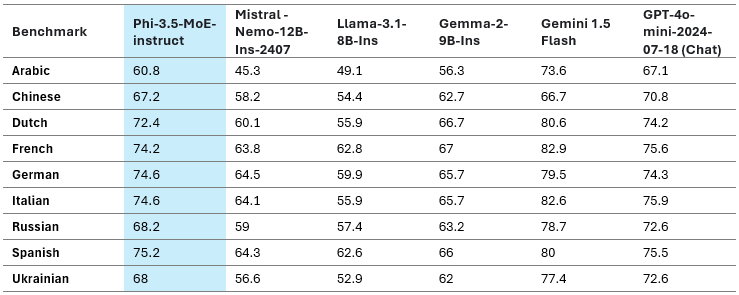

Phi-3.5-MoE는 활성 파라미터가 66억 개에 불과하지만, 훨씬 더 큰 모델과 유사한 수준의 언어 이해 및 계산 성능을 제공합니다. 또한, 이 모델은 추론 능력에서 더 큰 모델을 능가하며, 다양한 작업에 대한 미세 조정에서 뛰어난 효율성을 발휘합니다. 표 3은 Phi-3.5-MoE의 다국어 기능을 보여주는 다국어 대규모 다중 작업 언어 이해(Massive Multitask Language Understanding, MMLU), MEGA 및 다국어 MMLU-pro 데이터 세트의 결과를 나타냅니다. 전반적으로, 이 모델은 66억 개의 활성 매개변수만으로도 훨씬 더 큰 모델과 비교해 다국어 작업에서 매우 경쟁력 있는 성능을 보여줍니다.

Phi-3.5-mini

Phi-3.5-mini 모델은 다국어 합성 데이터와 고품질 필터링 데이터를 사용해 추가 사전 학습을 거쳤습니다. 이후 감독 미세 조정, PPO, 직접 선호도 최적화 등 여러 사후 학습 단계를 진행했습니다. 이 과정에서는 사람이 라벨링한 데이터, 합성된 데이터, 그리고 번역된 데이터 세트가 함께 활용됐습니다.

모델 성능 평가

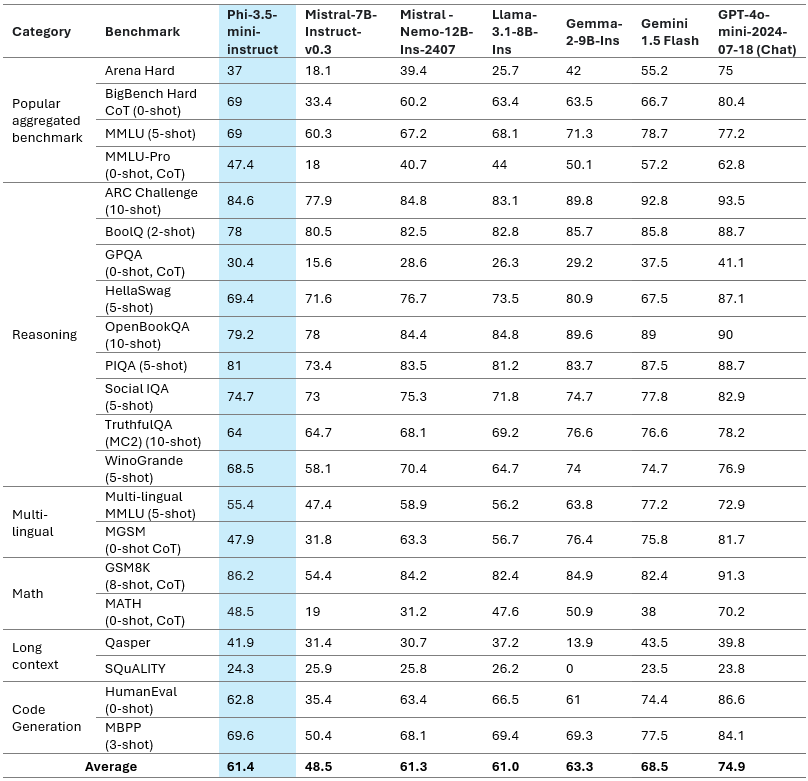

언어 모델의 능력을 자세히 살펴볼 때, 각 모델이 서로 어떻게 비교되는지 이해하는 것이 중요합니다. 이러한 이유로, 우리는 Phi-3.5-mini를 최고 성능을 보이는 대형 모델들과 함께 내부 벤치마크 플랫폼을 활용해 테스트했습니다. 표 1은 주요 벤치마크에서 모델 품질에 대한 간략한 개요를 보여줍니다. 이 효율적인 모델은 3.8억 개의 파라미터에 불과하지만, 더 큰 모델들과 유사한 성능을 제공하며 때로는 그 성능을 능가하기도 합니다.

다국어 지원 능력

Phi-3.5-mini는 마이크로소프트의 최신 38억개 모델의 업데이트 버전입니다. 이 모델은 추가적인 지속적 사전 훈련과 사후 훈련 데이터를 활용해, 다국어 지원, 멀티 턴 대화 품질, 그리고 추론 능력에서 큰 성능 향상을 이루었습니다. 이 모델은 여기에 나열된 언어들을 학습했습니다: 아랍어, 중국어, 체코어, 덴마크어, 네덜란드어, 영어, 핀란드어, 프랑스어, 독일어, 히브리어, 헝가리어, 이탈리아어, 일본어, 한국어, 노르웨이어, 폴란드어, 포르투갈어, 러시아어, 스페인어, 스웨덴어, 태국어, 터키어, 우크라이나어.

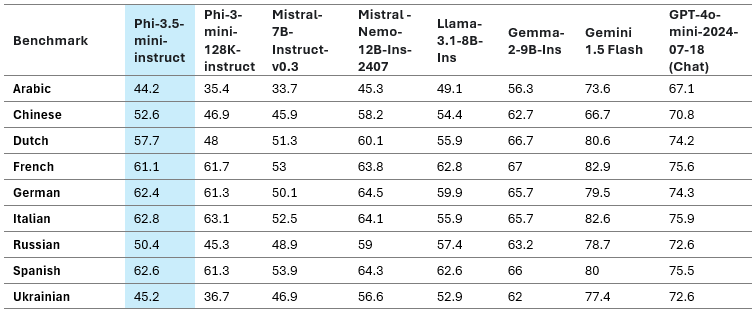

아래 표 6은 Phi-3.5-mini의 다국어 기능을 MMLU, 수학 문제 해결력(Multilingual Grade School Math Bechmark, MGSM), MEGA 및 다국어 MMLU-pro 데이터 세트에서의 평균 언어별 점수를 보여줍니다.

Phi-3.5-mini는 다국어 지원 부문에서 Phi-3-mini보다 크게 개선된 성능을 보여줍니다. 특히 아랍어, 네덜란드어, 핀란드어, 폴란드어, 태국어, 우크라이나어의 성능이 25~50% 향상되며, 새로운 Phi 버전에서 가장 큰 성능 향상이 있었습니다. 종합적으로 볼 때, Phi-3.5-mini는 영어를 포함한 여러 언어에서 80억 미만의 모든 모델 중 최고의 성능을 보여줍니다. 이 모델은 3만 2천 개의 어휘를 사용하며, 위에 언급된 리소스가 풍부한 언어에 최적화되어 있어 추가 미세 조정 없이 리소스가 적은 언어에 사용하는 것은 권장하지 않습니다.

확장된 컨텍스트 처리

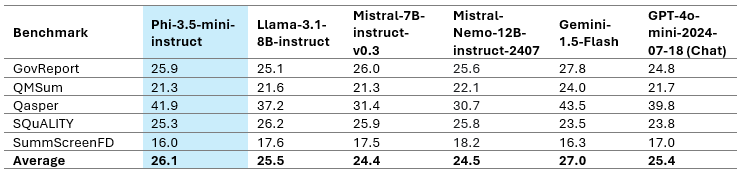

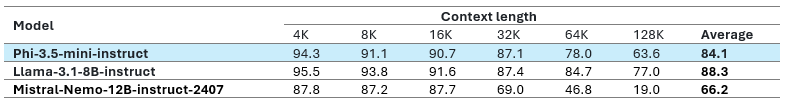

12만 8천개의 컨텍스트 길이를 지원하는 Phi-3.5-mini는 긴 문서나 회의록 요약, 긴 문서를 기반으로 한 QA 및 정보 검색 작업에 탁월한 성능을 발휘합니다. 또한, 8천 개의 컨텍스트 길이만 지원하는 젬마-2(Gemma-2) 제품보다 더 우수한 성능을 제공합니다. Phi-3.5-mini는 라마-3.1-8B-인스트럭트(Llama-3.1-8B-instruct), 미스트랄-7B-인스트럭트-v0.3(Mistral-7B-instruct-v0.3), 미스트랄-니모-12B-인스트럭트-2407(Mistral-Nemo-12B-instruct-2407) 같은 훨씬 더 큰 오픈 웨이트 모델들과 비교해도 경쟁력 있는 성능을 보여줍니다. 표 8에는 다양한 긴 컨텍스트 벤치마크 결과가 포함돼 있습니다.

Phi-3.5-mini-인스트럭트는 38억 개의 파라미터, 12만 8천개의 컨텍스트 길이, 그리고 다국어 지원 기능을 갖춘 유일한 모델입니다. 다양한 작업에서 영어에 최적화된 성능을 유지하면서도 여러 언어를 지원하는 데 중점을 두고 있습니다. 그러나 모델의 용량 제한으로 인해 영어가 다른 언어보다 성능이 더 우수할 수 있습니다. 다국어 지원이 중요한 작업에서는 RAG(Retrieval-Augmented Generation) 설정에서 이 모델을 사용하는 것을 권장합니다.

다중 프레임 입력을 지원하는 Phi-3.5-vision

Phi-3.5-vision은 여러 고객의 피드백을 반영하여 다중 프레임 이미지 이해와 추론을 위한 최첨단 기법을 도입했습니다. 이 혁신적인 기법 덕분에 세부 이미지 비교, 다중 이미지 요약 및 스토리텔링, 비디오 요약이 가능해져 다양한 시나리오에 걸쳐 폭넓게 활용 가능합니다.

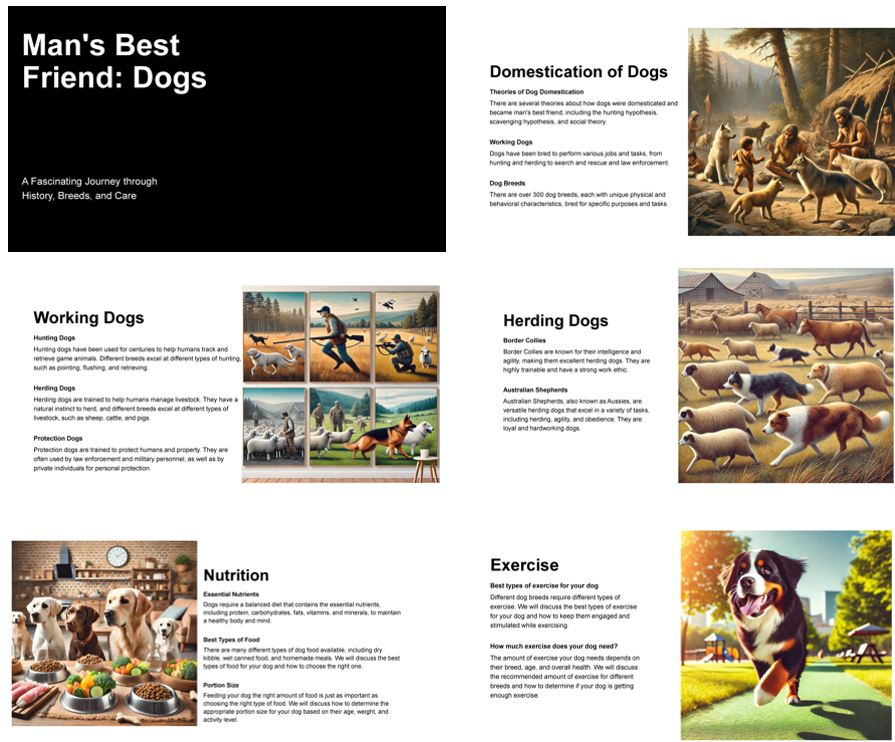

슬라이드 요약에 대한 모델 출력 예시는 다음과 같습니다:

Phi-3.5-vision은 단일 이미지 벤치마크에서 성능이 크게 개선됐습니다. 예를 들어, MMMU 성능이 40.4에서 43.0으로, MMBench 성능이 80.5에서 81.9로 개선됐습니다. 또한, 문서 이해 벤치마크인 TextVQA에서도 성능이 70.9에서 72.0으로 크게 향상됐습니다.

다음 표는 두 가지 다중 이미지와 비디오 벤치마크에서의 성능 비교 결과를 보여줍니다. 다만, Phi-3.5-vision은 다국어 사용 사례에 최적화되어 있지 않으므로, 추가 미세 조정 없이 사용하는 것은 권장하지 않습니다.

안전성

Phi-3 모델은 책임성, 투명성, 공정성, 신뢰성과 안전성, 개인정보 보호와 보안, 포용성이라는 여섯 가지 원칙을 바탕으로 책임 있는 AI 표준(Microsoft Responsible AI Standard)에 따라 개발되었습니다. 이전 모델과 마찬가지로, 다각적인 안전성 평가와 사후 안전 학습, 그리고 다국어 지원을 고려한 추가적인 접근 방식을 도입했습니다. 다양한 위험 범주를 다룬 안전성 학습 및 평가 방법은 Phi-3 안전성 사후 학습 논문(Phi-3 Safety Post-Training Paper)에서 확인할 수 있습니다. Phi-3 모델은 이러한 접근 방식을 통해 안정성을 보장하지만, 개발자들은 각자의 문화적 및 언어적 맥락에 맞춰 위험을 식별, 측정, 완화할 수 있는 책임 있는 AI 모범사례를 적용해야 합니다.

최적화된 배리언츠(Variants)

ONNX Runtime은 Phi 모델에 최적화된 추론을 제공합니다. 현재 다양한 하드웨어 아키텍처에 맞춰 Phi-3.5-mini를 최적화할 수 있으며, 관련 예시는 여기에서 확인할 수 있습니다. 최신 Phi-3.5 모델의 ONNX 파생 모델(Variants)에 대한 추가 업데이트는 몇 주 내에 공개될 예정입니다.

더 신뢰할 수 있는 결과

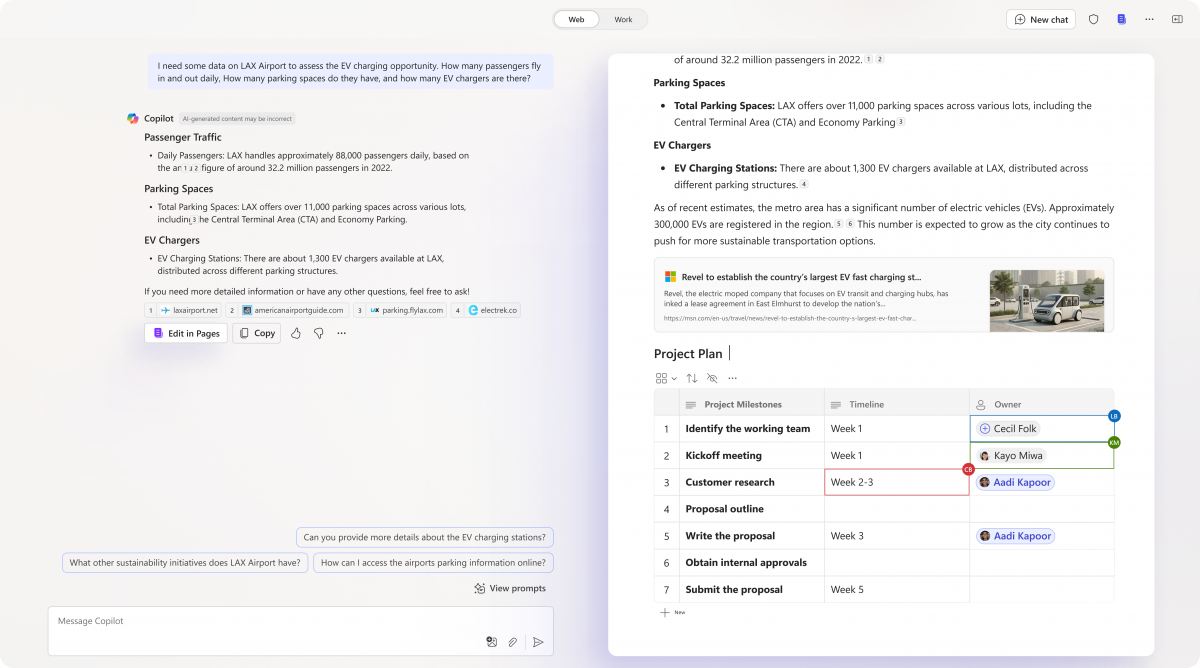

애저 AI 스튜디오(Azure AI Studio)의 Phi-3.5-mini 서버리스 엔드포인트에 가이던스(Guidance) 기능을 도입한 후, 이를 애플리케이션에 적용하여 결과를 예측할 수 있습니다. 가이던스를 활용하면 반복적인 작업을 줄일 수 있으며, 모델이 미리 정의된 목록(예: 의료 코드)에서 선택하게 하거나, 제공된 컨텍스트에서 직접 인용 제한과 정규 표현식(regex)을 따르도록 제약을 설정할 수 있습니다. 가이던스는 추론 스택에서 토큰 단위로 모델의 동작을 조정하여 비용과 지연 시간을 30%에서 50%까지 줄일 수 있으며, 이를 통해 Phi-3-mini 서버리스 엔드포인트에 추가 기능을 제공합니다.

결론

Phi-3.5-mini는 38억 개의 파라미터, 128K의 컨텍스트 길이, 다국어 지원으로 LLM 시장에서 독보적인 제품으로 부상했습니다. Phi-3.5-mini는 광범위한 다국어 지원 성능과 영어에 특화된 성능 사이의 절묘한 균형을 이루는 효율적인 다국어 모델 개발의 이정표가 된 모델입니다. 다만, 모델의 용량이 크지 않아 영어 데이터가 다른 언어보다 더 많이 포함되어 있으므로, 다국어 데이터가 많이 필요한 작업에서는 Phi-3.5-mini를 RAG(Retrieval-Augmented Generation) 설정으로 사용하는 것이 좋습니다. 이 설정은 외부 데이터 소스를 활용해 다양한 언어에 걸쳐 모델의 성능을 향상시키기에, 모델 용량의 한계로 인한 언어적 제약을 극복할 수 있습니다.

Phi-3.5-MoE는 16개의 작은 MoE로 구성되어 있으며, 짧은 지연 시간과 높은 품질을 자랑하고, 128K의 컨텍스트 길이, 다국어 지원과 강력한 안전 조치를 갖추고 있습니다. 이 모델은 더 큰 규모의 모델을 뛰어넘는 성능을 발휘하며, 미세 조정을 통해 다양한 애플리케이션에 최적화할 수 있고, 수억 개의 활성 파라미터를 통해 효율성을 극대화합니다.

Phi-3.5-vision은 다중 프레임 이미지 이해 및 추론 기능을 도입하여 단일 이미지 벤치마크에서 성능을 높입니다.

Phi-3.5 모델은 오픈 소스 커뮤니티와 애저(Azure) 고객을 위해 경제적이면서도 고성능 옵션을 제공하며, 소형 언어 모델과 생성형 AI의 경계를 넓히고 있습니다.