Wir stellen Phi-3 vor, eine von Microsoft entwickelte Produktfamilie offener KI-Modelle. Phi-3-Modelle sind die leistungsfähigsten und kosteneffizientesten kleinen Sprachmodelle (Small Language Models, SLMs) auf dem Markt und übertreffen Modelle der gleichen und nächsthöheren Größe in einer Vielzahl von Sprach-, Argumentations-, Codierungs- und Mathematik-Benchmarks. Diese Version erweitert die Auswahl an qualitativ hochwertigen Modellen für Kunden und bietet ihnen mehr praktische Auswahlmöglichkeiten bei der Erstellung und Entwicklung generativer KI-Anwendungen.

Ab heute ist Phi-3-mini, ein 3.8B Sprachmodell, auf Microsoft Azure AI Studio, Hugging Face und Ollama verfügbar.

-

- Phi-3-mini ist in zwei Varianten mit Kontextlängen von 4K und 128K Tokens erhältlich. Es ist das erste Modell seiner Klasse, das ein Kontextfenster von bis zu 128K Tokens unterstützt, ohne die Qualität zu beeinträchtigen.

- Es ist anweisungsorientiert, was bedeutet, dass es darauf trainiert ist, verschiedenen Arten von Anweisungen zu folgen, die die normale Kommunikation von Menschen widerspiegeln. Dadurch wird sichergestellt, dass das Modell sofort einsatzbereit ist.

- Es ist auf Azure AI verfügbar, um die Vorteile der „deploy-eval-finetune“-Toolchain zu nutzen, und steht Entwickler*innen auf Ollama für die lokale Ausführung auf ihren Laptops zur Verfügung.

- Es wurde für ONNX Runtime mit Unterstützung für Windows DirectML optimiert und bietet plattformübergreifende Unterstützung für Grafikprozessoren (GPU), CPUs und sogar mobile Hardware.

- Es ist auch als NVIDIA NIM Microservice mit einer Standard-API-Schnittstelle verfügbar, die überall eingesetzt werden kann. Und es wurde für NVIDIA-GPUs optimiert.

In den kommenden Wochen wird die Phi-3-Produktfamilie um weitere Modelle ergänzt, um den Kunden noch mehr Flexibilität über die Qualitätskostenkurve hinweg zu bieten. Phi-3-small (7B) und Phi-3-medium (14B) werden in Kürze im Azure AI-Modellkatalog und anderen Modellgruppen verfügbar sein.

Microsoft bietet weiterhin die besten Modelle über die gesamte Qualitätskostenkurve hinweg, und die neue Phi-3-Version erweitert die Auswahl um hochmoderne kleine Modelle.

Bahnbrechende Leistung bei geringer Größe

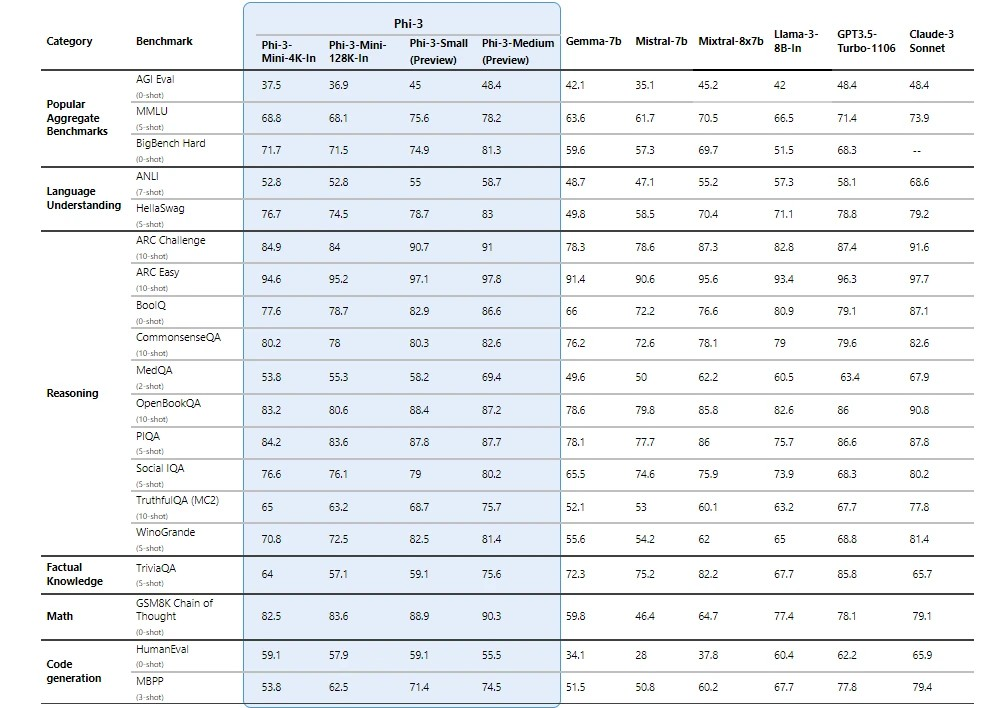

Phi-3-Modelle schneiden bei wichtigen Benchmarks deutlich besser ab als gleich große und größere Sprachmodelle (siehe Benchmark-Zahlen unten; je höher der Wert, desto besser). Phi-3-mini schneidet besser ab als Modelle, die doppelt so groß sind, und Phi-3-small und Phi-3-medium übertreffen viel größere Modelle, einschließlich GPT-3.5T.

Alle angegebenen Zahlen wurden mit derselben Pipeline erstellt, um sicherzustellen, dass die Zahlen vergleichbar sind. Daher können diese Zahlen aufgrund geringfügiger Unterschiede in der Bewertungsmethodik von anderen veröffentlichten Zahlen abweichen. Weitere Einzelheiten zu den Benchmarks finden Sie in unserem technischen Dokument.

Hinweis: Phi-3-Modelle schneiden bei Benchmarks zum Faktenwissen (zum Beispiel TriviaQA) nicht so gut ab, da die kleinere Modellgröße zu einer geringeren Kapazität zur Speicherung von Fakten führt.

Sicherheitsorientierte Modellgestaltung

Die Phi-3-Modelle wurden in Übereinstimmung mit dem Microsoft Responsible AI Standard entwickelt, einem unternehmensweiten Anforderungskatalog, der auf den folgenden sechs Prinzipien basiert: Verantwortlichkeit, Transparenz, Fairness, Zuverlässigkeit und Sicherheit, Datenschutz und Sicherheit sowie Inklusion. Die Phi-3-Modelle wurden einer strengen Sicherheitsmessung und -bewertung, einem sogenannten Red-Teaming, einer Überprüfung der sensiblen Nutzung und der Einhaltung von Sicherheitsrichtlinien, unterzogen, um sicherzustellen, dass diese Modelle verantwortungsbewusst und in Übereinstimmung mit den Standards und bewährten Verfahren von Microsoft entwickelt, getestet und eingesetzt werden.

Aufbauend auf unserer früheren Arbeit mit Phi-Modellen („Textbooks Are All You Need“) werden auch die Phi-3-Modelle anhand hochwertiger Daten trainiert. Sie wurden durch umfangreiches Sicherheitstraining weiter verbessert, einschließlich Reinforcement Learning aus menschlichem Feedback (RLHF), automatischer Tests und Bewertungen für Dutzende von Schadenskategorien. Unser Ansatz für das Sicherheitstraining und die Evaluierung wird in unserem technischen Dokument detailliert beschrieben, und wir erläutern die empfohlenen Verwendungszwecke und Einschränkungen in den Modellkarten. Siehe Modellkartensammlung.

Entfaltung neuer Fähigkeiten

Microsofts Erfahrung mit der Bereitstellung von Copiloten und der Unterstützung von Kunden bei der Transformation ihrer Unternehmen durch generative KI mithilfe von Azure AI hat den wachsenden Bedarf an Modellen unterschiedlicher Größe über die Qualitätskostenkurve für verschiedene Aufgaben deutlich gemacht. SLMs wie Phi-3 eignen sich besonders gut für:

- Umgebungen mit eingeschränkten Ressourcen, einschließlich On-Device- und Offline-Inferenzszenarien.

- An Latenz gebundene Szenarien, bei denen schnelle Antwortzeiten entscheidend sind.

- Kostenbeschränkte Anwendungsfälle, insbesondere solche mit einfacheren Aufgaben.

Weitere Informationen zu kleinen Sprachmodellen finden Sie in unserem Microsoft Source Blog.

Dank ihrer geringeren Größe können Phi-3-Modelle in Umgebungen mit begrenzter Rechenleistung eingesetzt werden. Insbesondere Phi-3-mini kann auf dem Gerät verwendet werden, vor allem wenn es mit ONNX Runtime für die plattformübergreifende Verfügbarkeit weiter optimiert wird. Die geringere Größe der Phi-3-Modelle macht auch die Feinabstimmung oder Anpassung einfacher und kostengünstiger. Darüber hinaus sind sie aufgrund ihres geringeren Rechenbedarfs eine kostengünstige Option mit deutlich besserer Latenzzeit. Das längere Kontextfenster ermöglicht das Erfassen und die Auswertung großer Textinhalte – Dokumente, Webseiten, Code und mehr. Phi-3-mini weist starke logische Fähigkeiten auf, was es zu einem guten Partner für analytische Aufgaben macht.

Unsere Kunden bauen bereits Lösungen mit Phi-3. Ein Beispiel, bei dem Phi-3 bereits seinen Wert unter Beweis stellt, ist die Landwirtschaft, wo das Internet möglicherweise nicht ohne weiteres zugänglich ist. Leistungsstarke kleine Modelle wie Phi-3 zusammen mit Microsoft Copilot-Vorlagen stehen den Landwirten dort zur Verfügung, wo sie sie brauchen, und bieten den zusätzlichen Vorteil, dass sie zu geringeren Kosten betrieben werden können, wodurch KI-Technologien noch leichter zugänglich werden.

Die Phi-Modelle stammen ursprünglich aus der Microsoft-Forschung und werden breit angewandt: Phi-2 wurde über 2 Millionen Mal heruntergeladen. Die Phi-Modellreihe hat durch strategische Datenauswahl und innovative Skalierung eine bemerkenswerte Leistung erzielt. Angefangen bei Phi-1, einem Modell für die Python-Programmierung, über Phi-1.5, das das logische Denken und Verstehen verbessert, bis hin zu Phi-2, einem 2,7-Milliarden-Parameter-Modell, das bis zu 25-fach größere Modelle beim Sprachverständnis übertrifft.¹ Bei jeder Iteration wurden hochwertige Trainingsdaten und Wissenstransfertechniken eingesetzt, um herkömmliche Skalierungsgesetze in Frage zu stellen.

Starten Sie noch heute

Um Phi-3 selbst zu erleben, sollten Sie zunächst mit dem Modell auf dem Azure AI Playground experimentieren. Sie können das Modell auch auf dem Hugging Chat Playground finden. Beginnen Sie mit der Erstellung und Anpassung von Phi-3 für Ihre Szenarien mit dem Azure AI Studio. Besuchen Sie unseren Livestream der AI Show, um mehr über Phi-3 zu erfahren.

¹ Microsoft Research Blog, Phi-2: The surprising power of small language models, December 12, 2023

Den englischsprachigen Originalbeitrag von Misha Bilenko finden Sie hier.

Ein Beitrag von Misha Bilenko

Corporate Vice President, Microsoft GenAI